Puh, also wenn ich mir das alles so anschaue, dann hält sich meine Begeisterung für die 3080 doch mittlerweile arg in Grenzen: Mögliche zukünftige VRAM Knappheit, Holzhammer-Methode, Berichte über Crashes, ein fettes Fragezeichen bezüglich der längerfristigen Auswirkungen der sehr hohen Temperaturen der RAM Bausteine...

Wenn man mich fragen würde, dann sollte mMn jeder Interessent zunächst mal einen großen Bogen um die 3080 machen, anstatt das Ding den Händlern aus den Händen zu reißen. Mir persönlich sind das jedenfalls zu viele Unwägbarkeiten, die mir den Spielspaß mit der 3080 ggf. übelst verderben könnten, um eine 700-800€ Investition guten Gewissens zu rechtfertigen. Da warte ich lieber auf eine 3080 2.0 die dann ausgereift(er) ist und hoffentlich mit 20 GB VRAM daherkommt.

Dann mach das doch, sei mir aber nicht böse wenn ich Dich nicht fragen würde

.

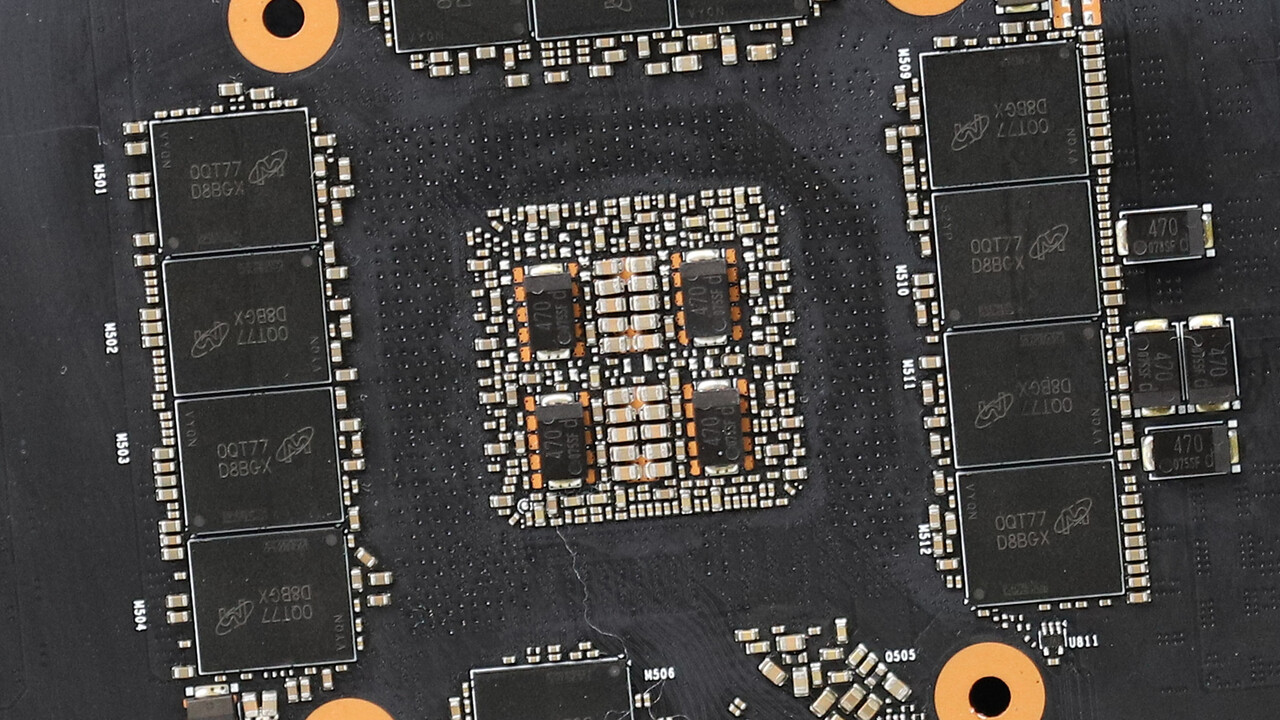

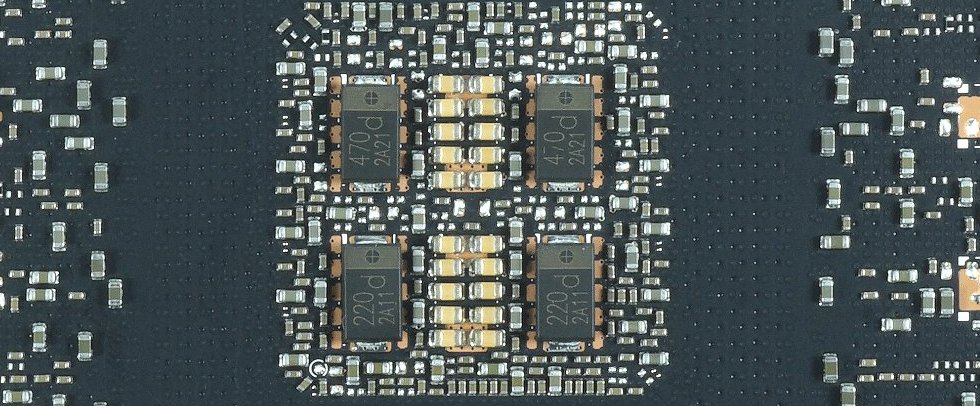

Glücklicherweise gibt es einige Hersteller die von vorneherein auf hochwertige Komponenten gesetzt haben. Die Käufer derer können sich ganz entspannt zurücklehnen.

Davon ab verstehe ich diese unnötige Panikmache nicht, derer man ohne Probleme vorbeugen kann, schon alleine durch vorausschauendes Denken:

Wie viel kann / will ich ausgeben?

Was möchte ich damit tun können / was sind meine Anforderungen an das Produkt?

Wie früh / spät möchte ich das Produkt wieder austauschen?

Ist ja nicht so als ob es da keine Erfahrungswerte geben würde.

Gerade was 4K Gaming betrifft, möchte ich mich selbst mit der 3080 oder 3090 nicht weit aus dem Fenster lehnen. Da interessiert mich noch nicht mal der Speicher sondern eher die Leistung.

Nur weil aktuelle Spiele auf 4K / 60 FPS laufen, heißt das nicht dass es in einem Jahr oder in zwei Jahren wenn die echten NextGen Titel auf dem Markt sind auch noch so ist.

Wenn man keinen Wert auf Max Details legt wird das so sein. Will man das aber sieht es dann schon mau aus.

In dieser Gen ist m.M.n. WQHD das neue FullHD. Guckt man sich die Benches an, gibt es dort kaum FPS Verluste (meist im niedrigen einstelligen Bereich [Edit: Gegenüber Full HD]).

Den aktuellen RTX 30x0 oder den kommenden Big Navi Karten aber zukunftssichere 4K unterstellen zu wollen, selbst mit mehr Speicher, halte ich doch für sehr gewagt.

Wie gesagt, immer unter dem Gesichtspunkt, man möchte immer Max Details und eine hohe FPS Leistung haben.

Wem das egal ist, den stören auch FPS < 60, niedrigere Details, Mikroruckler etc nicht.

.

.

.gif)