Major_Fletcher

Freizeitschrauber(in)

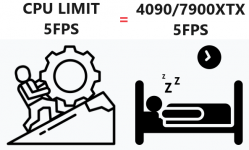

Einerseits mal danke für die ganze Testarbeit die ihr da gerade leistet und andererseits nochmals danke für die ganze Aufklärung, die PCGH und auch viele User hier in den Kommentare immer wieder betreiben.  Ich habe mich mit diesen "Limitierungen" auch noch nie so im Detail beschäftigt allerdings haben einige von euch das hier so toll erklärt, dass ich mir nun fast sicher bin, es nur anhand der Kommentare jetzt endlich verstanden zu haben.

Ich habe mich mit diesen "Limitierungen" auch noch nie so im Detail beschäftigt allerdings haben einige von euch das hier so toll erklärt, dass ich mir nun fast sicher bin, es nur anhand der Kommentare jetzt endlich verstanden zu haben.  (Obwohl ich das gar nicht vor hatte...haha)

(Obwohl ich das gar nicht vor hatte...haha)

Ich habe mich mit diesen "Limitierungen" auch noch nie so im Detail beschäftigt allerdings haben einige von euch das hier so toll erklärt, dass ich mir nun fast sicher bin, es nur anhand der Kommentare jetzt endlich verstanden zu haben.

Ich habe mich mit diesen "Limitierungen" auch noch nie so im Detail beschäftigt allerdings haben einige von euch das hier so toll erklärt, dass ich mir nun fast sicher bin, es nur anhand der Kommentare jetzt endlich verstanden zu haben.  (Obwohl ich das gar nicht vor hatte...haha)

(Obwohl ich das gar nicht vor hatte...haha)

Viel Spaß beim rätseln!

Viel Spaß beim rätseln!