- Foren

- Spiele

- Rollenspiele und (Action-)Adventures [Diablo, Minecraft, TES, The Witcher]

- News-Kommentare zu Rollenspielen und Adventures

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Special Cyberpunk 2077 Phantom Liberty im Tech-Test: 60 Prozessoren im größten PCGH-Benchmark-Vergleich!

- Ersteller PCGH-Redaktion

- Erstellt am

blautemple

Kokü-Junkie (m/w)

Mal eben so geht das nicht. Du musst zusätzlich auch immer noch den 3D Cache Optimizer loswerden. Das ist leider super umständlich von AMD gelöst.Man mus auf nix hoffen. Wenn einem der Unterschied bei Cyberpunk wichtig ist (zwischen 7800X3D), dann schaltet man eben für das Game einen CCD ab. Ist genau das gleiche (und weniger arbeit) wie die ganzen Intelianer, die behaupten sie benutzen alle UV - Settings.

Drayygo

BIOS-Overclocker(in)

Ich behaupte einfach mal frech, dass es dennoch weniger Aufwand ist, als ein stabiles, gutes UV Setting zu finden.Mal eben so geht das nicht. Du musst zusätzlich auch immer noch den 3D Cache Optimizer loswerden. Das ist leider super umständlich von AMD gelöst.

Und wenn die Intelianer anbringen dürfen (was ja auch legitim ist), dass deren CPUs alle super sparsam sind, weil die alle UV benutzen - dann darf ich meinen AMD auch optimieren

Und wenn die Intelianer anbringen dürfen (was ja auch legitim ist), dass deren CPUs alle super sparsam sind, weil die alle UV benutzen - dann darf ich meinen AMD auch optimieren

facehugger

Trockeneisprofi (m/w)

Die sich in meiner Stromrechnung wie genau bemerkbar macht? Mein 13600k verbrät etwa 90-100W (gerne auch mal weniger) beim daddeln, ein 7800X3D etwa 65W? Ich zogge KEINESFALLS 24/7 (wer macht das schonWer sich trotz der X3D CPUs für Raptor Lake entscheidet macht das bewusst und nimmt die höhere Leistungsaufnahme in Kauf

).

).Daher, öfters mal die Kirche im Dorf lassen...

Gruß

Zuletzt bearbeitet:

blautemple

Kokü-Junkie (m/w)

Joa, ich wollte nur, nachdem ich mich vor kurzem damit rumschlagen durfte, klarstellen dass das leider alles andere als schnell und einfach geht. Mit der Lösung hat AMD sich leider nicht mit Ruhm bekleckert…Ich behaupte einfach mal frech, dass es dennoch weniger Aufwand ist, als ein stabiles, gutes UV Setting zu finden.Und wenn die Intelianer anbringen dürfen (was ja auch legitim ist), dass deren CPUs alle super sparsam sind, weil die alle UV benutzen - dann darf ich meinen AMD auch optimieren

Atma

PCGH-Community-Veteran(in)

Oder öfters mal alles lesen um den Kontext zu verstehen ...Daher, öfters mal die Kirche im Dorf lassen...

facehugger

Trockeneisprofi (m/w)

Kontext? Klar, AMD`s X3D-CPU`s sind effizient(er). Aber Raptor Lake deswegen als Stromschlucker oder Geldvernichter (beim daddeln) zu bezeichnen ist mehr wie irreführend...Oder öfters mal alles lesen um den Kontext zu verstehen ...

Und die paar € Differenz im Jahr sind in meinen Augen lächerlich und nehme ich gerne in Kauf

Gruß

Atma

PCGH-Community-Veteran(in)

Der große "Aufreger" ist das 13900K Dickschiff mit über 220 Watt Leistungsaufnahme in Cyberpunk bei Stock Settings. Dagegen steht mit fast identischer Performance der 7800X3D bei gerade mal 64 Watt. In anderen Zahlen ausgedrückt bedeutet es, der 13900K zieht 248% mehr Strom. Das war der Kontext.Kontext? Klar, AMD`s X3D-CPU`s sind effizient(er). Aber Raptor Lake deswegen als Stromschlucker oder Geldvernichter (beim daddeln) zu bezeichnen ist mehr wie irreführend...

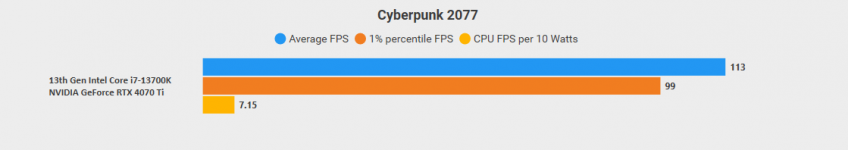

Klar ist der 13600K deutlich genügsamer, zieht am Ende aber immer noch über 100% mehr Saft aus der Steckdose als der 7800X3D. Mit weniger Takt (5 GHz auf den P-Cores, 4 GHz auf den E-Cores) und UV bekomme ich meinen 13900KS auf 80-110 Watt in Cyberpunk. Das ist in meinen Augen eine beachtliche Senkung der Leistungsaufnahme, reicht aber trotzdem (wie erwartet) nicht an den 7800X3D ran. Deswegen äußerte ich wer sich trotz der X3D CPUs für Raptor Lake entscheidet, tut das bewusst und nimmt die höhere Leistungsaufnahme in Kauf.

Der Sommer neigt sich inzwischen zwar dem Ende zu, doch gerade in der Jahreszeit entscheidet jedes Watt wenn es darum geht die Bude nicht unnötig aufzuheizen

blautemple

Kokü-Junkie (m/w)

Setting und Szene kannst du hier einsehen:Vermutlich nicht ganz die gleichen Settings usw. aber trotzdem evtl interessant.

Benchmark-FAQ 2023 (CPUs): 11 Spiele + 6 Anwendungen inklusive Anleitung und Savegames

Auf dieser Seite sehen Sie alle Spiele, die PCGH für die CPU-Tests verwendet. Die Einstellungen entnehmen Sie bitte dem Video auf Seite 1.

Da gibt es dann auch das entsprechende Savegame.

Esenel

Freizeitschrauber(in)

Der Sommer neigt sich inzwischen zwar dem Ende zu, doch gerade in der Jahreszeit entscheidet jedes Watt wenn es darum geht die Bude nicht unnötig aufzuheizen

Klimaanlage.

Energie mit noch mehr Energie bekämpfen

Chaddy

Komplett-PC-Aufrüster(in)

5600X3D im Test, die kein Mensch hat, aber der Topseller 5600X ist nicht mehr dabei?

Der neuere 5600 ohne X ist dabei. Der unterscheidet sich nur unwesentlich von Modell mit X. Der wesentlichste Unterschied sind 200 MHz weniger Takt, was in der Praxis aber nur einen minimalen Unterschied macht - folgerichtig ist er in der Benchmark-Bestenliste auch nur 2 Prozentpunkte langsamer.

Das, was Chaddy sagt. Ansonsten steht es geschrieben: Ich habe alle CPUs getestet, die mir zur Verfügung standen. Logischerweise fehlen dann CPUs, die ich nicht zur Hand hatte. Warum glauben eigentlich immer alle, dass PCGH alle Prozessoren der Welt im Schrank liegen hat? So ist es leider nicht.5600X3D im Test, die kein Mensch hat, aber der Topseller 5600X ist nicht mehr dabei?

owned139

BIOS-Overclocker(in)

Ja, aber nur dort. Seit wann ist hier Cherrypicking der Goldstandard?Der große "Aufreger" ist das 13900K Dickschiff mit über 220 Watt Leistungsaufnahme in Cyberpunk bei Stock Settings.

Nathenhale

Volt-Modder(in)

Naja nicht wirklich, sobald die CPU halt was (viel) arbeiten muss verbraucht diese halt viel Strom.Ja, aber nur dort. Seit wann ist hier Cherrypicking der Goldstandard?

Immer wenn du im CPU limit hängst und das Spiel mehr als 1 Kern Nutzt gönnen sich die Intels halt.

Im schnitt sind es laut Dave 155 Watt.

AMD Ryzen 9 7950X3D im Test: Der Gipfel der CPU-Entwicklung [Update zum Verkaufsstart]

Diese Seite beschäftigt sich mit der Leistungsaufnahme aller Prozessoren im Test. Mithilfe eines Hardware-Tools messen wir die Leistungsaufnahme der CPU allein, mit Einflussnahme der Spannungswandler auf dem Mainboard. Dazu geben wir die "rohen Watt" im Schnitt als Fps pro Watt an.

119 Watt.

Neuer_User

BIOS-Overclocker(in)

Was ich wirklich hätte spannend gefunden wäre ein FX 8350 im Vergleich. Vielleicht hätte der alte Achtkerner in diesem Spiel endlich mal die Intel Vierkerner überflügelt. Nict, dass es noch relevant gewesen wäre, aber eine nette Randnotiz. Aber natürlich könnt ich nicht alles da haben. Wie auch. 60 CPU ist schon ein unerträglicher Aufwand. Wieviele Praktikanten hattest Du denn zum Umbauen?Warum glauben eigentlich immer alle, dass PCGH alle Prozessoren der Welt im Schrank liegen hat? So ist es leider nicht.

Ich bin mir jetzt nicht so ganz sicher, aber PCGH enthält glaube ich nicht nur KIs, sondern stellenweise auch Menschen.5600X3D im Test, die kein Mensch hat

Und weißt Du mit Sicherheit, dass der 5600X3D nicht doch noch kommen wird? Und wenn er dann kommt, kann man ihn gleich einordnen. Es wäre, einen sinnvollen Preis annehmend, eine grandiose Aufrüstung für Sparfüchse, die noch mit 1600er rumdümpeln

Niemanden, was denkst du denn? Das hab ich alles allein gemacht. FX-CPUs haben wir noch da, aber die sind inzwischen alle teildefekt und unterstützen nur noch Single-Channel-Speicher. Es wäre aber so oder so unspielbar auf den alten Kamellen gewesen, da hätten auch 32 Kerne nichts mehr gebracht.Wieviele Praktikanten hattest Du denn zum Umbauen?

Drayygo

BIOS-Overclocker(in)

Mhmmmmm... Aber n FX9590 wäre n guter Vergleich zum 13900KS gewesen. Also beim Wattmeter-Benchmark.Niemanden, was denkst du denn? Das hab ich alles allein gemacht. FX-CPUs haben wir noch da, aber die sind inzwischen alle teildefekt und unterstützen nur noch Single-Channel-Speicher. Es wäre aber so oder so unspielbar auf den alten Kamellen gewesen, da hätten auch 32 Kerne nichts mehr gebracht.

Braucht ihr noch n funktionalen FX? Ich hab noch meinen alten 8320e hier rumliegen - den kann ich euch zuschicken

Ich hab nichts gegen (CPU-)Geschenke, aber der Nutzen hält sich halt sehr in Grenzen. So eine CPU testen wir manchmal nur noch bei Spielen, die extrem anspruchslos sind, ansonsten kann man mit so einem Teil nichts mehr machen. Wer ernsthaft versucht, damit CP 2077 mit Raytracing zu spielen, hat die Kontrolle über sein Leben verloren.

Drayygo

BIOS-Overclocker(in)

Dir ist klar, dass ich jetzt testen muss, ob das Game überhaupt startet? Muss mal gucken, ob ich irgendwo im Schrank noch n MB dafür hab.Ich hab nichts gegen (CPU-)Geschenke, aber der Nutzen hält sich halt sehr in Grenzen. So eine CPU testen wir manchmal nur noch bei Spielen, die extrem anspruchslos sind, ansonsten kann man mit so einem Teil nichts mehr machen. Wer ernsthaft versucht, damit CP 2077 mit Raytracing zu spielen, hat die Kontrolle über sein Leben verloren.

Ich geh mir mal fix meine Jogginghose anziehen - so ganz nach dem Motto: Wenn schon Kontrolle verlieren, dann aber richtig.

Ähnliche Themen

- Antworten

- 5

- Aufrufe

- 465

- Antworten

- 76

- Aufrufe

- 5K

- Antworten

- 1

- Aufrufe

- 689

- Antworten

- 109

- Aufrufe

- 9K

- Antworten

- 77

- Aufrufe

- 5K

G