Nein tut sie nicht. Du definierst im Treiber nur welche Auflösungen dir das Spiel in den Grafikeinstellungen zur Auswahl anbieten kann/darf

Du musst immer noch aktiv im Spiel die entsprechende Auflösung auswählen.. genau wie bei AMD auch.

Leider nicht! Im NVidia Treiber-Tool gibst Du nicht die Auflösung an, sondern den DSR-Faktor der Desktop-Auflösung. Ich bin gerade im NVidia Treiber-Tool und:

a) Ich kann den DSR Faktor für alle Spiele festlegen, aber nur laut Desktop-Auflösung.

Damit wird der Treiber alle Auflösungen einfach um den Faktor vergrößern, was ich doch gar nicht möchte, weil es Hirnverbrannt ist. Ich muss doch die genaue Auflösung, nativ oder Downsampling steuern können.

b) Ich kann den DSR Faktor für ein einzelnes Spiel festlegen.

Was total kompliziert ist, weil ich das im Spiel dann nicht erkennen kann. Ich muss also immer genau wissen, was im Treiber-Tool eingestellt ist.

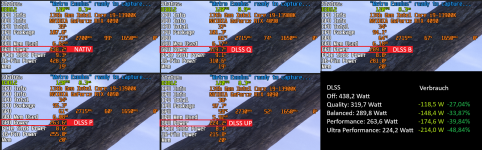

Der Unterschied ist AMD berechnet die virtuelle Auflösung als wäre es eine echte.. und Nvidia nutzt dafür den DLSS Algorithmus ausgehend von der original Auflösung

Ja genau, das ist seitens NVidia leider bescheuert umständlich und unübersichtlich.

Aus diesem Grund nutze ich bei NVidia Karten eigene definierte Monitorauflösungen, weil das mit DSR komplizierter Unsinn ist und überhaupt keinen Performancevorteil bringt. Das ist quasie ein unnützes Feature.

Bei AMD aktiviere ich das Häkchen mit VSR und Tadaa: Ich kann im Spiel mit der Auflösung direkt hochgehen, als hätte ich ein Display, das mehr als nativ darstellt. Wie geil ist das denn?

Zur Erinnerung: Bei NVidia erreiche ich diesen Zustand erst mit der Bildschirm-Option: Benutzerspezifische Auflösung erstellen. Erst dann darf ich auch im Spiel bequem die Auflösung einstellen, mit der ich das Spiel spielen möchte. Diese Auflösung muss man händisch erstellen und man darf keine falschen Werte eingeben. Ansonsten müsste ich jedes mal das Spiel verlassen und dann im NVidia Treiber-Tool den DSR-Faktor ändern. Total umständlich und seitens NVidia ein beschissenes Feature.

p.s. Ok, Thema geklärt. Mit dem NVidia Tool läuft das mittlerweile so wie bei AMD.

@Blackfirehawk: Vielen Dank für Deine ausführliche Info.

Das wurde mit der Zeit wohl bei NVidia angepasst.

. Dann wäre man auch, was DLAA betrifft, nie mehr an Implementierungen in Spielen seitens Entwickler gebunden, sondern könnte es immer selbst erzwingen, quasi via DL-DSR x1,00.

. Dann wäre man auch, was DLAA betrifft, nie mehr an Implementierungen in Spielen seitens Entwickler gebunden, sondern könnte es immer selbst erzwingen, quasi via DL-DSR x1,00.