Ich hab zwar @hanfi104 geantwortet,,,aber gut.

Ich weiß jetzt nicht was Du mit Realität und Markt da draussen meinst? Einen Markt muß es wohl geben, sonst hätte Intel ja nichts verkauft

Ja, war bisschen zu schnell dahingeschwurbelt. Ich meinte, mit Hinweisen wie

ist kein Ding kann man im Bios xy umstellen kein Argument für das RL ist.

2017 hatte Intel mit dem SkylakeX eben die performanteste Lösung, wenn es um 4K HEVC ging.

Das ist in Ordnung. Ich meitne das obige wie gesagt eher auf die Massen bezogen. Selbst auf die, die den Weg ins Bios finden können.

Was schätzt man überhaupt so wie viele Leute sich mit umkodieren von Videomaterial beschäftigen? Immer wenn es in Threads irgendwann um SIMD geht, hab ich das Gefühl die ganze Welt macht zu 60% nichts anderes am PC als Videos zu recodieren und ich selbst nicht in einer Foren-, sondern in einer RL-Blase lebe. Niemand für den ich je ein PC gebaut habe wollte/will damit Videos umwandeln. Ich hab irgendwie das falsche Umfeld, auch das weitläufigere, um mir über AVX Gedanken zu machen.

Oder eben die CPU unsinniger Weise und völlig unnötig runtertakten lassen, nur weil der Nvidia Treiber AVX 2 triggert [...]

Ab wann ist das überhaupt so? Das find ich jetzt garnicht so uninteressant

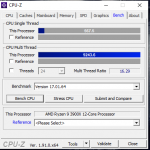

Der i9 durchläuft mit @4.6GHz 1.225v die Benches die AVX2 nutzen. Warum soll er dann in Spielen runtertakten? Da wird im Bios HT deaktiviert, auf 1.19v zurückgestellt und ab gehts. 12 echte Kerne @4.6GHz reichen wohl noch 1-2 Tage bevor es untragbar wird.

Da bin ich bei dir. Bzw. ich hab da auch nichts bei kritisiert, nur der... Absolutismus

mit welchem etwas als allgemein real erzählt wird, da wink ich gelegentlich mit der RL-Fahne.

Der ganz großer Freund von SMT bin ich aber auch nicht.

edit:

Ich hab das mal eher so durch Zufall rausgefunden

CPU vs. GPU ohne Wertung in festen Verhältnissen. Für alle und nicht nur für Nv (Cuda). auch auf APUs/iGPUs bezogen.

Wer die theoretischen FP Leistungen jeweils findet und mit bisschen Mathe schauen will was wie schnell gehen könnte:

Beim gleichwertig gerechneten Ergebnis ist ein 2500k/4.5 mit SSE in etwa so schnell wie stock der Bonaire XTX auf der MSI R7 260X 2GD5 OC. In OpenCL1.2, am 128bit Vram hängend. Eine MSI RX470 GamingX 8GB ist

dabei tatsächlich auch real um die 2.4x schneller als diese 260X.

Real. Da passen die FP32 aus den Datenblättern schon recht gut zueinander.

Wie sich die CPUs

real samt SSE/AVX ab da steigern, kann man dem RL entnehmen. Für die GPUs kann man dann ruhig die Datenblätter mit ihren FP Tflops nehmen.

Würde also bedeuten, eine RX470 mit 5087 Tflops ist bei dem was sie der CPU abnehmen kann, 2.5x schneller als ein 2500k/4.5.

Viel Spaß beim hochrechnen späterer GPUs auf Ryzens und Cores

gab/gibt?

gab/gibt?  gab/gibt?

gab/gibt?

. Auf jedenfall über @4.5GHz

. Auf jedenfall über @4.5GHz

.

.