Die armen Entwickler bei Apple. Basteln was Interessantes und dann wird das durch Marketing und Preis torpediert, wobei man auch nicht 2000 € für eine Grafikkarte mit 6700 € für ein Komplettsystem gleichsetzen sollte.

Man stelle sich vor, Apple würde sich um 180° drehen und die Chips auch anderen Unternehmen zu ordentlichen Preisen (Apple's Gewinnspanne ist ja meist riesig) anbieten. Da könnte man sicher einiges mit diesen anstellen, vor allem dort, wo es auf Effizienz ankommt und ohnehin schon ARM vorherrscht, wie z.B. Emulation Handhelds.

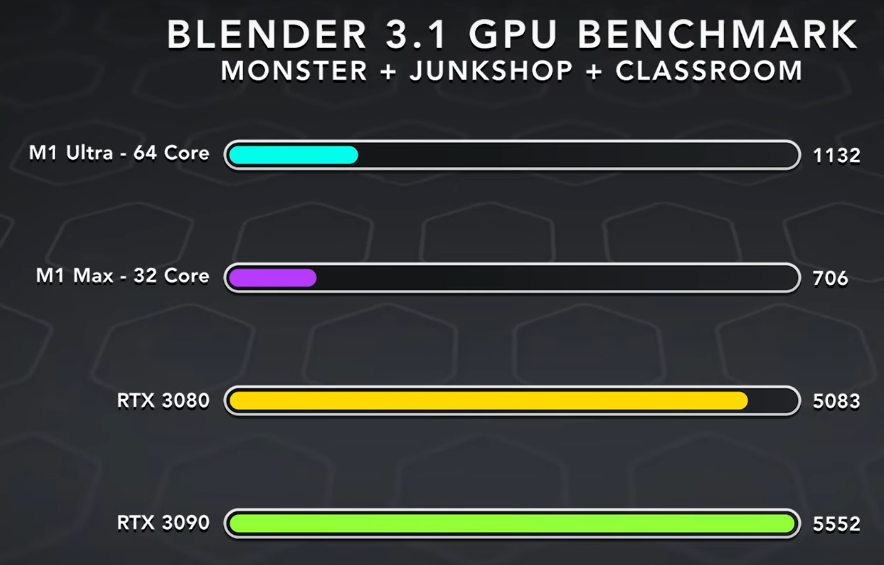

Irgendwie kommt es mir so vor, als würde Apple lügen, weil sie einfach keine Alternative für diejenigen Kunden anbieten, denen es um reine Maximalleistung geht und bei denen Effizienz zweitrangig ist.

Entweder lebt man damit und bewirbt halt die Effizienz oder man schafft eine Lösung bei der Grafikkarten wie z.B. eine 3090 mit M1 Chips gepaart werden können. Performance-Lügen wirken nur bei den Fanboys und Girls, aber die Kunden, welche Topdollar für maximale Performance ausgeben, welche sie auch tatsächlich benötigen, lassen sich damit nicht blenden.

Hachja, beim Marketing fallen alle Unternehmen immer wieder auf die Fresse. Egal ob Apple, Nvidia, Amd, Intel und wie sie alle heißen.