Tonga galt als Weitereinwicklung für Pitcairn. Mit OC, wird wurde hier ja auch angesprochen, oder UV was ja bei AMD alles nicht gehen soll. Man konnte gut 280 Leistung rausquetschen und läge dann mit 5% weniger zur 770, gut auf und kurz unter der 680 in dem jeweiligen Spiel. Zum deutlich billigeren Preis und Fehlgeburt Architektur. Das war der Grundtenor dieser Diskussion.

NVidia macht ordentlich Spünge weil sie genug Geld haben, woran das liegt frag dich selbst. Ich will diese Diskussion hier auch nicht ausweiten, weils nicht Thema dieses Threads ist. Mich stören immer wieder Einwürfe ohne diskrete Erläuertung, die nicht richtig sind und so einen falschen Eindruck hinterlassen, es wird überall hart gearbeitet. Ich will mich auch nicht in jedem Thread mit den selbsternannten Größen umherschlagen, wobei das Thema zig mal durchgekaut wurde. So schlecht wie GCN hingestellt wird, ist es nämlich nicht. Es war der notwendige Schritt weg von VLIW. Zuletzt hat es auch bewirkt, dass nVidia seine Strategie mehrmals durchdachte. Es gibt bei jedem Hersteller "Le*chen im Keller", nicht nur bei AMD.

Derzeit hat nVidia ganz andere Probleme, sieh es an CAD und nVidias Treiberstabilität, wenn es um openCL geht. Was man dort z.Z. abgeliefert ist ein Fiasko für die Integratoren - inklusive schrottiger PCBs bei over 1000$ Consumer Karten, wird aber in den Himmel gelobt. Wenn du das als moderne und zeitgerechte Entwicklungsarbeit bezeichnest, ist das dein Problem. Das du hier und da AMDs GCN als "Enttäuschung" bezeichnst ist mir sicher bekannt. Da machst du ja auch in Entwicklerforen nicht vor Halt. Interessiert dort aber kaum jemanden, verschenkst dir aber Möglichkeiten, Antworten zu erhalten nach denen du ständig auf der Suche zu sein scheinst.

Offtopic off.

Tonga galt als Weiterentwicklung von Pitcairn?

Wer hat das offiziell gemacht?

Also rein von den Eckdaten war Tonga hauptsächlich wie Tahiti konfiguriert.

32 CUs/2048 ALUs, 32 ROPs, 384-Bit GDDR5, aber statt 2 Shader-Engines gab es 4.

Die Chipgröße mit 359mm² war auch entsprechend ähnlich zu Tahiti mit 365mm².

Pitcairn lag bei 212mm².

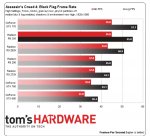

Neben der unsinnigen Fehlgeburt-Aussage, gab es aber auch die Behauptung mit Tonga hat Nvidia das Fürchten gelehrt oder wie Tahiti und Pitcairn in AC: Black Flag gerockt haben.

Auch ein Tick übertrieben das Ganze, findest du nicht?

Bezüglich der ersten Behauptung kann ich auch nur wiederholen, dass der GK104 2012 erschien, 294mm² groß ist und mit Tonga von 2014/15 auf einem Niveau war, was die Leistung und Effizienz angeht.

Das ist kein gutes Ergebnis und hat Nvidia sicherlich in keinem Aspekt das Fürchten gelehrt, die mit Maxwell zu der Zeit massiv vorgelegt haben.

Und wenn AMD ihr Angebot günstig verkauft, dann spricht das indem Fall nicht für Architektur.

Natürlich hat Nvidia seit Jahren ein massiv höheres R&D-Budget, als AMDs GPU-Sparte und wir sehen das Endergebnis davon.

Dadurch kann man viele Dinge besser in Relation setzen, aber leider ändert es an den Tatsachen nichts.

--------

Bezüglich CAD und Treiberstabilität, keine Ahnung ehrlich gesagt, da ich kein Fiasko mitbekommen habe und wenn es eins gibt, wie sehr betrifft das Nvidia finanziell?

Denn ich denke Nvidia muss sich vorerst mit schwächeren Finanzzahlen begnügen, nachdem man sich mit Pascal dumm und dämlich verdienen konnte, unter sovielen Marktsegmenten und mit dem Mining-Boom im Rücken.

Mit Turing sieht die Lage nicht mehr so paradiesisch aus.

Aktuell gibt es auch viel Bewegung, wo man noch nicht klar sagen kann, wie die Zukunft aussieht.

Intel will stark beim Automotive mitwirken, Tesla entwickelt selber, Intel wird auch bei den GPUs stark einsteigen, ob sie konkurrenzfähig sein werden, wird man noch abwarten müssen, aber Intel ist massiv und wenn die gut sind, hat Nvidia bei sehr vielen Absatzmärkten ein Problem.

AI ist ein großes Thema, aber dort gibt es auch mehrere Schwergewichte die attraktive Lösungen für den Markt oder gar Eigenbedarf entwickeln.

----

Ich bezeichne hier und da AMDs Fortentwicklung von GCN und die Resultate im Vergleich zur Konkurrenz als Enttäuschung.

Und bei wem verschenke ich mir Antworten, weil ich die Entwicklung und Situation bei AMD nicht so positiv bewerte?