Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News AMD FSR 3: DLSS-3-Konkurrent mit Frame Interpolation soll angeblich bald erscheinen

- Ersteller PCGH-Redaktion

- Erstellt am

G4mest3r

Software-Overclocker(in)

Ich finde es bemerkenswert, dass FSR2 fast genau so gut ist, wie DLSS 2.0.

Und das, obwohl es ohne aufwändige Tensor Cores und teure High-End Nvidia-Karten auskommt und auf allen Krafikarten und auchälteren Modellen Läuft, sowie auf Konsolen, offenen Treibern in Linux, Debian usw.

Auch wenn AMD hier Nvidia hinterherhinkt (die viel mehr Budget haben und den Technologietrends etwas vorauseilen und von ihrer Seite diktieren): FSR war in seiner ersten Iteration kein solch desaster wieDLSS 1.0.

FSR2 ist fast gleich auf, obwohl DLSS Jahre Vorsprung hatte.

Geliches sieht man auch bei Raytracing/Pathtracing:

Nvidia zündet (vielleicht auch etwas verfrüht) und gibt Trends vor und diktiert diese. Dabei implementieren sie die Technik proprietär nur auf ihren eigenen Karten und dort auch nur bei der Top-Line.

AMD Raytracing ist garnicht so schlecht, dafür, dass es wieder keine aufwendige KI-Berechnungen und Training benötigt und auf verschiedenen Karten läuft.

Dabei ist die Raytracing-Performance der 1. Iteration von AMD stärker, als die der 1. Iteration von Nvidia, gleiches bei der 2. Generation.

Und ich bin zuversichtlich für die 3.

ich muss immer schmunzeln und die Augen verdrehen, wenn in den Raytracing-Vergleichen Raytracing einer RDNA3 mit Raytracing einer Ada Lovelace verglichen wird.

Zudem schmilzt der Abstand zusammen und mit fortschreitender Entwicklung werden die Unterschiede marginaler, so dass zum Zeitpunkt, wenn die Technik endlich etabliert ist und flächendeckend eingesetzt wird, es kaum noch einen merklichen Unterschied machen wird.

Und wenn es so weit ist, bevorzuge ich für meinen Teil offene Standards und Techniken ohne Vendor-lock.

Und das, obwohl es ohne aufwändige Tensor Cores und teure High-End Nvidia-Karten auskommt und auf allen Krafikarten und auchälteren Modellen Läuft, sowie auf Konsolen, offenen Treibern in Linux, Debian usw.

Auch wenn AMD hier Nvidia hinterherhinkt (die viel mehr Budget haben und den Technologietrends etwas vorauseilen und von ihrer Seite diktieren): FSR war in seiner ersten Iteration kein solch desaster wieDLSS 1.0.

FSR2 ist fast gleich auf, obwohl DLSS Jahre Vorsprung hatte.

Geliches sieht man auch bei Raytracing/Pathtracing:

Nvidia zündet (vielleicht auch etwas verfrüht) und gibt Trends vor und diktiert diese. Dabei implementieren sie die Technik proprietär nur auf ihren eigenen Karten und dort auch nur bei der Top-Line.

AMD Raytracing ist garnicht so schlecht, dafür, dass es wieder keine aufwendige KI-Berechnungen und Training benötigt und auf verschiedenen Karten läuft.

Dabei ist die Raytracing-Performance der 1. Iteration von AMD stärker, als die der 1. Iteration von Nvidia, gleiches bei der 2. Generation.

Und ich bin zuversichtlich für die 3.

ich muss immer schmunzeln und die Augen verdrehen, wenn in den Raytracing-Vergleichen Raytracing einer RDNA3 mit Raytracing einer Ada Lovelace verglichen wird.

Zudem schmilzt der Abstand zusammen und mit fortschreitender Entwicklung werden die Unterschiede marginaler, so dass zum Zeitpunkt, wenn die Technik endlich etabliert ist und flächendeckend eingesetzt wird, es kaum noch einen merklichen Unterschied machen wird.

Und wenn es so weit ist, bevorzuge ich für meinen Teil offene Standards und Techniken ohne Vendor-lock.

BigYundol

BIOS-Overclocker(in)

„Tendenziell eine leicht niedrigere Latenz“?

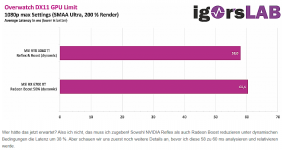

Im GPU Limit, logischerweise auch nur da, ist Reflex was Latenz angeht ein absoluter Gamechanger:

Anhang anzeigen 1434050

Quelle: https://www.igorslab.de/radeon-anti-lag-vs-nvidia-reflex-im-test-latenzvergleich/5/

Die Latenz wird mal eben so halbiert und genau das ist was Frame Generation überhaupt nutzbar macht. Damit sinkt die Latenz bei Einsatz von FG auf das Niveau der nativen Darstellung ohne Reflex und FG. Also das was AMD und Intel schaffen.

Ja tendenziell, weil die effektiv erreichbare Latenz abhängig vom jeweiligen Spiel ist und ein einzelnes cherrypicket Spiel nicht aussagekräftig genug ist, um eine allgemeingültige Aussage zu treffen:

Ausserdem interessiert mich eine halbierte Latenz nur wenn ich nichts mache herzlich die Bohne, ausser ich würde Camper spielen, der im Spiel nur rumliegt:

Das Ganze ändert natürlich nichts daran, dass Reflex momentan wirklich die bessere Tech ist, aber sie ist schlichtweg nicht so derb überlegen, wie einige gerne tun.

Zuletzt bearbeitet:

blautemple

Kokü-Junkie (m/w)

Was hat die Grafik mit Reflex zu tun?Ja tendenziell, weil die effektiv erreichbare Latenz abhängig vom jeweiligen Spiel ist und ein einzelnes cherrypicket Spiel nicht aussagekräftig genug ist, um eine allgemeingültige Aussage zu treffen:

Und hier lässt du bewusst die restlichen Infos zu der Grafik aus:Ausserdem interessiert mich eine halbierte Latenz nur wenn ich nichts mache herzlich die Bohne, ausser ich würde Camper spielen, der im Spiel nur rumliegt:

Auf gut deutsch, trotz fast doppelter fps, die durch die dynamisch gesenkte Auflösung kommen, ist die Latenz immer noch schlechter

Hier sind noch die restlichen Infos zu der Grafik:

NVIDIA NULL und Reflex vs. AMD Anti-Lag und Radeon Boost - was ist besser? Latenzen in der Praxis! | Seite 5 | igor´sLAB

Was lange währt – wird meistens gut. Für den heutigen Test mit der Frage „NVIDIA NULL und Reflex vs. AMD Anti-Lag und Radeon Boost, was funktioniert besser?“ habe ich mir allerdings extra viel Zeit…

Wen willst du hier eigentlich veräppeln

Doch Reflex ist extrem viel besser. Trotz doppelter fps ist die Latenz mit Reflex immer noch geringer.Das Ganze ändert natürlich nichts daran, dass Reflex momentan wirklich die bessere Tech ist, aber sie ist schlichtweg nicht so derb überlegen, wie einige gerne tun.

Skaugen

PC-Selbstbauer(in)

...

Doch Reflex ist extrem viel besser. Trotz doppelter fps ist die Latenz mit Reflex immer noch geringer.

Wieso widersprichst du der Aussage "dass Reflex momentan die bessere Tech ist" damit, dass "Reflex extrem viel besser ist"? Nur um des Widersprechens willens?

Außerdem vergleicht deine Grafik Nvidia Reflex NICHT mit Radeon Anti Lag. Sondern die Latenz zwischen Reflex und Nativer Latenz.

blautemple

Kokü-Junkie (m/w)

Weil er auch das hier schreibt:Wieso widersprichst du der Aussage "dass Reflex momentan die bessere Tech ist" damit, dass "Reflex extrem viel besser ist"? Nur um des Widersprechens willens?

Und dem widerspreche ich...aber sie ist schlichtweg nicht so derb überlegen, wie einige gerne tun.

Häh? Die Grafik vergleicht Reflex mit Radeon Boost und ich habe die Grafik nur zusammen mit der Quelle gepostet um zu zeigen dass @BigYundol seine Grafik komplett aus dem Kontext gerissen hat.Außerdem vergleicht deine Grafik Nvidia Reflex NICHT mit Radeon Anti Lag. Sondern die Latenz zwischen Reflex und Nativer Latenz.

Skaugen

PC-Selbstbauer(in)

...

Häh? Die Grafik vergleicht Reflex mit Radeon Boost und ich habe die Grafik nur zusammen mit der Quelle gepostet um zu zeigen dass @BigYundol seine Grafik komplett aus dem Kontext gerissen hat.

Nichts für Ungut, aber Radeon Boost ist was ganz anderes (erhöht vereinfacht gesagt die Frames bei Mausbewegung durch Reduzierung der Renderauflösung zum Bildschirmrand hin; und verringert dadurch indirekt die Latenz) und ist nicht mit Radeon Anti Lag zu verwechseln.

Die von BigYundol gepostete Grafik von Igorslab ist in der Hinsicht zwar irreführend, aber wortwörtlich gesehen korrekt.

blautemple

Kokü-Junkie (m/w)

Wie gesagt, ich habe Radeon Boost nicht ins Spiel gebracht, ich habe nur die Grafik in den richtigen Kontext gesetzt...Nichts für Ungut, aber Radeon Boost ist was ganz anderes (erhöht vereinfacht gesagt die Frames bei Mausbewegung durch Reduzierung der Renderauflösung zum Bildschirmrand hin; und verringert dadurch indirekt die Latenz) und ist nicht mit Radeon Anti Lag zu verwechseln.

Die von BigYundol gepostete Grafik von Igorslab ist in der Hinsicht zwar irreführend, aber wortwörtlich gesehen korrekt.

BigYundol

BIOS-Overclocker(in)

Weil er auch das hier schreibt:

Und dem widerspreche ich...

Häh? Die Grafik vergleicht Reflex mit Radeon Boost und ich habe die Grafik nur zusammen mit der Quelle gepostet um zu zeigen dass @BigYundol seine Grafik komplett aus dem Kontext gerissen hat.

Dann werden wir uns wohl nicht einig, weil wir offenbar aneinander vorbei reden.

Ich sehe keinen Grund meine Aussagen zu revidieren. Also wie...

Reflex ist besser ist als Anti-Lag, zu dem Preis, dass es aktiv ins Spiel implementiert werden muss. AMDs älterer Ansatz (auch zusätzlich in Kombination mit Boost) erwies sich als der technisch unterlegene. Ich finde aber nach wie vor, dass man anhand von einem bis ganz wenigen Spielen keine allgemeingültige Aussage treffen kann, wie stark Reflex tatsächlich besser ist, es einfach eine Tendenz dazu gibt. Und als neuere Tech ist das auch nicht verkehrt.

Dennoch es ist nett, aber kein over9000-Dingens. Eine noch stärkere Latenzverbesserung in einem statischen Szenario ist schön und nimmt man gerne mit, ist aber nach wie vor nur begrenzt interessant.

Dass die grundlegende Latenz selbst sehr stark vom jeweiligen Spiel oder oder anderen Umständen abhängig ist, bleibt bestehen. Radeon und Geforce erreichen ohne Anti-Lag/Reflex vergleichbare Latenzen. Mal ist der eine schneller mal der andere. Es ist nicht so, dass einer von beiden deutlich überlegen wäre (Gibt auch Tests hier auf PCGH die das zeigen, Ausreisser wie bsw. Battlefield 5 im einen PCGH-Test, wo diesmal die Radeon eine ~26% niedrigere Grundlatenz hat als das Geforce-Pendant gibt es nun mal immer, die 5ms wird man aber kaum bis gar nicht merken).

Beide können mit ihren jeweiligen Ansätzen beim einen Spiel in einem dynamischen Szenario bei igorslab die Latenz gleich stark reduzieren, auf einem ähnlichen Latenzniveau. Die Wege dazu sind dabei komplett unterschiedlich. NVidia mit Reflex, AMD mit einer Kombi aus Anti-Lag und Boost. Der Weg von Nvidia erweist sich bei igorslab in dem einen Spiel als der bessere (ich konstatierte ja schon mehrfach, dass Reflex besser ist als Anti-Lag). Und das macht technisch auch sehr wohl Sinn.

___

Ich fände es sehr spannend, wenn AMD im Windschatten von FSR3 mit einem Anti-Lag 2 oder so, einen ähnlichen Weg einschlagen würde wie NVidia, und die Latenz auch deutlich früher in der Pipeline versucht zu verringern. Spannend wäre das insbesondere dann, wenn sich dies auch noch mit Boost kombinieren liesse, es dabei auch weiterhin auf älteren Radeons funktionieren würde, wo solche Features am meisten Sinn machen.

Was klar ist, das eine oder andere nützliche Treiberfeature bei AMD ist langsam in die Jahre gekommen und ein Update wäre mehr als angebracht. Ich hoffe, sie nutzen die Chance beim angekündigten HYPR-RX, aber ich zweifle da noch ziemlich dran

Eine derartige Technik zur Verfügung zu haben ist erst mal grundlegend zu begrüßen, selbst wenn diese vielleicht(?) qualitativ nicht ganz mit DLSS3 mithalten kann. Es ist immer besser die Wahl zu haben.Schon mal besser wie gar nicht.? Hoffen wir es. Aber da Fsr überall funktioniert sehe ich nicht warum das hier anders sein soll. Oder haben die neuen Karten etwas was die alten nicht haben und das erfordert wird für dieses Feature?

Bezüglich der Lauffähigkeit auf anderen GPUs (abseits der aktuellen RDNA3-Generation) wird man abwarten müssen, was AMD hier überhaupt algorithmisch implementiert, denn aktuell weiß man das nicht so genau. Und damit ist auch unklar wie viel Rechenleistung die Lösung auf der GPU benötigen wird und welche Hardwarefunktionalität auf der GPU minimal benötigt werden wird um hier einen Mehrwert zu schaffen.

Wenn ich mich recht erinnere, hat AMD nicht einmal bestätigt, dass Machine Learning für die Interpolation verwendet werden wird und auf der GDC fiel anscheinend auch ein Kommentar zu einer Unterstützung der Xbox. Und zu guter Letzt wäre gar denkbar, dass man einen Hybridansatz wählte und auf leistungsschwacher Hardware einen einfacheren Interpolationsalgorithmus verwendet und entsprechend etwas Qualität opfert.

Mal abwarten was kommt. Möglicherweise wird Starfield zur Einführung genutzt werden. Die Frage ist natürlich, wie schnell sich das verbreiten kann und wird ...

derneuemann

Volt-Modder(in)

Das kann für AMD schon mehr von Vorteil sein, als für Nvidia. Denn Nvidia fehlt es weniger an Leistung, dafür eher am Speicher.

Da kann es sein, das es Latte ist ob man am Ende 60, oder 75-80 FPS hat. Aber 12 zu 20, oder 16 zu 24 GB könnten eher entscheidend sein.

Das ist keine Aussage das eines von beiden besser ist, wir werden erst abwarten müssen, wie es sich in den nächsten Monaten, Jahren entwickelt.

Da kann es sein, das es Latte ist ob man am Ende 60, oder 75-80 FPS hat. Aber 12 zu 20, oder 16 zu 24 GB könnten eher entscheidend sein.

Das ist keine Aussage das eines von beiden besser ist, wir werden erst abwarten müssen, wie es sich in den nächsten Monaten, Jahren entwickelt.

Ähnliche Themen

- Antworten

- 122

- Aufrufe

- 8K

- Antworten

- 82

- Aufrufe

- 4K

- Antworten

- 6

- Aufrufe

- 992

- Antworten

- 100

- Aufrufe

- 5K