Warum kaufen sich Leute 4K-Bildschirme, wenn sie dann daruf hoffen müssen, dass Dinge wie Upskaling und Frame Generation in den Spielen intergiert sind und auch noch super funktionieren müssen, damit das angezeigte Bildspektakel mit etwas Glück besser aussieht als mit einem normalen Bildschirm?

Weil DLSS in 4k, im Qualitätsmodus in der Regel besser aussieht als nativ und schneller läuft.

Das ist so als würde man extra Linux nehmen, um dann versuchen zu wollen in Sachen Leistung, Stabilität und angezeigter Grafik Windows zu schlagen.

Nein, eigentlich nimmt man nur den sinnvollsten Weg.

Sehr viel Aufwand und Ärger um fast nichts.

Welcher Ärger, man hat ja einfach die Wahl das beste Verfahren zu nutzen wenn man kann. Egal ob XeSS, FSR, oder DLSS.

Aber ist sicher schlauer, auf 50% und mehr Performance bei gleicher Optik (im Großteil der Spiele) zu verzichten.

Gibt es da draussen noch weitere Spieler wie mich, die einfach die Kiste anschmeißen und Spaß haben können?

Das machen doch über 99% der Spieler so, auch ich.

Ohne stundenlang an den Optionen, Treibern oder sonstwas herumdocktern zu müssen?

Muss ich als Beispiel auch nicht. DLSS Q ist quasi immer an und sieht bisher immer gut aus.

Einfach nur mal spielen und Spaß haben?

Habe ich jedes mal.

Ob man jetzt beim ersten Spielstart Option A, oder B wählt macht da keinen Unterschied.

Wenn ein Rechner zu alt ist und man kein Geld ausgeben möchte, ok, dann einfach Klimbims anstellen, mit den Problemen leben, solange man noch ein Spiel im Angebot mitnehmen und zocken kann.

Ich glaube das deine Erfahrungen, oder Informationen nicht aktuell sind

Alles andere ist aber Unsinn.

Nein, wenn schon DLSS mal nachgewiesen besser aussehen kann, als nativ. Wenn es darüber hinaus in Spielen wie AW2, oder CP77 dazu führen kann, das man PT nutzen kann... Dann ist das schon mal sicher kein Unsinn.

Auch wenn du anders denkst.

Was man im wahren Spielgeschehen eh nicht sieht, kann man auch gleich ganz aus lassen.

Dann kannst du auch immer DLSS/XeSS, oder bald FSR3.1 aktiv haben, weil du den Unterschied nicht siehst und dafür deutlich mehr Fps bekommst.

PS: geht nur darum das man das anders sehen kann und es eher weniger um Unsinn und Sinn geht.

Ohne Witz, ich seh da keinen Unterschied.

Na, also FSR kann man schon deutlich erkennen

Wenn man die ganzen Teils erklatanten Bildfehler nicht siehst, oder es dich nicht juckt, ja, dann kannst du natürlich auch damit spielen.

Aber es ist und bleibt ein Paradoxon:

"Ich will bessere Spielegrafik!" - ok, aktiviere willkürlich generierte Bildfehler!

Dann zeig mal die ganzen wilden Bildfehler, bei Beispielsweise DLSS Q und aktuellen Spielen.

Gruß vom blauen Schnösel aus Avatar mit seinen Fledermausarmen. ;-P

Wie ich eben sagte: wenn die alte Gurke daheim zu schwach fürs Spiel ist, und es ist die letzte Hoffnung, weil bereits die Details reduziert werden mussten, dann ist das eine valide Optionen , um spielen zu können und einen Neukauf noch weiter hinauszuzögern.

"Luxus"gamer sollten jedoch mal ihr Verhalten generell überdenken, ob man für einen Bildschirm mit hoher Auflösung mit Raytracing diese Dinge braucht oder wirklich will.

Das optische Erlebnis in AW2 ist mit DLSS in 4k, mit Path Tracing ganz sicher ein besseres, als nativ in 1080p mit PT, oder eben 1440p ohne PT.

Beispiel: Diablo 4 macht bis zu -90% mit Raytracing? (hab die Meldung nicht ganz gelesen)

Diablo ist wirklich ein Negativbeispiel. Avatar, AW2, CP77, aber beispielsweise nicht.

Dann lässt man den Mist doch einfach mal aus und hat trotzdem Spaß, vielleicht sogar mehr, weil man nicht fummeln muss und problemlos flüssiges Gameplay hat.

Wieso fummeln. Außerdem, wie will man entscheiden auf welche Optik man verzichten.

Will man die zu jetzt aktuell eher seltenen Bildfehler bei DLSS stärker gewichten, als den Verzicht auf die absolut überlegene Beleiuchtung, Verschattung usw.

Versteh mich nicht falsch. Ich habe zwischendurch einen ähnlichen Denkansatz. Dann aber informiert und verglichen, sowie unabhängige Tests gelesen, gesehen.

In den meisten Fällen ist der Einsatz von DLSS absolut zu empfehlen. FSR ist deutlich seltener sinnvoll, da die optischen Einschnitte größer sind (Gerade in Bewegung). Aber das ändert sich sicher mit FSR3.1.

Voll kommen in Ordnung.

Also ist das nicht Unsinn, sondern nur für dich ergibt das keinen Sinn.

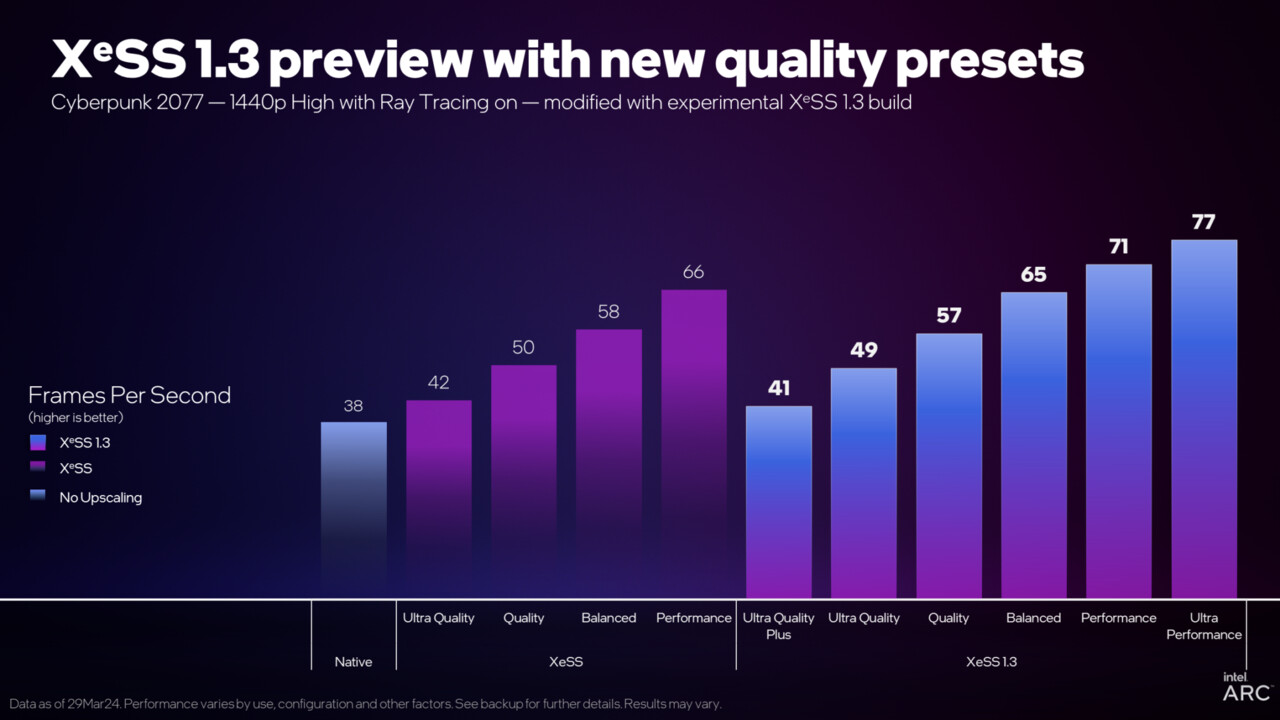

PS: noch was zum Thema Intel: die haben die Skalierung im neuesten Treiber grobpixeliger gemacht.

Also Vorsicht, wenn man Benchmarks miteinander vergleicht. Die höheren Bildraten kommen zum großen Teil jetzt dadurch zustande, nicht durch höherer Leistung der Hardware, die ist ja noch immer gleich lahm.

Wenn also nun mit Faktor 2,3 statt 2 gerendert wird, dann sind das bald schon irgendwo zwischen 10-15% Differenz.