derneuemann

Lötkolbengott/-göttin

Darum geht es doch gar nicht.Liebe Leute, hängt ihr alle mit der Nase am Bildschirm oder Spielt ihr mit einer Lupe?

Ja AMDs Frame Generation produziert ein schlechteres Bild, da wohl die KI Komponente fehlt. Aber zu behaupten es wäre unspielbar oder um Welten schlechter ist völlig übertrieben. Jeder, der das Spiel einfach nur spielt und sich daran erfreut, wird den Unterschied nie bemerken.

Wer Nvidia sein Geld in den Rachen geworfen hat und eine RTX 4000er Karte hat, sollte natürlich DLSS mit Frame Generation nehmen, wenn im Spiel verfügbar. Aber der Rest der Leute mit RTX 3000er oder Radeon nehmen dankend AMD FSR3 an und erfreuen an der höheren FPS.

Hier wird manchmal wegen Kleinigkeiten ein Fass auf gemacht, wenn man dann aber auf wichtige Unterschiede eingeht, sind diese plötzlich nichtig.

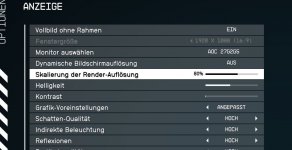

Nur nochmal ein Tipp, für alle interessierte.

Techpowerup Spieletests die Vergleichsslider mit Optionsauswahl.

Hier kann man wiederholt sehen ( quasi alle Spiele, die die dieses Jahr getestet haben) das DLSS Q zu FSR Q mehr negative Auswirkung hat, als zum Beispiel eine Detailstufe runter zu gehen, bzw. eine Texturstufe.

Das kann sich jeder selber mal anschauen!

Das man deswegen mit AMD nicht zocken kann sagt keiner!