Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test der Titan Xp: Schneller als die Geforce GTX 1080 Ti

- Ersteller PCGH-Redaktion

- Erstellt am

Cook2211

Trockeneisprofi (m/w)

Die Fury X und die 980ti haben im Prinzip die gleiche Leistung.

Das war bei Erscheinen so und das hat sich nicht geändert.

Das ist richtig. Zwischen dem Test 2015 der Fury X und heute, hat sich das Verhältnis der Fury zur 980Ti im PCGH Index nicht signifikant geändert. Damals wie heute liegen die GPUs nur einige wenige Prozent auseinander.

Ein Vorteil der 980Ti war allerdings, dass man durch OC mehr herausholen konnte, als es bei der Fury X möglich war.

Oje da hab ich anscheinend einen Nerv getroffen.

Zur Release war dort ja noch mächtig Unterschied...

Nö...

auch zu Release gabs immer wieder mal Spiele in denen die Fury x in UHD vor einer stock GTX 980ti war.

Spiele wie Sniper Elte 4 zeigen auch heute immer wieder mal das die Fury x auch mit einer Custom GTX 980ti mithalten kann.

Aber das ist eben nicht die Regel.Teilweise sind dann die Unterschiede schon ziemlich groß.

Also nichts neues an der Front.

Der Test hmm......was soll er schon groß zeigen?

Die Karte ist wie erwartet ein paar Prozent schneller..........mehr gibts eigentlich nicht zu sagen.

Da braucht man auch nicht über den Preis diskutieren, denn ich glaube nicht das irgend jemand die Karte zu dem Preis kauft...............oder doch?

Die Preisdiskussion ist doch nur für den interessant der auch mit dem Gedanken spielt das jeweillige Objekt auch erwerben zu wollen.

Wenn ich es nicht kaufen will, dann juckt mich der Preis auch nicht und ich hab auch keinen Grund darüber zu meckern.

Zumindest mein Gedanke.

Zuletzt bearbeitet:

F

FortuneHunter

Guest

Nö...

auch zu Release gabs immer wieder mal Spiele in denen die Fury x in UHD vor einer stock GTX 980ti war.

Spiele wie Sniper Elte 4 zeigen auch heute immer wieder mal das die Fury x auch mit einer Custom GTX 980ti mithalten kann.

Aber das ist eben nicht die Regel.Teilweise sind dann die Unterschiede schon ziemlich groß.

Also nichts neues an der Front.

Das ist doch nicht dein Ernst?

... Das kannst du doch nicht tun.

... Das kannst du doch nicht tun.  ... Wie herzlos muss man sein, den AMD-Fanboys ihr schlagendes Argument von Performanceverbesserungen über die Zeit zu rauben.

... Wie herzlos muss man sein, den AMD-Fanboys ihr schlagendes Argument von Performanceverbesserungen über die Zeit zu rauben.

Warte nur ab 2030 wird eine Fury X die GTX 980 ti im neu rausgekommenen Spiel X in die Tasche stecken, wenn sie unter 1080P die GTX 980 Ti um das doppelte schlägt mit 2 FPS über 1 FPS.

G

Gast20190527

Guest

Das Preis-/Leistungsverhältnis der Titan Xp stimmt halt mal überhaupt nicht. Zwei GTX 1080 Ti im SLI pulverisieren, für annährend den gleichen Preis, eine einzelne Titan Xp in Spielen und Benchmarks, für eine jedoch fast doppelt so hohe Stromaufnahme.

bei den aktuellen werten die man auf PCGH sieht, benötigt man dafür kein 1080ti SLI System. Da reicht es auch eine gute Custom 1080ti zu benutzen und man liegt für fast den halben Preis einer Titan Xp noch über dieser.

wolflux

Lötkolbengott/-göttin

Man lenke die Blicke vor allem auf die Spezialbenchmarks, denn die ergänzen das Leistungsbild mit Pro-Takt-Tests sowie OC-Vergleichskarten.

Im kommenden Heft haben wir übrigens auch SLI-Werte der Titan Xp.

MfG,

Raff

Auch SLI-Werte der 1080Ti oder waren die schon mal?

Gruss

MiezeMatze

Software-Overclocker(in)

Wenn jemand Kohle bis dort naus hat und sagt* ich Kauf mir eine Titan Xp einfach weil ich es kann* ist doch ok....

Aber den Mehrwert den einem NVidia da anbietet ist ja n Witz...n ganz schlechter.

Aber den Mehrwert den einem NVidia da anbietet ist ja n Witz...n ganz schlechter.

thorecj

Freizeitschrauber(in)

Das ist nicht dein Ernst, einen nativen UHD Monitor mit FHD+DSR gleich zu setzen. Da liegen einfach Welten dazwischen.Ansonsten ja, dank dem genialen DSR(danke PCGH für den Push bei NV dafür) sind quasi alle 1080p Monitore, 4k Monitore. Ich halte viel von DSR(Faktor 4) und behaupte das es fast so gut ist wie ein nativer 4k

Bis auf sehr wenige Ausnahmen läuft gar nichts bei 6Gb über. Und in der PCGH stand niemals, das sie 8Gb als das absolute Minimum empfehlen. Lies einfach mal genauer. Sie schreiben sowohl im Heft als auch online davon, das man für die Zukunft mit einer 8Gb Karte gut gerüstet ist. Das ist ein Unterschied.Wenn man die Texturen runter stellt schon, ansonsten never. 6GB laufen ja heute schon über. So viel Fantasie braucht man ja dann nicht was mit 8GB bald passiert. 8GB sind das absolute Minimum schreibt ja auch PCGH im Artikel.

Obstundgemuese

PC-Selbstbauer(in)

Der eigentliche Witz ist doch das Teil als Prosumer Produkt zu bewerben. Wenn Nvidia sagen würde die Titan bekommt Quadro Treiber würde ich direkt eine bestellen. Spotbillig im Vergleich zurP6000

Aber die Leistung dieser Titan in Solidworks oder Siemens NX ist sicher wieder genauso verkrüppelt worden wie bei den Vorgängern. Also keine Ahnung wer das kaufen soll

Ein Profianwender sicher nicht. Dafür sorgt Nvidia schon...

Also für den Gamer zu teuer und den Profianwender wertlos, ergo sinnloses Produkt.

Aber die Leistung dieser Titan in Solidworks oder Siemens NX ist sicher wieder genauso verkrüppelt worden wie bei den Vorgängern. Also keine Ahnung wer das kaufen soll

Ein Profianwender sicher nicht. Dafür sorgt Nvidia schon...

Also für den Gamer zu teuer und den Profianwender wertlos, ergo sinnloses Produkt.

Bis auf sehr wenige Ausnahmen läuft gar nichts bei 6Gb über.

Naja, in UHD biste mit 6GB regelmäßig am Ende, da werden sogar die 12 GB öfter voll (und das lange bevor die GPU am Ende mit den FPS wäre!).

Was aber stimmt ist, dass das nur bei sehr hohen Einstellungen bei AAA-Grafikkrachern der Fall ist (Bild ist aus Hitman 4K/Ultra), die allerallermeisten Spiele belegen selbst in UHD kaum 4 GB.

thorecj

Freizeitschrauber(in)

Mit 6Gb Karten ist man ja mittlerweile auch selten in UHD unterwegs. Selbst eine 980Ti ist in den neueren Titeln in UHD am Ende, nebenbei genau wie auch die 1070, daher ist das auch nicht auf die Speicherbestückung zurückzuführen.Naja, in UHD biste mit 6GB regelmäßig am Ende, da werden sogar die 12 GB öfter voll (und das lange bevor die GPU am Ende mit den FPS wäre!).

Was aber stimmt ist, dass das nur bei sehr hohen Einstellungen bei AAA-Grafikkrachern der Fall ist (Bild ist aus Hitman 4K/Ultra), die allerallermeisten Spiele belegen selbst in UHD kaum 4 GB.

Anhang anzeigen 955108

Übrigens, 30 Minuten rumlaufen in Ark (UHD) und meine Speicherbelegung attestiert mir 10,5 Gb. Man findet immer ein Haar in der Suppe, deswegen schrieb ich auch "bis auf sehr wenige Ausnahmen".

Selbst eine 980Ti ist in den neueren Titeln in UHD am Ende

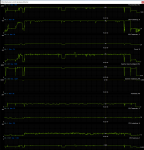

Was du auf meinem Bildchen da siehst sind im Mittel 50 fps auf einer TitanX, die auf 80% Powertarget gedrosselt ist (auch wenn das dank WaKü immer noch zugegeben in sehr hohen Boosttaktraten resultiert). Eine 980Ti würde hier alleine was die GPU-Leistung angeht durchaus noch ihre 30+ fps schaffen was absolut spielbar ist in Hitman (das nicht auf gute reaktionszeiten angewiesen ist). Die würde hier einzig und alleine wegen des Speichermangels in einstellige fps-Bereiche fallen.

Firestar81

Software-Overclocker(in)

Schafft man das überhaupt , den Chip auf stabile 2GHZ hochzuprügeln, oder spielt da schon nicht das Powertarget mit?

Es kommt ein bischen aufs Glück an (ob 2 GHz überhaupt stabil sind, das schaffen nicht alle GP102 Chips - sehr gute schaffen an die 2100 MHz, sehr schlechte schmieren bei 1900 ab), vor allem aber auf die Kühlung.

Mit dem Referenzkühler haste keine Chance auf stabile 2 GHz, einfach weil sowohl Power als auch Temperaturlimit einbremsen.

Wenn du einen (sehr) guten Luftkühler hast und das Powertarget maximierst kannst du die 2 GHz in der Regel (bis auf seltenere Extremsituationen) halten.

Wenn du den GP102 mit Wasser kühlst (und damit sogar bei 300W Abwärme unter 40°C halten kannst bei einer starken WaKü - siehe mein Bildchen, bei 80% PT gehts nicht über 35°C GPU-Temperatur) wird dieser sehr effizient da die Leckströme stark sinken. Dann hältst du absolut Problemlos die 2 GHz oft bereits ohne das Powertarget überhaupt anzuheben. Siehst du ja oben - bei 80% PT, sprich 200W, boostet meine Karte schwankend um die grob 1900 MHz. Bei 100% PT sind die 2 GHz zumeist da, bei 120% PT sind sie durch die Bank immer da (nur hat es keinen Sinn 100W mehr reinzudrücken um 100 MHz mehr zu erreichen... die 5% Leistungszuwachs merkste eh nicht).

Mit dem Referenzkühler haste keine Chance auf stabile 2 GHz, einfach weil sowohl Power als auch Temperaturlimit einbremsen.

Wenn du einen (sehr) guten Luftkühler hast und das Powertarget maximierst kannst du die 2 GHz in der Regel (bis auf seltenere Extremsituationen) halten.

Wenn du den GP102 mit Wasser kühlst (und damit sogar bei 300W Abwärme unter 40°C halten kannst bei einer starken WaKü - siehe mein Bildchen, bei 80% PT gehts nicht über 35°C GPU-Temperatur) wird dieser sehr effizient da die Leckströme stark sinken. Dann hältst du absolut Problemlos die 2 GHz oft bereits ohne das Powertarget überhaupt anzuheben. Siehst du ja oben - bei 80% PT, sprich 200W, boostet meine Karte schwankend um die grob 1900 MHz. Bei 100% PT sind die 2 GHz zumeist da, bei 120% PT sind sie durch die Bank immer da (nur hat es keinen Sinn 100W mehr reinzudrücken um 100 MHz mehr zu erreichen... die 5% Leistungszuwachs merkste eh nicht).

Es kommt ein bischen aufs Glück an (ob 2 GHz überhaupt stabil sind, das schaffen nicht alle GP102 Chips - sehr gute schaffen an die 2100 MHz, sehr schlechte schmieren bei 1900 ab), vor allem aber auf die Kühlung.

Mit dem Referenzkühler haste keine Chance auf stabile 2 GHz, einfach weil sowohl Power als auch Temperaturlimit einbremsen.

Wenn du einen (sehr) guten Luftkühler hast und das Powertarget maximierst kannst du die 2 GHz in der Regel (bis auf seltenere Extremsituationen) halten.

Wenn du den GP102 mit Wasser kühlst (und damit sogar bei 300W Abwärme unter 40°C halten kannst bei einer starken WaKü - siehe mein Bildchen, bei 80% PT gehts nicht über 35°C GPU-Temperatur) wird dieser sehr effizient da die Leckströme stark sinken. Dann hältst du absolut Problemlos die 2 GHz oft bereits ohne das Powertarget überhaupt anzuheben. Siehst du ja oben - bei 80% PT, sprich 200W, boostet meine Karte schwankend um die grob 1900 MHz. Bei 100% PT sind die 2 GHz zumeist da, bei 120% PT sind sie durch die Bank immer da (nur hat es keinen Sinn 100W mehr reinzudrücken um 100 MHz mehr zu erreichen... die 5% Leistungszuwachs merkste eh nicht).

Das möchte ich mal stark bezweifeln, im allgemeinen zumindest.

Vorab, bei mir werkelt eine Titan X (Pascal) mit Wakü. Die boostet bei mir stabil hoch bis 2076 MHz, also schon sehr ordentlich. Temperatur liegt knapp unter 40°C bei Vollast, PT ist auf 120% gemaxt.

In 1080P wird bei dem Großteil der Spiele der maximale Boosttakt auch fast immer gehalten, sobald man aber auf UHD wechselt (weswegen man ja so ein Geschoss kauft), kann es durchaus runter bis ~1900Mhz gehen. Gerade ME:A ist da ein besonders harter Fall in manchen Situationen (Scourge im All, Cutscenes in Nahaufnahme zb) - da zeigt einem der Afterburner kurz mehr als 120% PT an und direkt wird die Drosselung reingehauen um irgendwo bei <120% rauszukommen, was definitiv in Taktraten weit unter 2076 MHz, also dem max. Boosttakt resultiert. Was man bedenken sollte: Gerade in diesen Szenen wo das PT nicht reicht, herrscht auch die größte Last und daher auch meist die geringsten FPS - doppelt ärgerlich also, man "verliert" gerade dann Leistung wenn man sie am dringensten braucht.

Ein anderes negtiv Beispiel ist Unigine Superpostion:

1080P extreme: 2076 MHz

4k optimized: ~2038 MHz

8k optimized: ~1987 MHz

Ein anderes Beispiel wird ja auch gerne von Redaktionen verwendet um Worstcase Boosttaktraten zu testen: Anno 2205.

Wie man sieht hat schon eine Wakü Probleme bei manchen Situationen die 2GHz zu halten, trotz der niedrigen Temperaturen. Von daher extrapoliere ich mal das eine (wenn auch potente) Nachrüstlukü wohl nicht immer die 2GHz halten kann, nicht nur in Extremsituationen. Vorallem wenn sich nach längerer Lastphase alles aufheizt.

Von daher: Nein, eine Titan (X oder Xp) @Lukü wird nicht immer >2GHz halten, vorallem nicht in 4k unter heavy load.

F

FortuneHunter

Guest

Naja, in UHD biste mit 6GB regelmäßig am Ende, da werden sogar die 12 GB öfter voll (und das lange bevor die GPU am Ende mit den FPS wäre!).

Was aber stimmt ist, dass das nur bei sehr hohen Einstellungen bei AAA-Grafikkrachern der Fall ist (Bild ist aus Hitman 4K/Ultra), die allerallermeisten Spiele belegen selbst in UHD kaum 4 GB.

Anhang anzeigen 955108

Also ich habe mal versucht dein Ergebnis mit meiner GTX1080 nachzuvollziehen in 4K mit Ultra-Einstellungen:

Beim Speicherverbrauch bin ich maximal auf 4732 MByte gekommen, also weit unter den 12 Gbyte die du verbraucht hast.

Vermutung: Du hast auch noch Supersampling hochgezogen, aber dann reden wir nicht mehr von 4K sondern von wesentlich höheren Auflösungen.

Und hier ein paar Bilder aus den jeweiligen Gebieten. Mit den FPS bin ich teilweise schon deutlich unter 60 FPS:

Sicherlich gibt es Spiele die den Speicher zum Frühstück verspeisen, aber Hitman gehört hier eigentlich nicht dazu, wenn man die Auflösung nicht über 4K durch Supersampling peitscht.

Rise of the Tomb Raider ist da ne ganz andere Hausnummer ... Bei 4K kommt meine Karte dann an die Kotzgrenze bei WQHD bleibt sie kurz darunter im Geothermalen Tal und den Spezialtexturen und SMAA als AA-Methode. Das schlägt sich auch umgehend auf die FPS nieder:

Zuletzt bearbeitet:

@balduin:

Wie schon gesagt unter Luft wirds durchaus eng, ich hab unter Wasser aber außer bei wirklichen Extremsituationen keinerlei Probleme die 2 GHz durchzuhalten, auch bei deinem Beispiel des Superposition nicht. Da kann ich bis 2088 MHz in 1080p und um die 2040 MHz 4K (einfach weil der benchmark nicht besonders sensitiv auf Instabilitäten ist, 2088 MHz stürzen beispielsweise im Witcher 3 innerhalb weniger Sekunden ab, die übliche Kotzgrenze meiner Karte sind ~2025 MHz, darüber ists instabil), erst bei 8K wirds sehr eng, da liege ich zwischen 1950 und 2000 MHz schwankend.

Es stimmt also schon dass es bei sehr hoher Last schon knapp wird da oben rum, aber wie gesagt bei einer sehr (!) starken Kühlung sollte man im Alltag eigentlich immer die 2 GHz packen wenn mans drauf anlegt.

@FortuneHunter: Warum der Hitman bei mir die 12 GB immer komplett vollklatscht weiß ich auch nicht, vielleicht wird da auch irgendwas reserviert oder ein Patch hat da was gefixt, das Bilod von mir ist schon etwas älter.

TombRaider bewegt sich beim Spielen so irgendwo zwischen 9 und 11 GB wenn man alles voll aufdreht in 4K. Ähnliche Füllstände schafft auch QuantumBreak an manchen Stellen sowie Shadow of Mordor.

Ob das aber wirklich nötig ist kann ich nicht sagen - nur weil ein Spiel bei mir 10 GB vollschmeißt heißt das ja nicht, dass es auf ner 8GB-Karte ruckeln würde.

Wie schon gesagt unter Luft wirds durchaus eng, ich hab unter Wasser aber außer bei wirklichen Extremsituationen keinerlei Probleme die 2 GHz durchzuhalten, auch bei deinem Beispiel des Superposition nicht. Da kann ich bis 2088 MHz in 1080p und um die 2040 MHz 4K (einfach weil der benchmark nicht besonders sensitiv auf Instabilitäten ist, 2088 MHz stürzen beispielsweise im Witcher 3 innerhalb weniger Sekunden ab, die übliche Kotzgrenze meiner Karte sind ~2025 MHz, darüber ists instabil), erst bei 8K wirds sehr eng, da liege ich zwischen 1950 und 2000 MHz schwankend.

Es stimmt also schon dass es bei sehr hoher Last schon knapp wird da oben rum, aber wie gesagt bei einer sehr (!) starken Kühlung sollte man im Alltag eigentlich immer die 2 GHz packen wenn mans drauf anlegt.

@FortuneHunter: Warum der Hitman bei mir die 12 GB immer komplett vollklatscht weiß ich auch nicht, vielleicht wird da auch irgendwas reserviert oder ein Patch hat da was gefixt, das Bilod von mir ist schon etwas älter.

TombRaider bewegt sich beim Spielen so irgendwo zwischen 9 und 11 GB wenn man alles voll aufdreht in 4K. Ähnliche Füllstände schafft auch QuantumBreak an manchen Stellen sowie Shadow of Mordor.

Ob das aber wirklich nötig ist kann ich nicht sagen - nur weil ein Spiel bei mir 10 GB vollschmeißt heißt das ja nicht, dass es auf ner 8GB-Karte ruckeln würde.

LastManStanding

PCGH-Community-Veteran(in)

Alle beschweren sich dass, das Preis/Leistungs Niveau der Titan X ungerechtfertigt ist. 5 Prozent mehr Leistung für den Doppelten Preis der 1080Ti.

Aber seht doch mal genau hin; Die hat ja 1 GB mehr VRAM.

Und das aller-aller Wichtigste, gleich nach dem Prestige sagen zu können ich habe eine Titan X und daher mehr Geld sinnlos zu verschleudern als Du:

Man bekommt diesen absolut geilen Formausgewogenen. Leistungseffizienten, Designpreis verdächtigen Referenz-Kühler.

Und Gratis als Kirschchen oben drauf Traumhaft heiße Sommer,Sonne Temperaturen wie Asphalt Barfuss.... "Innerhalb des Computer"

Aber seht doch mal genau hin; Die hat ja 1 GB mehr VRAM.

Und das aller-aller Wichtigste, gleich nach dem Prestige sagen zu können ich habe eine Titan X und daher mehr Geld sinnlos zu verschleudern als Du:

Man bekommt diesen absolut geilen Formausgewogenen. Leistungseffizienten, Designpreis verdächtigen Referenz-Kühler.

Und Gratis als Kirschchen oben drauf Traumhaft heiße Sommer,Sonne Temperaturen wie Asphalt Barfuss.... "Innerhalb des Computer"

Ähnliche Themen

- Antworten

- 86

- Aufrufe

- 4K

- Antworten

- 29

- Aufrufe

- 2K

- Antworten

- 12

- Aufrufe

- 751

- Antworten

- 135

- Aufrufe

- 8K

.gif)