Nun angespielt quasi nur fürn bench und die stelle im spiel am anfang läuft ohne zu meckern aber

Die kompilierung der shader dauert udn wird bei jeden neuen patch udn jeden neuen treiber wiederholt.

Ws ziemlich nervig ist es kamen bisher 3 patches rausdas erste mal etwa10 min daszweite etwa 5min der dritte etwa gleich

Zum spiel optisch ist von low bis ultra kaum sichtbar

Das auffälligste ist ssr das deaktiviert ist auf low

Ansonsten sieht low vs maxed ziemlich ähnlich aus.

dafür diese perf unterschiede

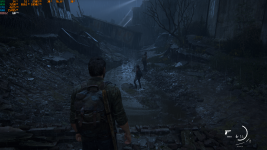

low

ultra

vram einmal low etwa 4,9gb von 12gb und 19,6gb ram

und einmal ultra 9,18gb von 12gb und 19,8gb ram

Der Speicherbedarf ist groß und folgend ist auch klar das eine 8gb vram gpu nur mit low Texturen sauber laufen wird.

Das kratzt am ego ich hoffe aber das naughty dog nicht nachgibt und die settings im spiel anpasst, den wenn man es richtig einstellt gibt es keine Probleme mit rucklern und mausstottern.

Die abstürze sind aufgrund bei nvidia von Microsoft schuld da das OS auf einen Treiber fixiert wurde seitdem stürzen jeweilige spiele einfach ab.

Der Grund liegt an folgenden Modul ntdll.dll und seltener nvdmxxx

Die Ursache ist Ms eingriff beim gpu Treiber und dem gui vom OS.

Lösung für nvidia bis win 10/11 23h2 kommt DCH 512,95 und ältere gpu standard 472,12 alles andere macht Probleme.

amd ist da schon sicherer von denen hört man auch kaum was von Problemen bei dem spiel.