KuroSamurai117

Volt-Modder(in)

Da es aber wohl so ist, sollte der Effekt für uns PCler mehr als überschaubar sein und das Ganze ist damit ein Feature für Konsolenhersteller und Entwickler; die einen sparen Arbeitsspeicher, die anderen müssen kein Speichermgmt mehr betreiben.

Schade.

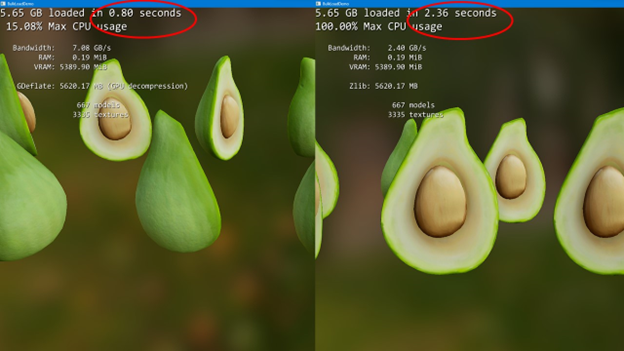

Liegt doch eher daran weil neue Spielkonzepte die mehr ermöglichen kaum da sind. Wenn du aber Spiele willst wo durch Zeitsprungfunktion oder Portale aus Gameplay in 1 Sekunde komplett neue Assets laden musst dann bekommst die bei einem 100-150GB Spiel nicht in 16-32GB RAM vorgeladen.

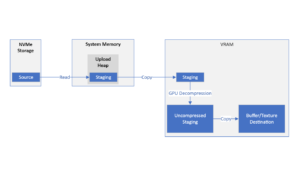

Anstatt irgendwann die Anforderungen an die Arbeitsspeichermenge immer weiter zu erhöhen ist es doch eher sinnvoll eh den Massenspeicher zu nutzen wo Spiele für Dauer ihrer Nutzung liegen.

Arbeitsspeicher ist halt flüchtig und müsste immer wieder zugeschaufelt werden mit Daten.

Würde auch z.B. Quick Resume Funktion von Xbox nicht gehen. Schreibst ja aktuellen Spielstatus auf die Festplatte und kannsz ohne zu Speichern von dort weiterzocken. Selbst wenn du das System ganz vom Strom nimmst.

Wäre aber möglich wenn im jeden Rechner halt NVMe drin wäre.

Sind Möglichkeiten die wohl eben erst am PC kommen wenn die Mindestanforderungen daran steigen.