Lange Rede, kurzer Sinn: Ich habe ein Problem damit, gezielt Effekte auszumachen, weil sie einer GPU-Familie nicht schmecken. Ausmachen kann man das Zeug immer, aber manchmal - gerade beim anstehenden Neukauf - wüsste man aber schon gerne, wie das performen könnte, oder nicht?

.gif)

MfG

Raff

Um beide Seiten glücklich zu machen solltet ihr eventuell überlegen, eure Detailskalierung noch etwas auszubauen.

Heißt: Einmal so testen, wie man es von euch gewohnt ist, also alles auf max, egal ob sinnvoll oder nicht.

Und einmal so testen, wie es der durchschnittliche Käufer auch wirklich spielen würde: Also hohe Einstellungen, Raytracing auf Mittel/Normal und solche unnötigen Features wie Hairworks off.

Diejenigen die immer alle Regler am Anschlag haben möchten sind dann genauso befriedigt wie diejenigen, die entweder in der Mittelklasse angesiedelt sind oder die aus ihrer Hardware das bestmöglichste rausholen möchten (also beste Performance, ohne dass die Grafik sichtbar darunter leidet). Ich bin mir eigentlich sicher, dass die meisten 6800XT Nutzer die Raytracing Qualität von Ultra auf Normal/Hoch stellen werden, denn der Unterschied kann man einfach mit der Lupe suchen, der Performance Gewinn ist aber beträchtlich. Und die meisten GeForce RTX Nutzer würden doch auch nicht auf nativer Auflösung spielen, wenn DLSS2 zur Verfügung steht.

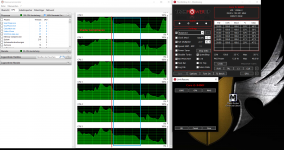

Für mich sind eure Graphen eigentlich immer null repräsentativ, denn ich optimiere meine Spiele immer perfekt an meine Hardware, während eure 160 Watt Desktop 2060 sich aufgrund unnötiger Settings und nativer Auflösung also mit 36 FPS in 1080p abmüht, habe ich auf meinem Laptop (80 Watt 2060) in eurer aufwendigen Taiga-Testsequenz stets zwischen 56 und 70 FPS in 1440p und so sieht es aus:

https://abload.de/img/metroexodus_2021_05_0d5jyk.png

Bonus screens, bei allen weit über 60 FPS:

Das ist in 1440p, aber mit DLSS Performance und CAS Sharpening.

Aber die Performance ist ja nicht nur so gut wegen DLSS Performance, sondern auch wegen den Einstellungen: Kein Hairworks, Hohe Einstellungen, Normal Raytracing. Every frame counts. Tessellation ist aber an, denn das macht einen beträchtlichen Unterschied in der Asset-Qualität, wie gesagt hier geht es um Kosten/Nutzen!

Und jetzt mal folgendes Gedankenexperiment: Würdet ihr daneben Footage eurer Desktop 2060 setzen, die nativ in 1080p und auf Ultra Einstellungen rendert, würde das besser aussehen? Mitnichten, denn der Unterschied zwischen High und Ultra, sowohl vom RT als auch von den generellen Settings ist einfach nicht der Rede wert (den größten Unterschied würden da wohl RT Reflektionen machen, die erst ab Ultra zur Verfügung stehen).

Die 1440p und stabile 60 FPS dagegen fallen sofort auf, auch wenn es nur mit DLSS Performance rekonstruiert wurde.

Das nur mal um zu zeigen, wie unfassbar weit eure Graphen von meiner persönlichen Realität entfernt sind. Ich bin sicher, ich bin nicht der einzige der die Spiele immer so an seine Hardware anpasst, um das bestmöglichste rauszuholen. Von daher wäre es wirklich super, wenn ihr eure Detailskalierung noch etwas ausbauen könntet, denn diese ist ein riesiger Schritt in die richtige Richtung!

.gif)

Alternativ rutschst du da mit dem treibereigenen Image Sharpening drüber.

Alternativ rutschst du da mit dem treibereigenen Image Sharpening drüber. Leider ist der einzig in Frage kommende Schirm nicht wirklich lieferbar (LG 27GN950-B).

Leider ist der einzig in Frage kommende Schirm nicht wirklich lieferbar (LG 27GN950-B).

Das Gedöns liegt unter \Gespeicherte Spiele\metro exodus bzw. im Root-Verzeichnis des Spiels im Falle der GoG-Version.

Das Gedöns liegt unter \Gespeicherte Spiele\metro exodus bzw. im Root-Verzeichnis des Spiels im Falle der GoG-Version.