AW: GPU-Verkäufe bei Mindfactory: Radeon RX 5700 XT deutlich vor GeForce RTX 2060 Super

Dann informiere dich mal über die neue Implementation in Wolfenstein. DLSS schlägt die native Auflösung mittlerweile

Ich bin zwar aus Bequemlichkeit und wegen ein paar Anwendungen und Games Windows-Nutzer, dennoch ist diese Implementation wieder "nur" der Weg, den Nvidia geht.

Versteht mich nicht falsch: Die Idee dahinter ist gut, die Umsetzung wird immer besser. Was wurde aus anderen Technologien?

Trotz GSync öffnet sich Nvidia immer weiter für FreeSync-Monitore und PhysX kam nie über die Einstufung "Spielerei" hinaus und landet nun meistens als Implementation für die CPU in einem Spiel, wenn es überhaupt genutzt wird. Nach Jahren des Stillstands im Mainstream bei 4 Kernen / 8 Threads ist nun bei Intel und AMD mit mindestens 6 Kernen bei Gamern genug CPU-Zeit für eine grundlegende Darstellung übrig.

Ohne DLSS muss man für höhere Auflösungen ganz klassisch Details, Sichtweite und ggf. Schatten, Texturen eine oder mehrere Stufen niedriger einstellen, was bisher eben auch funktionierte. Je nach nativer Monitor-Auflösung kann man das ja noch mit Downsampling / VSR kombinieren. Ich schweife ab, aber eine RTX 2070 non-Super und 2060 Super haben eben auch weniger Tensor-Cores.

Ob und wie sich DLSS durchsetzt, wird die Zeit zeigen.

Vermutlich trifft es da gut, es ist nur eine Vermutung, hierzu nochmal das Video von Gamers Nexus, welcher mit seiner Community sprach und wo es nicht um übertaktete oder undervoltete Karten ging.

Bei Nvidia gibt es die Tools der Partner.

Die meisten Nutzer werden gar keine Tools installieren, in Foren wie diesem ist die Zahl der Nutzer natürlich relativ hoch. Insgesamt habe ich nichts gegen Nvidia, der AMD-Treiber und dessen Panel wirken inkl. Auto-OC-Funktion, das Overlay und den sonstigen Features nur viel frischer.

Muss man sich für Geforce-Experience und das Auto-Update eigentlich noch anmelden?

Die kommen bei den problembehafteten Radeon Karten, sofern sie mal 1,5 Jahre am Markt sind, sicherlich ähnlich rüber.

Je länger Karten am Markt sind, desto höher sind die Ausfallraten.

...

Ein bekannter Shopbetreiber, den ich hier nicht nenne werde, weil diese Informationen nicht für die Öffentlichkeit bestimmt sind. Aber du kannst ja mal die RMA Quoten der Radeon 5700XT Karten nehmen, welche teilweise bei 4, 5 und 6% liegen, was so kurz nach Launch relativ hoch ist und die Quoten von Turing nach einem halben Jahr teilweise übersteigt.

Ich habe letztes Wochenende für einen Freund einen kompletten PC gebaut (Ryzen 7 3700X, Asrock X570 Steel Legend, 2x 16 GB G.Skill DDR4-3200) um seinen alten i5 2500K komplett zu ersetzen. Die Grafikkarte wurde eine XFX Radeon RX 5700 DD, da diese schon letzten Monat für 285€ gekauft wurde. Das Asrock wurde es einfach, weil Board-Layout, Ausstattung für den Preis gefielen.

Gigabyte fiel wegen problembehafteter BIOS-Updates in der Vergangenheit raus (B450 Aorus M) und Asus, weil mir die einfache Verdreifachung der Komponenten der Spannungsversorgung ohne Doppler nicht zusagt.

Ich habe neben dem aktuellsten BIOS noch die aktuellen Chipsatztreiber vom 16.01.20 und den Crimson

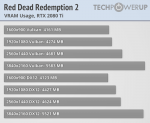

20.1.2 installiert. Die Tests in Rage 2, Star Citizen und Red Dead Redemption 2 zeigten keinerlei Probleme oder Auffälligkeiten.

Was ich eigentlich sagen will:

Man liest vielerorts von Problemen mit der 5700XT, kann es sein, dass diese öfter betroffen ist als die non-XT?

Eine weitere Möglichkeit wäre das BIOS oder die Umsetzung beim jeweiligen Hersteller, alles vor AGESA 1.0.0.4 habe ich persönlich quasi nie live gesehen (in Verbindung mit Ryzen 3000 und einer AMD Navi-GPU).

Die dritte Variante wären in den letzten Monaten Treiberprobleme, vielleicht auch in Verbindung mit den aktuellen Ryzen-CPUs und deren BIOS (PCIe 4.0).

Viele mit Problemen sprechen in Foren vom

19.7.5 als bestmöglichen Treiber. Vielleicht hat sich die Situation auch gebessert, zumindest wir haben nichts vor 20.1.1 probiert und es gab keine Probleme (trotz Nutzung von Anti-Lag, was manche als Verursacher sehen).

Damals hat man recht prominent darüber berichtet, der Witz war nur, dass damals die Ausfallraten auch noch relativ gering waren und das ganze ein Spiel auf Zeit ist.

Wenn ich mich recht erinnere, traf es damals vor allem die ersten Chargen der RTX 2080 Ti, teils auch 2080, welche nach 2 Wochen Gaming-Betrieb Anzeichen defekter Speicher aufzeigten. Da kann einem bei dem gezahlten Preis schon etwas die Hutschnur platzen. Das Pech einer defekten Karte kann auf der anderen Seite aber immer und bei jedem Hersteller zuschlagen. Meine Ersatz-Karte ist eine laute R9 290 im Referenz-Design von 2013, welche noch immer läuft.

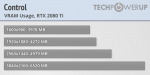

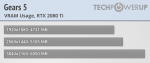

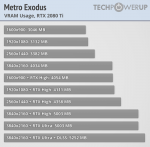

ich sehe den V-ram Bedarf, trotz eigener 24GB Karte deutlich weniger relevant an als viele, ganz einfach weil man bei einer Mittelklassekarte nicht den Anspruch an maximale Details hat und es diese auch nicht immer braucht um sehr schöne Texturen zu genießen.

Das stimmt, man kann einfach nicht in jeder Preisklasse erwarten alles auf "maximal" zu stellen und flüssig zu spielen. Games, deren Ultra-Settings nicht das Maximum darstellen, zeigen gut, wie schnell selbst teuerste Hardware an die Grenzen gebracht werden kann, wenn man nicht weis, was man gerade macht.

Mir persönlich geht es bei der Vorliebe für 8 GB-Empfehlungen eher darum, dass beispielsweise bereits Middle-Earth: Shadow of War 2017 8 GB VRAM in 1080p gut füllen konnte und man schon seit Jahren in Form der R9 390, RX 480 / 580 jeweils 8 GB VRAM um die 300€ bekommt.

Ich möchte Intel und AMD zwecks der Vergleichbarkeit halber mit gleich teurem RAM vergleichen, damit sich die Aussagekraft der Tests erhöht

Sicherlich, deshalb kann man doch gerne sämtliche Prozessoren innerhalb deren Spezifikationen testen, um die Leistung von OEM Systemen von der Stange zu ermitteln, da hat doch überhaupt niemand etwas dagegen.

In diesem Punkt stimme ich dir zu. Es sollte Tests nach Spezifikation geben, allerdings sollte man diese mittlerweile erweitern um zusätzliche Tests, da keiner mehr unter DDR4-3000 kauft.