Das Problem ist nur - es ist KEIN 4k. Nur deshalb läuft es.

Ja, und das ist doch völlig okay. 4K mit RT wäre ja auch eine völlig übersteigerte Erwartung, das wird auch eine Karte von der nächsten und übernächsten Generation nicht auf den Schirm bekommen.

Genausowenig gibt es heute eine Karte die in 4K mit maximalen Details alles flüssig darstellst, viele Titel laufen selbst auf einer Titan RTX in 4K nicht mal mit 40 bis 50 FPS.

Quatsch von einem Clown. N7 FEOL bringt 7% und N7 MOL 10% höhere Effizienz. N7+ eine bis zu 18% höhere Packdichte. Das wars. +50 klar.

Damit ist der Sprung von 12nm auf 7nm+ gemeint und den hat Nvidia vor sich und der ist riesig.

AMD hat ja ihr Pulver weitgehend verschossen und kann sich dann nur noch auf die von dir genannten Verbesserungen von 7nm + freuen.

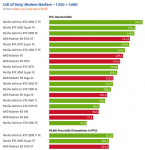

Das Lustige ist ja, dass bei aktuellen, fordernden Spielen die RX5700XT bereits auf Augenhöhe mit der 2080 super ist...

Nicer Cherrypick, bald ist die Kate so schnell wie eine 2080 Ti.

effizienztechnisch deutlich überlegen bzw. in einer ganz anderen Liga spielt.

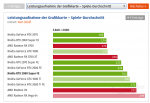

Also grundsätzlich liegen zwischen 5700XT und 2080 Super 20 bis 30% Leistung, je nach Auflösung im PCGH Index.

Ich kann mir immer Spiele herauspicken die auf Kare A oder B schneller bzw. langsamer laufen und dann irgendwelche Behauptungen machen.

Tatsache ist, die Karte liegt im PCGH Index gleichauf mit einer RTX 2070, da muss ich jetzt nicht hergehen und und irgendetwas erzwingen oder schönreden.

Dabei ist jetzt noch nicht mal Next Gen. angesagt, dass kommt noch und mit RDNA2 und verbesserter 7nm+ EUV Fertigung lässt AMD nächstes Jahr so richtig seine Muskeln spielen.

Wenn Nvidia keine neune Produkte herausbringt und weiterhin bei 12nm bleibt, dann vielleicht, aber die Uhr dreht sich ja weiter.

Eine hypothetische RX5750XT mit 3072 shading units und schnellem Speicher, würde die 2080 super aber sowas von zersägen.

Hypothetisch, ja richtig. Hypothetisch könnte AMD viel leisten, aber das entspricht nicht der Realität.

AMD muss mindestens 1 Generation aufholen, was nicht mal ganz mit der 5700XT geschafft haben, trotz enormem Fertigungsvorteil.

Früher war der Hersteller mit dem neuesten Proezess immer vorne, da sieht man, wieviel Rückstand AMD hat.

Keine Ahnung von wo das Ammenmärchen kommt, dass NVIDIA's Architektur so überlegen sein soll.

Weil sie halt schon vor über einem Jahr die Leistung einer 5700XT mit leicht geringerem Verbrauch und in einem veralteten Fertigungsprozess auf dem Markt gebracht haben.

Und Ampere wird, was die Entwicklung ansteht, ja nicht auf der Stelle treten.

Wie will man das wegkühlen wenn man den Takt noch anheben will?

Wie will man das denn bei AMD wegkühlen, wenn eine 5700XT schon 210 Watt in 7nm säuft und noch +50% auf eine 2080 Ti fehlen?

Dort stellst du dir die Frage offenbar nicht, dabei hat Nvidia schon seit längerem viel weniger Kühlungsprobleme als AMD. Das macht eine detlich effizientere Architektur eben aus.

.

.

??

??