derneuemann

Volt-Modder(in)

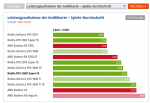

Na, warten wir ab, wie es sich entwickelt, wenn immer mehr LL-API Titel in die Parcoure wandern mit Engines, die verstärkt mixed Szenarien (Integer + Float) nutzen. Die 50% werden sich never ever halten. Wenn man Titel wie CoD Modern Warfare (2019), RDR2 und BF5/Anthem betrachet, dann liegt der Abstand sogar bei weit unter 30%.

Es steht dir natürlich völlig frei, auf 4k rumzureiten, um einen möglichst großen Abstand zu konstruieren.

Sorry, aber das ist für mich nicht nachvollziehbar. Dir steht es aber natürlich frei zu denken was du willst! Du solltest aber keine Motivationen in etwas herein interpretieren, die es so nicht gibt.

Zum ersten Teil würde es mich natürlich freuen!

Zum Rest, dir steht es natürlich frei, wie jedem anderem auf der Welt, sich einfach mal alle Benchmarks des Jahres anzuschauen und dazu noch unterschiedliche Tests! Was zu einem etwas andern Bild führt, als das in deinem Kopf.

Aktuell sind es eben über 50% unter maximale, von Spielen erzeugter Grafiklast.

Dir ist auch klar, das ein Big Navi, oder ein Big RDNA2 auch nicht seine volle Mehrleistung unterhalb 4K entfesseln wird, oder? Wenn ein Big RDNA 2 letztendlich spekulativ maximal 70% schneller ist, als die 5700XT. So werden das in 1080p bei weitem keine 70% sein.

Darf ich mal deine Benchmarks dazu sehen?

Unter 4K ist jede GPU komplett GPU limitiert - das sieht man daran das es egal ist welchen Prozessor man verbaut hat. Da ist ein 1800x genauso schnell wie ein 9900k. Zwischen beiden CPUs liegen in Spielen sicher 25%.

Partielles CPU Limit - was soll das sein? Teilweises CPU Limit - habe ich noch nie gehört.

Wenn es anfängt, das alle GPUs dichter zusammen rücken. Unabhängig vom internen Aufbau. Anders herum ist es doch auch immer wieder so, das die großen GPUs in 1080p Auslastungsprobleme haben. Alles Gründe die einem als Leistungsbetrachtung die 4K Werte nahelegen sollten.

Das ist wie CPUs nur in 4k Benchen, ist genau so ein quatsch wie GPUs nur in 1080p. Das sieht man viel, aber nicht die tatsächliche Leistung der Hardware.

Das die 2080 super bei den Initialen Reviews, bis zu 30% besser abgeschnitten hat als die RX5700XT hat doch zum gegenwärtigen Zeitpunkt keinerlei Bedeutung mehr.

Das eine nagelneue Architektur gewisse Startschwierigkeiten hat, ihre PS auch auf die Strasse zu kriegen, sollte doch mittlerweile bekannt sein: Zum einten muss sie sich in einem veralteten Testparcours, der zuvor noch nie etwas von NAVI mitbekommen hat der Konkurrenz stellen und zum anderen ist es ganz normal das die Treiber zu Beginn nicht das gelbe vom Ei sind.

Weswegen die 30% zum gegenwärtigen Zeitpunkt nur Schall und Rauch sind, in einem gewissen Sinne eine Rauch und Blendgranate

die, die Realität nicht ansatzweise wiederspiegelt und bei gewissen Usern hat sich der Rauch anscheinend immer noch nicht vollständig verzogen.

Übrigens was die Zuversicht das NVIDIA auch bei den kommenden GPU's überlegen sein wird anbelangt, würde ich mich nicht zu weit aus dem Fenster lehnen, denn der Aufprall könnte ziemlich heftig werden.

AMD musste in der Vergangenheit, die Entwicklung bei den GPU's auf Sparflamme setzten und NVIDIA hat zugleich seine Hausaufgaben gemacht.

Dies wird aber bei den kommenden Entwicklungen nicht der Fall sein und bezüglich RDNA2 kann keiner sagen wie hoch die IPC Steigerung im Vergleich zu RDNA sein wird.

Ach ja, die Hoffnung auf eine RX5800(XT) alias NAVI 12 habe ich auch noch nicht komplett aufgegeben. Falls sie wirklich noch Anfang 2020 als z.B.: RDNA, Die Size 300-360mm2, 4096, 3860, 3584 oder 3328 Shader mit 16Gbps GDDR6 256bit oder 14Gbps 384bit und einem Verbrauch von ca. 250 - 275 W kommen sollte, wird die Karte alles hinwegfegen was bis drei nicht auf den Bäumen ist. (Die 2080ti aussen vor, die wird wohl bis auf wenige Ausnahmen erst von RDNA2 richtig vernascht)

Ich wollte noch auf den Verbrauch der 2070 von ca. 170 W eingehen, der immer wieder als Beispiel für die bessere Effizienz im Vergleich zu den 210W der RX5700XT hervorgehoben wird.

Dies sollte man doch noch etwas relativieren, da sie doch ein gutes Stück langsamer, mit der Tendenz bei kommenden Spielen den Anschluss komplett zu verlieren ist.

Beziehungsweise sich dann lediglich mit der RX5700 zu duellieren.

Beide Architekturen sind somit in etwa gleich effizient.

Unter diesem Gesichtspunkt sollte eine 5800(XT) mit ca. + 20-40% relativ zur RX5700XT und einem Verbrauch von ca. 250 -275W eigentlich nichts im Wege stehen diese Karte wäre bestens geeignet als schnellen Appetitmacher bevor RDNA2 aufschlägt in die Lücke zu stossen.

Die 2070 Super ist auch effizienter, weiter zum nächsten Punkt.

Mal angenommen ein Big Navi kommt mit 60% mehr Recheneinheiten. Dann müsste der Takt bestimmt um ca13% runter um in etwa mit 250W auszukommen. Mehr Recheneinheiten skalieren nach allen Tests zu GPUs die ich bisher gesehen habe nie 1 zu 1 in mehr Leistung. Realistisch sind eher 60% mehr Recheneiheiten resultieren in etwa 40% mehr Leistung. Dazu den reduzierten Takt, damit die Leistungsaufnahme nicht explodiert. Dann kommt man am Ende auf rund 23% mehr Leistung als eine 5700XT. Sagen wir ich bin zu pessimistisch und es sind eher bis zu 30%.

Damit wird ein Big Navi niemals eine 2080Ti zum Boden aufwischen nutzen!

Wenn gleich eine derartige GPU extrem interessant finden würde. Ich bin übrigens einfach mal von 16 Ram ausgegangen.

Deine Erwatrungshaltung bezüglich der Leistung in kommenden Spielen, von 5700Xt und 2070(Super) denke ich sind etwas zu optimistisch, aus AMD Sicht.

Hallo zusammen,

werde mal schauen, was auf dem Markt kommt (Karte), sobald

Cyberpunk 2077 draussen ist. Wahrscheinlich wirds eine Ampere

werden, da ja vom Spiel Raytracing unterstützt wird.

Viele Grüße,

Schnitzel

AMD wird auch demnächst Ray Tracing unterstützen!