Borkenpopel1

Software-Overclocker(in)

Da sie aktuell etwa gleich (bescheiden) boosten - nö, 3700X. Die CPUs sind identisch bis auf den Takt.

Wieso? Weil es besser für die Gleichung passt? 9900KS =8 Kerne 16 Threads, Teuer und nicht Notwendig, schnellster 8 Kerner+HT von Intel ; 3800X= 8 Kerne 16 Threads, Teuer und nicht Notwendig, schnellster 8 Kerner+ SMT von AMD PUNKT

@Duvar: Du entwickelst dich aktuell LEIDER zum Schaffe der AMD Fraktion.....lass einfach gut sein und sei glücklich mit deiner CPU (die ich ernsthaft jedem mit kleinerem Budget empfehle)....Du betreibst mittlerweile (genau wie die einschlägigen NVIDIA/INTEL- Nazis hier im Forum) das selbe krasse Cherry-Picking und beharrst stur nur auf deiner Meinung...Früher habe ich gerne deine Beiträge gelesen...Gut gemeint von mir, soll kein ANgriff sein, nur etwas zum nachdenken

Ok, krass! Dachte bei dir auch immer, dass du wenigstens ETWAS Ahnung hast....Nö

Die erreicht er auch nicht. Also genau das, was Intel jetzt auch AMD vor den Latz knallt.

Zuletzt bearbeitet:

). Wo der SingleCore-Boost-Takt liegt, weiß ich nicht, jedoch dürfte der für die Gesamtperformance relativ irrelevant sein.

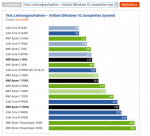

). Wo der SingleCore-Boost-Takt liegt, weiß ich nicht, jedoch dürfte der für die Gesamtperformance relativ irrelevant sein. ) sieht! Die Anwendungen die du gezeigt hast, laufen alle sehr gut auf AMD, aber d hast z.B. keine Spiele mit z.B. den Verbräuchen gezeigt.

) sieht! Die Anwendungen die du gezeigt hast, laufen alle sehr gut auf AMD, aber d hast z.B. keine Spiele mit z.B. den Verbräuchen gezeigt.  .Wir sind ja beide der Meinung, dass beide Hersteller GRUNDSÄTZLICH auf Augenhöhe sind (mal der Eine vorne, mal der Andere) und beide sehr gute Produkte haben. Wem welches Produkt, welchen Preis wert ist, muss ja am Ende jeder für sich entscheiden

.Wir sind ja beide der Meinung, dass beide Hersteller GRUNDSÄTZLICH auf Augenhöhe sind (mal der Eine vorne, mal der Andere) und beide sehr gute Produkte haben. Wem welches Produkt, welchen Preis wert ist, muss ja am Ende jeder für sich entscheiden

.gif) mir ist wurst was die cpu zieht solange ich das leise weggekühlt bekomm.

mir ist wurst was die cpu zieht solange ich das leise weggekühlt bekomm.