M

Marlboro0815

Guest

Hier will keiner Beweisen das PCGH falsch liegt, hier will man nur aufzeigen, dass deine reißerischen Texte nicht dem entsprechen was einer zu erwarten hat!Von so einem versierten Nutzer wie dir erwarte ich eigentlich etwas mehr Anspruch. Wir nutzen dieses System auch nicht nur 20 Sekunden. Der ganze Vorgang, mit Aufwärmen, "einruckeln", Spielstände laden, durch die Spielwelt laufen und so weiter dauert viele Minuten und bringt jeden Prozessor, den wir testen, in seinen regulären, vorgesehenen Betriebszustand. Erst dann folgt der Benchmark. Genau in diesem Zustand nutzt jeder von euch seinen Prozessor, wenn er zockt. Der einzige Unterschied ist nur, dass wir die CPU nicht künstlich bremsen, mit einem Fps-Limit etwa und auch nicht weiter verändern (OC, Undervolting, SMT etc.), da es sonst nicht möglich wäre, die Prozessoren untereinander fair zu vergleichen. Zudem erfolgt nicht nur eine Messung, sondern mehrere und wir bilden daraus einen Durchschnittswert.

Wenn ihr mir hier allerdings mit Vergleichen ankommt, bei denen ihr in einer x-beliebigen (nicht vergleichbaren!) Szene in UHD mit Fps-Limit testet, oder wie bei dir im Fall im GPU-Limit, und das als Basis für eure Argumentation nutzt, um zu "beweisen", dass PCGH "falsch" testet, ist diese Diskussion hier für mich beendet. Da kann ich nur noch mit dem Kopf schütteln

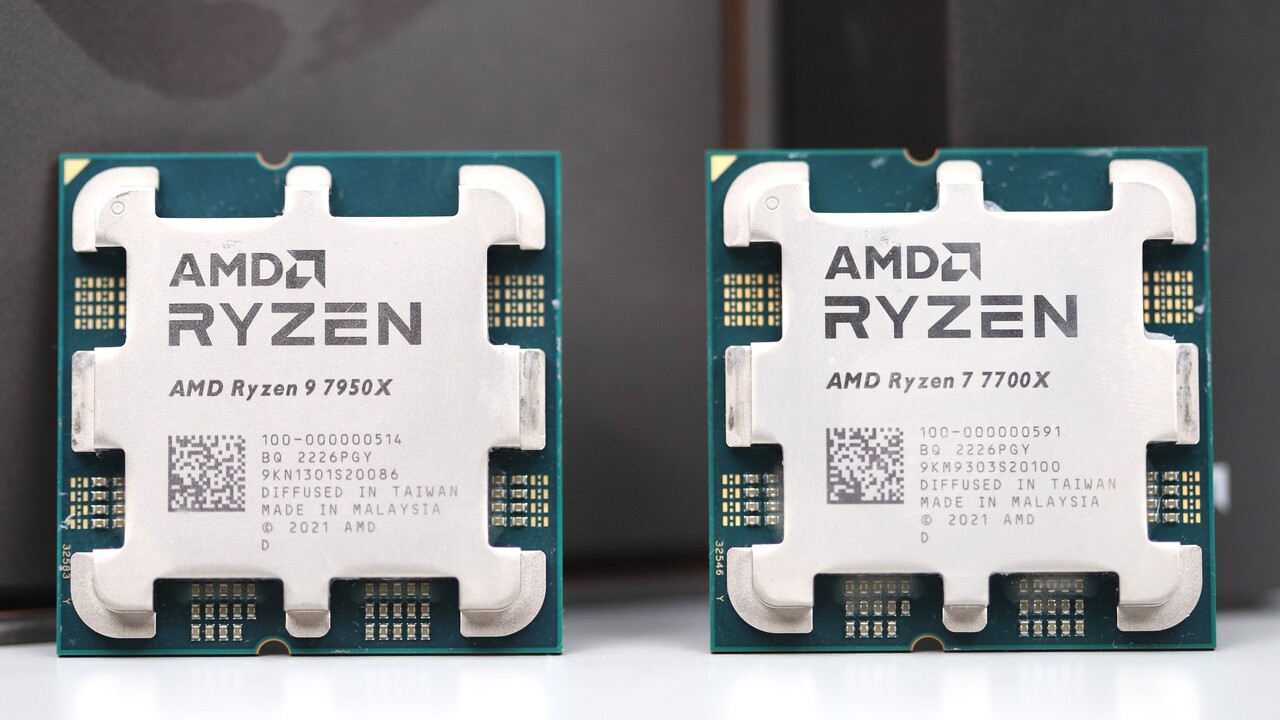

Hier noch ein Screen für euch, denn das kann ich schon lange:

Anhang anzeigen 1438357

"Wie, mein 7800X3D zeigt ja nur 23,6 Watt an. Das bedeutet, die PCGH muss falschliegen, denn die sagen ja, dass die CPU das dreifache verbraucht! Da arbeiten ja nur Stümper. Dass ich mit einem Fps-Limit zocke, spielt dabei überhaupt keine Rolle und auch nicht, dass ich nicht in der gleichen Szene vergleiche. Die Grafikeinstellungen sind auch nicht die gleichen, aber so zocke ich das Spiel halt. Ich hinterfrage den Software-Sensor auch nicht, der wird schon stimmen, ist ja immerhin ein teures Mainboard gewesen! Und ich hab meine CPU ja auch optimiert und SMT abgeschaltet und undervolted, das passt bestimmt zu den Specs der CPUs, welche die Redaktion getestet hat. Die von PCGH haben ja keine Ahnung. Hinterwäldler-Forum hier, ich lösche jetzt meinen Account."

Wenn man sich deine Berichte durchliest könnte man annehmen das die Intel CPU dauerhaft 230w Anliegen hat! Da wird kein Satz „es kann aber ist nicht immer der Fall“ erwähnt! Du lobhudelst nur die ganze Zeit „deine CPU“ und das nervt gewaltig! Ihr wollt Geld verdienen? Dann macht einen Plus Artikel „wie bekomme ich den Intel sparsam aber schnell hin“

Genau das ist nämlich möglich mit der Intel CPU! Aber du erwähnst da keine Silbe und das schlimmste daran ist du wirst ja nicht mal sachlich wenn es um Intel geht sondern emotional! Das sich ein Redakteur lustig macht, wenn User ihre Accounts löschen lassen wollen zeigt mir eigentlich wie sch… egal dir Leute sind weil die unangenehm sind und den Funfaktor AMD ist so toll und geil und alles andere besprechen wir nicht mehr…

Eigentlich ist genau das zum Fremdschämen!

.gif)