Nicht zwingend. Das Hauptproblem bei den 3D Zens ist dass der Kern durch den Cache heizt und erst dann der Heatspreader kommt. Intel will ja den Kern nach oben stapeln, dann wird der wieder direkt gekühlt.Mit 3D Cache werden aber sicher keine Taktrekorde mehr aufgestellt. Auch die 250W oder was die sich auch immer genehmigen dürfen sind dann Geschichte. Intel würde mit 3D Cache daher zwar auf der einen Seite einen Mehrwert haben, müsste zwangsläufig aber an anderen Stellen kürzer treten.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Intel bestätigt eigene Art des 3D V-Cache mit L4-Cache statt Level 3

- Ersteller PCGH-Redaktion

- Erstellt am

"Das Hauptproblem bei den 3D Zens ist dass der Kern durch den Cache heizt und erst dann der Heatspreader kommt."

Laut AMD und PCGH und ... ist das anders:

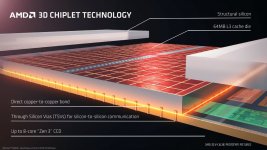

Der 3D-Cache kommt auf den vorhandenen Cache und ist daher höher als der Core-Bereich - daher muss der Core-Bereich mit "structual silicon" auf die gleiche Höhe gebracht werden.

Laut AMD und PCGH und ... ist das anders:

Der 3D-Cache kommt auf den vorhandenen Cache und ist daher höher als der Core-Bereich - daher muss der Core-Bereich mit "structual silicon" auf die gleiche Höhe gebracht werden.

Anhänge

H

hoppel_die_pop

Guest

Rein fürs gaming könnte dies zutreffen, da bringen die e cores noch nicht super viel, wobei auch die mittlerweile recht schnell sind. Könnte sich auch ändern und vielleicht koomplexe games woe MS Flugsim, Anno, Star Citizen wo viele komplexe Berechnung gleichzeitig laufen massiv davon profitieren könnten. Dort hängt es eher massiv an den Engines. Selbst heute haben noch viele Engines Probleme überhaupt mehr als 4 Kerne wirklich effektiv zu nutzen. Bei 6 ist dann eh beim Großteil Schluss und nur wenige Engines/Spiele können mehr als 8 Kerne nutzen.Bitte nicht. E-cores sind eine ganz schlechte Idee und ein Holzweg. Intel hat die einfach nur aus Zwang eingeführt weil ihre Energieeffizienz so gammelt. Das sollte sich mit echtem EUV wieder ändern, dann kann Intel die E-cores wieder abschaffen.

Vorallem aber im office Betrieb oder Multimedia/Bild Bearbeitung bringen die E-cores schon jetzt riesen Vorteile. Da sind z.b. beim Rendern/Videobearbeitung dadurch die Intel cpu AMD komplett überlegen. AMD schaut dort nur noch aus der Reservebank zu. Niemand der klar bei Verstand ist würde für Streaming, Videoschnitt, Rendering ein Ryzen 7800x3d einem I7 13700k vorziehen.

sandworm

Software-Overclocker(in)

Aber welcher Privatanwender macht das heute noch daheim.Niemand der klar bei Verstand ist würde für Streaming, Videoschnitt, Rendering ein Ryzen 7800x3d einem I7 13700k vorziehen.

Früher war das für mich noch ein Kriterium weil ich all meine Filme mit einer separaten TV Karte aufgenommen habe und danach geschnitten und konvertiert, auch meine DVD und Blu-Ray Sammlung hatte ich noch konvertiert.

Aber heute. Die paar Nasen die das heute noch in ihrere Freizeit erledigen, muss man wohl irgendwo in einer Lodge in Feuerland suchen, bevor sie für 6 Monate in die Antarktis aufbrechen. Heute zählt nun mal nur Gaming, Gaming und nochmals Gaming und da ist der 7800X3D bis zu 3 Mal so effizient wie der 13700K dass ist einfach Tatsache.

Selbst wenn mal noch etwas anstehen sollte, lässt man solche Sachen in die Nacht hinein laufen und da spielt es keine Rolle ob man nun nur einen 8 Kerner, oder einen 24 Kerner hat. Am nächsten Morgen ist es so oder so fertig und für professionelle Anwendungen gibt es entsprechend andere Lösungen.

Rollora

Kokü-Junkie (m/w)

Nicht wirklich.Das könnte den Untergang von AMD einleiten.

Intel hält mit AMD im moment mit extremen Verbräuchen mit, die würden dann halt sinken.

In anderen Bereichen hat AMD ob mit oder ohne Cache die Nase nach wie vor vorne (Epyc und Co), super Angebote hätte man auch ohne Cache etc.

Außerdem würde Intel das nicht flächendeckend einführen sondern nur für gewisse Modelle, weil - zu teuer.

Hier vom Untergang zu fantasieren hilft nicht, der "Untergang" kam ja auch schon 2017 für Intel in der Form von "Zen". Dann nochmal mit Zen 2 und Zen 3+ Cache. Zen 4. Und sowieso Zen 5...

Als AMD den Cache eingeführt hat, wusste doch wohl jeder, dass auch Intel diese Option hat, oder?

Das Ergebnis ist das selbe. Der Extradie für mehr Cache liegt über der ursprünglichen CPU, Intel plant zumindest mittelfristig mit darunter. Dass der Teil über den Kernen nichtmal funktional ist macht es nicht besser."Das Hauptproblem bei den 3D Zens ist dass der Kern durch den Cache heizt und erst dann der Heatspreader kommt."

Laut AMD und PCGH und ... ist das anders:

Der 3D-Cache kommt auf den vorhandenen Cache und ist daher höher als der Core-Bereich - daher muss der Core-Bereich mit "structual silicon" auf die gleiche Höhe gebracht werden.

MajoPCGH

Komplett-PC-Aufrüster(in)

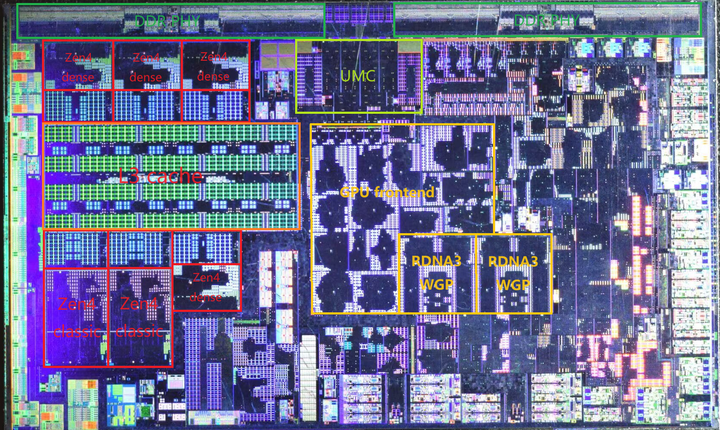

Nennt sich bei AMD Zen 4c und existiert bereits.

Sind halt einfach deutlich komprimierte Zen 4-Cores, die allerdings auch deutlich niedriger takten werden und wegen zwangsläufig höherer Spannung bei gleichem Takt weniger effizient laufen werden als große Zen 4-Kerne, allerdings wird man da nicht so blödsinnige Probleme haben wie dass bestimmte Befehlssätze nicht gehen, wie anfangs bei Intels Architektur-Mix.

Wieso "zwangsläufig höhere Spannung" - Intel bekommt es doch auch hin die e-cores im gleichen Silizium mit einer eigenen Spannung anzusprechen. Warum sollte AMD das nicht können und die trotz geringerem Takt mit dem gleichen vcore wie die großen Kerne befeuern?

Ich sehe den AMD Ansatz auch deutlich positiver und näher an dem was ARM mit big.little macht als Intels eher seltsames Konzept.

Das Problem sind nicht verschiedene Spannungen sondern dass die kompakten (dense) C-Kerne ab 2GHz eine steiler Spannungskurve brauchen um stabil zu laufen.Wieso "zwangsläufig höhere Spannung" - Intel bekommt es doch auch hin die e-cores im gleichen Silizium mit einer eigenen Spannung anzusprechen. Warum sollte AMD das nicht können und die trotz geringerem Takt mit dem gleichen vcore wie die großen Kerne befeuern?

AMD Ryzen Z1 (7540U/Phoenix2) 简单测试

名字少一个 Extreme,到底少了什么?2023年发售的Ryzen Z1或者说Ryzen 5 7540U虽然表面上不起眼,但它其实是非常不同寻常的一个SoC: AMD打破Zen2以来的传统,少见的专为Ryzen 5 SKU设计了Phoenix2 SoC,而非使用…

MajoPCGH

Komplett-PC-Aufrüster(in)

Das Problem sind nicht verschiedene Spannungen sondern dass die kompakten (dense) C-Kerne ab 2GHz eine steiler Spannungskurve brauchen um stabil zu laufen.

Alles klar - die Info hatte ich noch nicht.

Bietet ja dann Raum für Optimierungen in den 5c Kernen.

Bedeutet dann dass AMD im Notebook-sektor im Teillast - Bereich weiter einen schweren Stand haben wird.

Das ist aber auch heute schon so, also nix neues. Im idle spielt der Umstand eher keine Rolle (und da hat AMD ja auch Schwächen), unter Volllast kommt es jetzt drauf an wie weit sie die Dinger an die kotzgrenze prügeln, aber durch die Elend saufenden p-cores haben sie ja theoretisch ne Menge Spielraum

BigBoymann

BIOS-Overclocker(in)

Aber auch größte Stärke!!!Das monolithische Design war bisher Intels größte Schwäche

Vergisst man gerne, dass Intel mit Arrow Lake auch gut auf die Schnauze fallen kann, da man auf einmal mit Latenzen zu tun bekommt, die man bisher nicht hatte

BigBoymann

BIOS-Overclocker(in)

Auch hier wird Intel Federn lassen, denn auch hier wir ein SoC kommen der dauerhaft Strom braucht. Evtl. wird Intel aber einen Vorteil behalten, da man vermutlich durch die Kerne im SoC den Rest abschalten kann, während AMD immer SoC und CCD aktiv haben mussBedeutet dann dass AMD im Notebook-sektor im Teillast - Bereich weiter einen schweren Stand haben wird.

H

hoppel_die_pop

Guest

Da stimme ich dir zu. Deshalb habe ich sogar noch einen billigen I5 10400f. Der reicht aktuell für mein Lieblingsspiel voll aus uns bringt meine lahme rtx3060ti immer 100% ans Limit. Aber bräuchte ich eine neu cpu wäre es aktuell auch ein 7800x3d. Aber das hat noch wohl noch ein paar Jahre Zeit. Vorher brauche ich erst ne schnellere gpu.Aber welcher Privatanwender macht das heute noch daheim.

Früher war das für mich noch ein Kriterium weil ich all meine Filme mit einer separaten TV Karte aufgenommen habe und danach geschnitten und konvertiert, auch meine DVD und Blu-Ray Sammlung hatte ich noch konvertiert.

Aber heute. Die paar Nasen die das heute noch in ihrere Freizeit erledigen, muss man wohl irgendwo in einer Lodge in Feuerland suchen, bevor sie für 6 Monate in die Antarktis aufbrechen. Heute zählt nun mal nur Gaming, Gaming und nochmals Gaming und da ist der 7800X3D bis zu 3 Mal so effizient wie der 13700K dass ist einfach Tatsache.

Selbst wenn mal noch etwas anstehen sollte, lässt man solche Sachen in die Nacht hinein laufen und da spielt es keine Rolle ob man nun nur einen 8 Kerner, oder einen 24 Kerner hat. Am nächsten Morgen ist es so oder so fertig und für professionelle Anwendungen gibt es entsprechend andere Lösungen.

Thomas5010

Software-Overclocker(in)

Lieber Wurstkuchen (wie kommt man auf solche Namen?, egal)Nein. Sind sie nicht. Das ist ein absoluter Holzweg und Verschwendung von Chipfläche. Es bedarf komplizierte Kernel/OS und auch App Anpassung um diese korrekt zu nutzen und dann funktioniert es immer noch nicht so gut, als hätte man x gleiche Kerne. Es ist ein schlechtes Design dies auf einem x86 System umzusetzen. Auf einem Handy mag das funktionieren mit ARM aber nicht bei x86 und Windows ohne Komplikationen. Der bessere Weg ist x gleiche Kerne zu haben die aber alle samt energieeffizient arbeiten und der Kernel Scheduler diese optimal nutzt und auch energiesparend. Dazu kommt auch noch dass die e-cores von Intel gar nicht wirklich zur Energieeffizient beitragen, wieso nicht? Weil es im Grunde fast identische P-cores sind. Intel hat dort den Branch Predictor anpassen müssen, sonst würden die e-cores ja einfach absolut gammel Leistung bringen.

Gut, dass wir deine Expertise haben

.gif)

Dann waren Qualcomm, ARM, Apple, Intel und nun auch AMD tatsächlich auf der falschen Fährte.

Das klingt wie ein riesengroßer Fail. Wenn das stimmt, dann sollten die Ganzen Milliardenschweren Tech Firmen dringend bei dir Rat suchen. Unglaublich

Wobei die Aufteilung die wir aktuell von Intel bekommen definitiv eine Mobile Aufteilung ist, keine für Arbeitsmaschinen. Apple packt in die Ultra Variante für die großen Macs deutlich mehr P-Kerne als E-Kerne. Im Server Markt kann man sich bei AMD wie Intel je nach Einsatzzweck zwischen reinen P oder reinen E Kernen entscheiden. ARM hat bei den großen Kernen für Server ebenso garkeine little Anteile dabei.Lieber Wurstkuchen (wie kommt man auf solche Namen?, egal)

Gut, dass wir deine Expertise haben

Dann waren Qualcomm, ARM, Apple, Intel und nun auch AMD tatsächlich auf der falschen Fährte.

Das klingt wie ein riesengroßer Fail. Wenn das stimmt, dann sollten die Ganzen Milliardenschweren Tech Firmen dringend bei dir Rat suchen. Unglaublich

RyzA

PCGH-Community-Veteran(in)

Früher als ich hier im Forum gefragt hatte, warum die das nicht machen, kam meistens die Antwort: das ist zu teuer!Na endlich, dies hätten sie schon längst machen können (Hust müssen Hust).

Im Desktop hatten sie das ja schon mal, vor acht Jahren, bei Broadwell (5775C und 5675C), ich hatten einen 5675C.

Die Broadwells waren ein Geheimtipp, warum Intel das erst jetzt wieder angeht ist mir ein rätsel.

Ich habe mir schon gedacht dass beim L4 Cache noch nicht das letzte Wort gesprochen wurde.

wurstkuchen

BIOS-Overclocker(in)

Nein. Nur Intel. Daran sieht man halt dass du das ganze nicht verstehst. Immer noch es geht um x86 und den Pc insbesondere Windows.Dann waren Qualcomm, ARM, Apple, Intel und nun auch AMD tatsächlich auf der falschen Fährte.

Flatline00

Freizeitschrauber(in)

Ich glaube das lag da wohl früher dran das die CPUs breiter wurden und dann weniger CPU / Wafer möglich waren.Früher als ich hier im Forum gefragt hatte, warum die das nicht machen, kam meistens die Antwort: das ist zu teuer!

Was dann den Preis stärker hoch treibt, als wenn man es "oben drauf packt" oder halt "unten drunter schiebt".

Ähnliche Themen

- Antworten

- 81

- Aufrufe

- 5K

- Antworten

- 63

- Aufrufe

- 4K

- Antworten

- 19

- Aufrufe

- 1K

- Antworten

- 61

- Aufrufe

- 5K

- Antworten

- 30

- Aufrufe

- 2K