Der Stecker ist für die Stromstärke zu knapp bemessen.

Der 12pin ist von der Kontaktfläche 1:1 ein 8Pin PCIe

8x 0,75mm² vs 12x 0,5mm²

Das Problem am ganzen ist, das der Strom sich nicht auf 12 Pins 1:1 verteilt.

Ein XT60 Stecker wäre besser

Oder gleich XT80

Wie kommst du denn bitte auf solche mm² Werte?

Mal ganz abgesehen davon dass ich zu bezweifeln wage, dass du besser beurteilen kannst

was so ein Stecker an Last verträgt als die, die diese Entwickelt haben.

Und nein, dass sind weder Nvidia noch die PCI-SIG.

Und was die ewigen Unkenrufe nach XT Steckern angeht, hast du überhaupt eine Ahnung ob diese

für entsprechende Einsatzgebiete innerhalb von Computern zugelassen oder praktikabel sind?

Selbst ohne solche XT Stecker gäbe es locker Dutzende Steckervarianten, die für solche Zwecke

eher geeignet sind... Insbesondere von Molex oder anderen Herstellern der IT Industrie selber.

Da könnte man genauso einen Molex Mega Fit mit 23A pro

Kontakt und bis zu AWG12 Kabeln nehmen...

Aber einen 60A 2 Pol Stecker? Ohne Sensepins? Das mag zwar in der Industrie angemessen sein,

aber sicher nicht in einem Consumer Produkt. Derart überzogene Leistungsdaten braucht kein

Mensch und verursacht nur sinnlose Kosten.

Davon mal abgesehen sind die Spezifikationen des Micro-Fit Standards an sich mehr als ausreichend

um theoretisch selbst 1000W weit unterhalb der Schmelztemperatur der Buchsen zu leisten...

Denn die Leistungswerte von 684W bei 9,5A, 12V sind für 30°C over Ambient Spezifiziert.

Bei 40°C OA sind wir dann schon weit jenseits von 750W.

Und selbst mit 8,5A (bei 12 Kontakten), wäre man immer noch über 600W.

Einzig die Tatsache, dass der Originalhersteller Molex

keine solch hoch spezifizierten Kontakte

für diesen Steckertyp anbietet, sondern nur Lizenznehmer, könnte hier stutzig machen...

Aber auch da arbeiten keine Amateure. Hierzu gehört u.A. Amphenol.

Nur mal so als kleine Erinnerung, da ja viele scheinbar ein dürftiges Langzeit Gedächtnis haben.

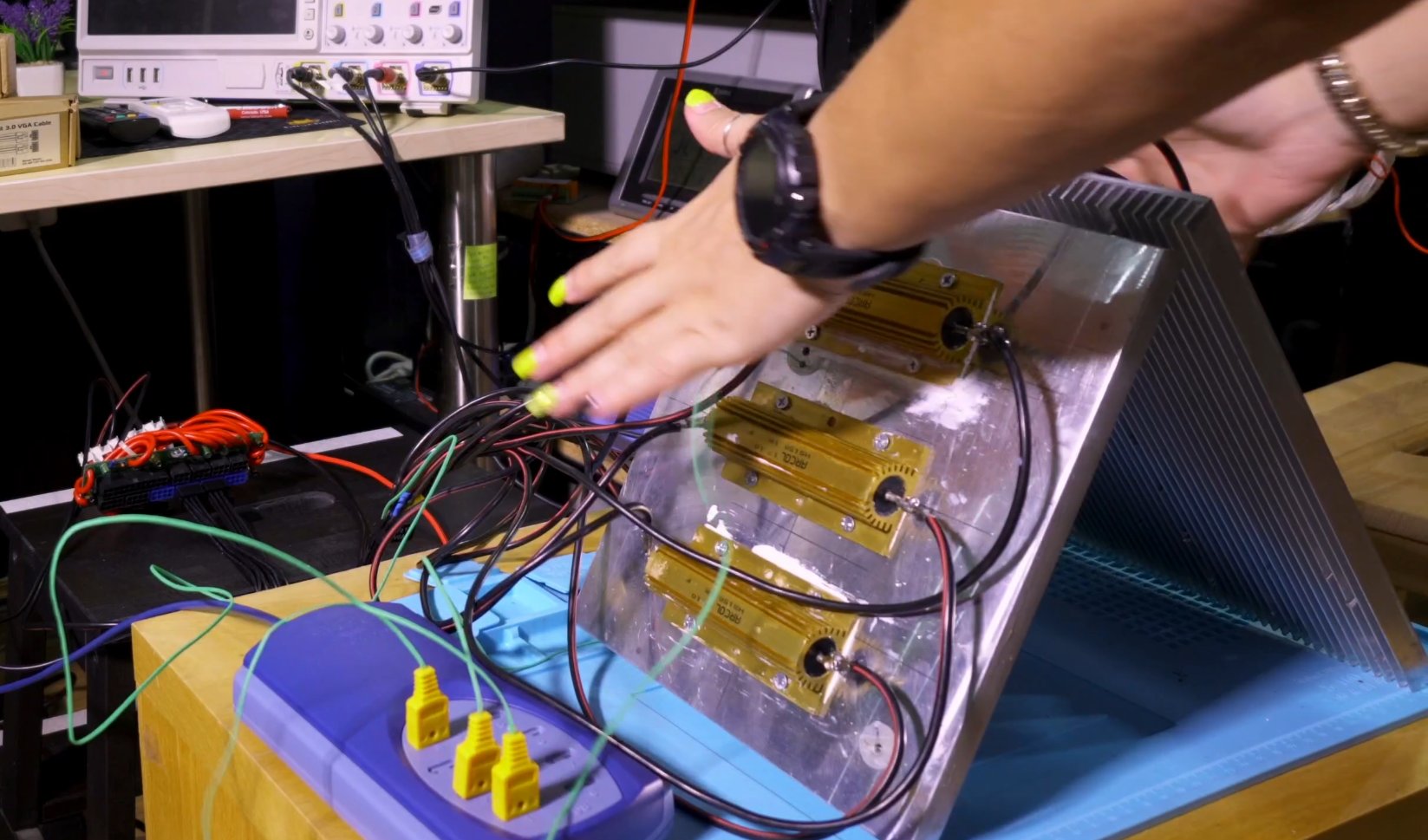

Da kann man mal gut sehen zu was für abartigen Leistungen so ein Kabel fähig ist...

Hier ein Artikel mit Video von Igor und HWBusters zu Nvidias 30er Serie Kabel.

In diesem Fall von Seasonic. (Rating: 12x 9A @ 12V = 648W)

The discussions about what current flow various 6-, 8- or now even 12-pin sockets can survive are as old as these sockets themselves. But while over the years one could see the odd experiment or two…

www.igorslab.de

Oder anders ausgedrückt, hier muss schon was ganz merkwürdiges abgehen, bis so ein Kabel bzw.

Stecker schmilzt!

Zudem sollte man vielleicht auch mal ein Augenmerk auf die Grafikkarten selbst, das Gehäuse inklusive

Belüftung und die Testsoftware werfen, mit der die Last erzeugt wurde.

Denn wenn mir bei allen Videos von GN, JayZ und Co. etwas aufgefallen ist, dann der Testaufbau.

Scheinbar keine "echten" Games zum Testen benutzt und immer nur offener Aufbau.

Das ist gerade aus Thermischer Sicht kaum vergleichbar mit einer realistischen Situation, in der

die GPU und Stromversorgung die wechselnden Lasten eines Spiels handhaben müssen, während das Ganze

u.U. in einem schlecht belüfteten Gehäuse untergebracht ist, bei dem die GPU permanent heiße

Luft auf den Stecker pustet...