Ich meine so etwas wie etwa aus diesem Mod-Paket:

https://www.nexusmods.com/starfield/mods/496

Da wurden zahlreiche Texturen für hohe Auflösungen deutlich optimiert und damit grafisch / optisch deutlich auch gegenüber dem Auslieferungsszustand verbessert, der m.M.n. eindeutig mit Blick auf die Leistungsfähigkeit der XBSX abgestimmt wurde - und mit u.a. dieser Mod zieht die Grafik etwa in meinem System in anspruchsvollen Bereichen wie Atlantis City dann fast 16 GB VRAM.

Na Klasse.

Und weil du darauf bestehst, dir ein blödsinniges ultra 8k Texture Pack zu installieren, ist also NVidia jetzt doof, weil die "zu wenig VRam" verbauen.

Nimm das 16k Texture Pack, dann reicht auch deine Karte nicht.

Alles unter 16k Texturen sieht ja auch total Kacke aus, nicht wahr?

Dein Anwendungsszenario ist vermutlich für 99.999% aller Benutzer vollkommen irrelevant!

Das ist nun eine Frage, was man unter "effizienter"versteht - mir fehlt da der direkte Vergleich, aber es kann sich dabei ja nur um die Befüllung, ggf. Auslagerung und wieder Freigabe handeln - denn wenn grafische Inhalte eine Menge X an VRAM anfordern/belegen, kann NV auch nicht viel mehr machen als solange VRAM zur Verfügung stellen, bis er ausgeht und dann wird im besten Fall ausgelagert...

FYI: NVidia hat die besseren Textur Kompressionsverfahren und benötigt deswegen weniger VRam, als andere Hersteller.

Auch hier nochmal: Mir geht es in meinen Ausführungen nicht primär um den absoluten Preis, sondern das Verhältnis aus Preis u. Leistung insbesondere auch innerhalb einer Generation. Mir z.B. taugt das schon lange nicht mehr. Einen Teil hat das Mining samt Pandemie zu den stark gestiegen Preisen beigetragen, der Rest ist einfach hartes Up-Selling, wo man halt mittlerweile zunehmend nicht wie bei früheren Generation mehr "Bang for the (same or less) Bucks" bekommen hatte, sondern sich die Hersteller den technsichen Fortschritt a) vergolden lassen und b) Effizienzgewinne bei der Herstellung auch ausschließlich zu ihrem eigene Profit verwendet werden.

Investiere deine eigene Kohle, dann bekommst du auch ein Mitspracherecht, was mit dem Profit zu geschehen hat!

Früher (also bis ca. in die frühen 2000er) hat sich nämlich die Computerbranche noch etwa gegenüber Autoherstellern damit gerühmt, wie stark die Kunden vom Entwicklungsfortschritt profitieren würden, auch finanziell - gab da diese schöne Aussage von Bill Gates in seinem Buch “Der Weg nach vorn”: “Wenn die Autoindustrie solche Fortschritte gemacht hätte wie die Computerindustrie, würden wir heute für 40 Mark ein Auto bekommen, das 0,3 l/100 km verbraucht.”

Heute will man sich auch hier analog der Automobilbranche jedes Feature am liebsten extra bezahlen lassen. Das Modell funktioniert halt, weil wir es etwa bei GPUs mittlerweile quasi mit einem Duopol zu tun haben, in dem die beiden Protagonisten sich offenbar die Claims sauber abgesteckt haben, so dass für jeden die optimale Marge herausspringt. Ich werte das auch erst Mal gar nicht (sondern berücksichtige das direkt in meinem Kaufverhalten) und wenn, dann müssten da Kartellbehörden drauf schauen. Sondern ich sehe halt eine Entwicklung, bei der künftig nur noch die "Reste" (auch hinsichtlich Produktionskapazitäten) für die Spielerschaft zu Spitzenpreisen angeboten werden und die Spitzenprodukte direkt ins B2B-Geschäft wandern, und dort noch mehr Marge generieren. Das ist betriebswirtschaftlich auch folgerichtig. Fragt sich nur, wielange damit ein PC Gamingmarkt eine Perspektive behält, die auch Spielehersteller animiert immer neue Grenzen auszuloten. Klar wird es weiterhin reichlich Leute geben, für die die aufgerufenen Preise eh Peanuts sind bzw. die es als unabdingbaren Invest ins Haupt-Hobby sehen, der nunmal anfällt, will man das aktuell Beste haben. Aber das ist so wie die Leserschaft hier im Forum eine verschwindende Minderheit. Man sehe einfach nur mal in die Steam-Surveys der jüngeren Zeit, was dort nach wie vor dominiert - und das dürfte angesichts der Nutzerzahlen von Steam durchaus representativ sein. Letztlich bleibt alles eine akademische Debatte, weil es keine nennenswwerten Einfl.ussmöglichkeiten auf die Produkt- wie Preis-Politik der Konzerne gibt. Einzig bei unzulässigen Preisabsprachen o.ä. könnten vllt. noch Kartellbehörden etwas ausrichten, aber auch nur dann, wenn ein entsprechender Nachweis geführt werden kann.

Solange die neuen GPUs weiterhin gekauft werden, darf man davon ausgehen, dass die Kunden die Preise mehr oder weniger angemessen finden.

Natürlich gibt es immer welche, die das anders sehen.

Es rennt bestimmt auch irgendwo jemand rum, der meint, ein Bugatti dürfte nur so viel kosten wie 10 Kaugummis.

Und es besteht immer noch die Möglichkeit, als Käufer auf den Markt einzuwirken, indem man bestimmte Produkte einfach nicht kauft.

Aber auch damit wird man sich nicht gegen die Mehrheit der anderen stemmen können.

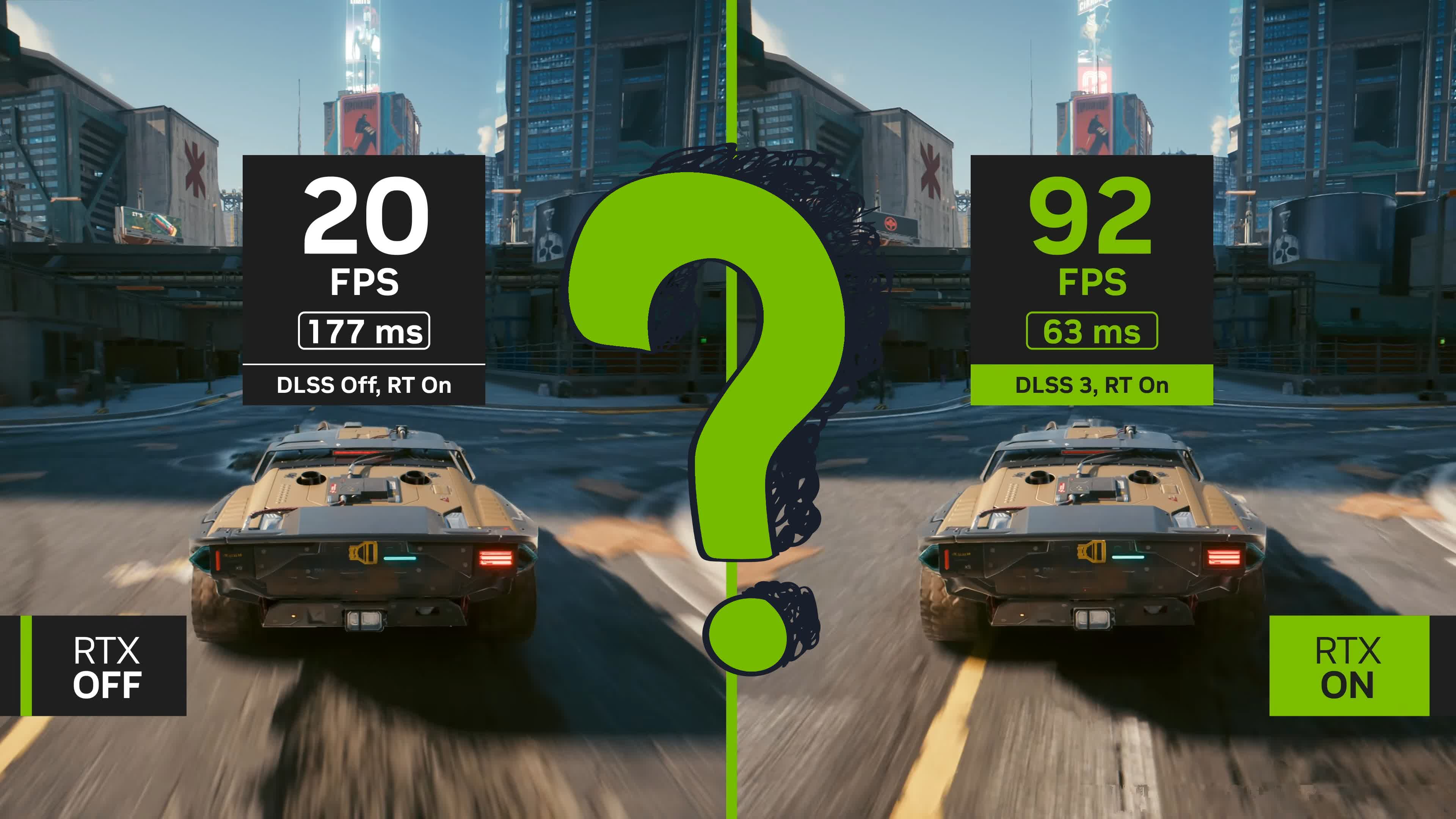

Doch, ich halte das sogar angesichts der eben v.a. damit auch begründeten Preise für extrem relevant. Sonst landen wir absehbar bei einem Stillstand der Hardware-Entwicklung, die mit Softwaretricks aufgehübscht, noch teurer angepriesen wird und letztlich einen allgemeinen Entwicklungsstillstand bedeutet, der jegliche Optimierung obsolet werden lässt. Technischer Fortschritt in der IT war bislang immer durch v.a. Verbesserung der Rechenleistung und Optimierung von Algorithmen / Software-Prozessen bestimmt. Mit dem neuen "Wunder- bzw. Allheilmittel" KI soll dies nun angesichts (angeblich) immer teurer werdender Entwicklungs- und Fertigungsprozesse gerichtet werden und letztlich wird etwas vorgetäuscht, was nicht da ist: nämlich Rechenleistung.

Ich kaufe mit einer GPU zum Spielen keine Rechenleistung.

Ich will nur möglichst viele Bilder pro Sekunde.

Ob die das mit Rechenleistung machen, mit KI Upscaling, oder mit Voodoo und schamanistischen Ritualen, ist mir dabei völlig Latte.

Und möglicherweise liegt allein in der Entwiclung von Verfahren, die sowas leisten, auch ein Wert, nicht nur in der Herstellung von immer mehr Rechenleistung auf immer kleinerem Raum.

KI Upscaling und Raytracing sind gerade DER technologische Fortschrittsmoment überhaupt.

In diesem Zusammenhang von Stillstand und Stagnation zu labern ist einfach nur ignorant und vermutlich ausschliesslich durch Böswilligkeit und Neid zu erklären.

Konkret: Statt nativ z.B. Fotorealismus in 4k anzustreben, wird irgendwas bestenfalls in 1k gerastert und dann "intelligent", aber künstlich skaliert. Das ist an sich noch kein Problem, solange der optische Eindruck passt. Nur, dass für diese eigentlich 1k-Grafikkarten Preise aufgerufen werden, als ob es echte 4k-befähigte Grafikkarten wären. Das erinnert mich zunehmend an frühere Tricks a la RAM-Doppler in Software o.ä.. Das ist dann zunehmend die Simulation von technischem Fortschritt zu exorbitanten Preisen.

Wie bereits erwähnt, handelt es sich bei der Entwicklung von Verfahren, die so etwas anders als mit roher Rechengewalt zu bewerkstelligen imstande sind, um einen eigenständigen Wert.

Offenbar wollten die zig tausend Entwickler für ihre Arbeit daran ebenso bezahlt werden, wie die Leutchen, die in der Fab die Chips ätzen.

Du tust ja gerade so, als gäbe es so etwas wie "echte" 4k Karten.

Zeig mir doch mal eine.

Bis dahin weiss ich, was ich von solchen Äusserungen zu halten habe.