Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Geforce RTX 5090 (Ti): Gerüchte nennen 24.576 Shadereinheiten und 32 GiByte GDDR7-Grafikspeicher mit 512-Bit

- Ersteller PCGH-Redaktion

- Erstellt am

Hagelzuckererbse

Freizeitschrauber(in)

Und wenn sie 2500€ kostet wird sie trotzdem gekauft werden, ist doch immer das selbe Spiel...

Bobhais

Software-Overclocker(in)

Was genau wäre das denn? Der Hopper H100 ist eine Tensor-Core GPU und hat gerade mal bis zu 67TF FP32 Leistung und ist als PCie Karte nur bis 350 Watt konfigurierbar und langsamer für Gaming.Es gibt sehr wohl viel besseres - nur hat NV sich dazu entschlossen es nicht im Privatbereich anzubieten weil man auch mit nem deutlich teildeaktivierten xx2er Chip konkurrenzlos ist.

Zudem ist ein ~600mm² Chip für den neuen Prozess ambitioniert genug.

Technisch gesehen war auch der Prozess um >90% günstiger pro mm² und wesentlich weniger komplex.Technisch gesehen wäre eine solche Karte vor 10 Jahren eine xx70er geworden (die GTX570 war ein teildeaktivierter Highendchip - wie die 4090 heute... für 350€).

Zudem gab es über der GTX 580 kein Produkt mehr - außer der der Dual GPU Karte.

Du vergleichst doch zudem nicht ernsthaft Preise von vor 13 Jahren mit heute.

.gif)

Der ist nicht deutlich deaktiviert, es sind gerade mal um die 10%, die real vielleicht in 5 bis 6% Mehrleistung resultieren.- nur hat NV sich dazu entschlossen es nicht im Privatbereich anzubieten weil man auch mit nem deutlich teildeaktivierten xx2er Chip konkurrenzlos ist.

owned139

BIOS-Overclocker(in)

red nicht son Müll. Das hat hier niemand behauptet.Aber hey, NVIDIA macht alles richtig. 0815 Gamer denken sie spielen auf deren nativen Auflösung mit DLSS aktiv und sagen dann immer "WaRuM lÄuFt dAs SpIeL sO gUt".

Wen juckt die interne Auflösung, wenn die Bildqualität vergleichbar ist?

Dann kauf dir doch ne 90 TI, verbrate 600 W mit deinem Rechner und pell dir einen drauf, dass es nativ ist.

Andere nutzen DLSS, verbrauchen die Hälfte und gehen dafür im Sommer nicht ein.

Viel Spaß beim Pixel zählen

Dazu bitte mal eine Quelle. Das wird ständig behauptet und niemand kanns belegen (in dem Ausmaß).Technisch gesehen war auch der Prozess um >90% günstiger pro mm²

Die Herstellung einer 580er GPU (vollaktiv!) kostete damals wie wir heute wissen grib 100 Dollar. Die Karte kostete im Verkauf 350. Jetzt lass mal alles heute super viel teurer sein und die GPU kostet 400 oder gar 500 Dollar (300 ist realistischer da teildeaktiviert) und die Karte steht für 1500-2000 im Laden.

Was das mit der Marge von NV macht kannste ja nachlesen wenn du Börsenberichte von damals mit heute vergleichst.

Also teurer ja keine Frage aber niemals auch nur ansatzweise so viel teurer wie der Endkundenpreis suggerieren will.

DaStash

PCGH-Community-Veteran(in)

Also Nvidia freut solch eine Einstellung, 130% Preis verlangen können bei nur noch 50% roh Performance input.red nicht son Müll. Das hat hier niemand behauptet.

Wen juckt die interne Auflösung, wenn die Bildqualität vergleichbar ist?

Dann kauf dir doch ne 90 TI, verbrate 600 W mit deinem Rechner und pell dir einen drauf, dass es nativ ist.

Andere nutzen DLSS, verbrauchen die Hälfte und gehen dafür im Sommer nicht ein.

Viel Spaß beim Pixel zählen

MfG

Bobhais

Software-Overclocker(in)

Gibt doch x Quellen.Dazu bitte mal eine Quelle. Das wird ständig behauptet und niemand kanns belegen (in dem Ausmaß)

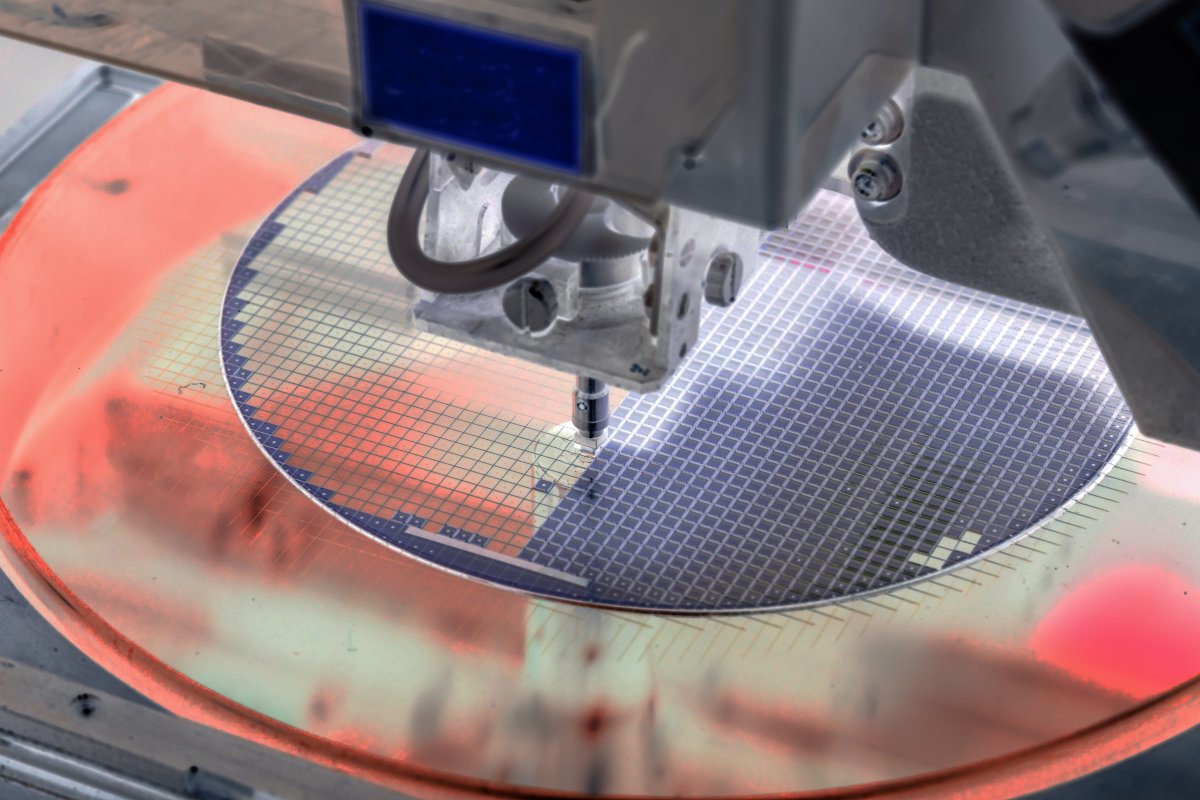

CPUs und GPUs betroffen: Chipkosten sollen weiter steigen

Schlechte Vorzeichen für Ryzen 7000, Radeon RX 7000 und GeForce RTX 4000: Die Kosten für die Chipfertigung steigen offenbar weiter an.

Siehe Grafik.

Und wie wir wissen kostet eine RTX 4090 heute rund 600 Dollar.Die Herstellung einer 580er GPU (vollaktiv!) kostete damals wie wir heute wissen grib 100 Dollar. Die Karte kostete im Verkauf 350.

Wie gut, dass es so nicht ist.Also Nvidia freut solch eine Einstellung, 130% Preis verlangen können bei nur noch 50% roh Performance input.

Und wie toll, dass User einer alten Turing GPU heute so extrem davon profitieren können, ohne mehr bezahlt zu haben.

Zuletzt bearbeitet:

Zeig mir eine, die deine "über 90% billiger" belegen.Gibt doch x Quellen.

Also eine die aussagt, dass die Produktion eines AD102 Chips mehr als das 10-fache kostet wie die eines GF100 Chips.

Spoiler: gibt es nicht weils nicht so ist.

owned139

BIOS-Overclocker(in)

Das komplexere PCB bzw. die komplexere Stromversorgung und die wesentlich teureren VRAM Chips ignorieren wir einfach mal?Jetzt lass mal alles heute super viel teurer sein und die GPU kostet 400 oder gar 500 Dollar (300 ist realistischer da teildeaktiviert) und die Karte steht für 1500-2000 im Laden.

Was das mit der Marge von NV macht kannste ja nachlesen wenn du Börsenberichte von damals mit heute vergleichst.

Kannste machen ja. Das sind keine 50 Dollar Unterschied in den Mengen die NV kauft.

Es spielt auch keine Rolle ob so ne Karte jetzt 300 oder 500 oder 700 in der Herstellung kostet, das werden wir sowieso nie wissen. Es geht darum, dass die Gewinnspanne viel viel größer ist als sie es vor 10 Jahren war aber es immer noch Leute gibt die ernsthaft glauben NV würde nur höhere Produktionskosten weiterreichen. Wenn eine 4090 für 1000 Dollar verkauft würde würde NV noch immer gut dran verdienen. Nur gibts keinen Grund so wenig zu verlangen weil keine Konkurrenz da ist und man die Kunden ganz offenbar sehr erfolgreich darauf getrimmt hat solche Preise als normal zu akzeptieren weil ja alles so viel teurer geworden ist.

Es spielt auch keine Rolle ob so ne Karte jetzt 300 oder 500 oder 700 in der Herstellung kostet, das werden wir sowieso nie wissen. Es geht darum, dass die Gewinnspanne viel viel größer ist als sie es vor 10 Jahren war aber es immer noch Leute gibt die ernsthaft glauben NV würde nur höhere Produktionskosten weiterreichen. Wenn eine 4090 für 1000 Dollar verkauft würde würde NV noch immer gut dran verdienen. Nur gibts keinen Grund so wenig zu verlangen weil keine Konkurrenz da ist und man die Kunden ganz offenbar sehr erfolgreich darauf getrimmt hat solche Preise als normal zu akzeptieren weil ja alles so viel teurer geworden ist.

Zuletzt bearbeitet:

Bobhais

Software-Overclocker(in)

Zeig mir eine, die deine "über 90% billiger" belegen.

News | 3DCenter.org

10 bis 20% pro Node vor 14/16nm.

Zwischen 14/16 und 7nm +69%, gesamt also Faktor 4.

Dazu kommen die gestiegenen Kosten aus der vorherigen Quelle.

Ein 5nm Design kostet schon 500 000 000.

Also ja die Kosten für die Chipfertigung sind wohl insgesamt um knapp den Faktor 10 gestiegen.

Das habe ich ja nicht behauptet, aber die Kosten für das Design und den gesamten Fertigungsprozess müssen ja irgendwie umgelegt werden.Also eine die aussagt, dass die Produktion eines AD102 Chips mehr als das 10-fache kostet wie die eines GF100 Chips.

Für die RTX 4080 werden etwa 300 Dollar angesetzt.

NVIDIA RTX 4080 Allegedly Costs Just $300 to Manufacture on TSMC's 5nm Process Node

NVIDIA’s GeForce RTX 4080 launched last week to a lukewarm reception. The high-end Lovelace GPU offers solid ray-tracing and content creation performance but costs 70% more than its predecessor. This makes you wonder how much money NVIDIA makes off this SKU. A user on Weibo has taken a stab at...

www.hardwaretimes.com

www.hardwaretimes.com

Für die 4090 müssten es somit schon Richtung 600 Dollar sein.

Alleine die Chipkosten werden mit ~250 Dollar veranschlagt.

90 mögliche Chips aus einem 18K Wafer, mit einigen Defekten.

Ich denke schon.Spoiler: gibt es nicht weils nicht so ist.

Für die RTX 4080 werden etwa 300 Dollar angesetzt.

Für die 4090 müssten es somit schon Richtung 600 Dollar sein.

Na mehr sag ich doch gar nicht.

Ne 4080 kostet keine Ahnung 1200 und ne 4090 1500 aufwärts.

Das sind Gewinnspannen von 300-400%.

Bei ner GTX580 die 150-200 Herstellung und 350 Verkaufspreis hatte sinds "nur" rund 100%.

Diese Margensteigerung ist ja was ich meinte. Man hat halt über die Jahre die Leute an Preise gewöhnt und AMD konnte nicht wirklich mitgehen. Ist auch alles kein Ding, si funktioniert Marktwirtschaft nunmal - es ist nur halt blöd wenn Leute das nicht sehen können und ernsthaft glauben die Herstellung einer 4090 würde NV irgendwie 1400€ kosten oder sowas weil ja die Wafer so teuer sind...

Bobhais

Software-Overclocker(in)

Genau das ist der Knackpunkt. Wenn die GPU statt 300 Dollar 700 Dollar in der Herstellung kostet, sind für letztere keine < 1000 Dollar ohne entsprechende Nettomargen mehr drinnen.Es spielt auch keine Rolle ob so ne Karte jetzt 300 oder 500 oder 700 in der Herstellung kostet...

Wenn die GTX 570 100 Dollar gekostet hat, würde die 4080 schon mal das dreifache, die 4090 wohl das 6 fache kosten.

Die ist schon etwas höher, aber auch gerade so hoch, dass sich AMDs GPU Sparte als Konkurrenz überhaupt lohnt. Haben doch jahrelang rote Zahlen geschrieben.Es geht darum, dass die Gewinnspanne viel viel größer ist als sie es vor 10 Jahren war...

Preise senken ist da nicht drin.

Macht für mich den Großteil aus, ja.aber es immer noch Leute gibt die ernsthaft glauben NV würde nur höhere Produktionskosten weiterreichen.

Die Nettomargen stiegen von 15 auf etwa 30%, das ist schon gut, kommt aber hauptsächlich durch Nvidias Technologievorsprung.

Glaube ich überhaupt nicht, wenn das Ding schon von den reinen Produktionskosten bei ~ 600 liegt. Unter 1200 bis 1300 Dollar wird da nichts gehen. Die 4080 wäre eher ein Produkt für 700 bis 800 Dollar, würde dann aber auch AMD vor Probleme stellen.Wenn eine 4090 für 1000 Dollar verkauft würde würde NV noch immer gut dran verdienen.

So viel Marge ist da nicht drauf. Wenn du die 4090 für 1000 Dollar verschleudern würdest, hättest du mit Marketing, Entwicklung, Ausfallrate und sonstigen Kosten überhaupt keine Chance damit eine Nettomarge von über 10% zu generieren, eher 0.Nur gibts keinen Grund so wenig zu verlangen weil keine Konkurrenz da ist und man die Kunden ganz offenbar sehr erfolgreich darauf getrimmt hat solche Preise als normal zu akzeptieren weil ja alles so viel teurer geworden ist.

Das macht doch dann auch keinerlei Sinn. AMD hat das bei Vega und der Radeon VII gemacht und ist damit auf die Nase geflogen.

Du glaubst doch nicht ernsthaft Nvidia könnte den Preis der 4090 einfach mal so um 40% senken und dann noch Kohle scheffeln, total weltfremd, aber von anderen dann Quellen verlangen.

Dachte die kostete nur 100 Dollar?Bei ner GTX580 die 150-200 Herstellung und 350 Verkaufspreis hatte sinds "nur" rund 100%.

Zuletzt bearbeitet:

Man muss nur fest genug dran glauben.

Wenn Amd ne Karte hätte die 20% schneller als ne 4090 wäre für 1000€ würde man sehen dass ne 4090 schnell unter 1000 fallen würde - und wundersam NV damit kein besonderes Problem hätte.

Solche Szenarien gabs bei GPUs und CPUs schon vielfach in der Vergangenheit und jedes mal gabs die Leute die sagten da ist ja keine Marge drauf... und jedes Mal war der halbe Preis für das gleiche Produkt auch noch gangbar. Natürlich nicht dauerhaft (wie bei Amds FX cpus gesehen oder der von dir genannten Vega) aber es ist illusorisch zu glauben dass NV mit ner 4080 für 700 und ner 4090 für 1000€ nicht lebensfähig wäre.

Wenn Amd ne Karte hätte die 20% schneller als ne 4090 wäre für 1000€ würde man sehen dass ne 4090 schnell unter 1000 fallen würde - und wundersam NV damit kein besonderes Problem hätte.

Solche Szenarien gabs bei GPUs und CPUs schon vielfach in der Vergangenheit und jedes mal gabs die Leute die sagten da ist ja keine Marge drauf... und jedes Mal war der halbe Preis für das gleiche Produkt auch noch gangbar. Natürlich nicht dauerhaft (wie bei Amds FX cpus gesehen oder der von dir genannten Vega) aber es ist illusorisch zu glauben dass NV mit ner 4080 für 700 und ner 4090 für 1000€ nicht lebensfähig wäre.

Bobhais

Software-Overclocker(in)

Die 4080 ist ja ein Produkt für eigentlich um die 700 Dollar - ohne Steuer, das wäre sicherlich möglich, aber ein fast doppelt so großes Die mit 24GB für nur 1000 Dollar, wenn Nvidia für die RTX 2080Ti in 12nm schon 1000 Dollar genommen hat, im viel günstigeren Prozess mit halbem Speicher und billigem Kühler. Halte ich für Wunschdenken. Da ist nichts dran verdient. Mit 60% mehr VK gibt es dann ein gutes Polster.aber es ist illusorisch zu glauben dass NV mit ner 4080 für 700 und ner 4090 für 1000€ nicht lebensfähig wäre.

DaStash

PCGH-Community-Veteran(in)

Wenn man sich die Preisentwicklung anschaut sieht man doch sehr gut, wie von GEN zu GEN immer mehr umgelabelt wurde. Mid zu Low, High zu MID und nach oben open end gemacht wurde, eben damit die Karten darunter "güntiger" wirken. Wir reden hier von HighEnd, man muss nur schauen, was das früher gekostet hat, da gibt es nichts schön zu reden, an Karten die 1000 €+ kosten und nicht mal HighEnd sind, von den Enthusiastenkarten mit ihren 17090/2000 €+ ganz zu schweigen. Man muss schon ziemlich viele gerade sein lassen um das nicht zu sehen. Die Preisentwicklung verlangt förmlich nach boykott, denn nichts anders motiviert Hersteller zu Anpassungen.Die 4080 ist ja ein Produkt für eigentlich um die 700 Dollar - ohne Steuer, das wäre sicherlich möglich, aber ein fast doppelt so großes Die mit 24GB für nur 1000 Dollar, wenn Nvidia für die RTX 2080Ti in 12nm schon 1000 Dollar genommen hat, im viel günstigeren Prozess mit halbem Speicher und billigem Kühler. Halte ich für Wunschdenken. Da ist nichts dran verdient. Mit 60% mehr VK gibt es dann ein gutes Polster.

Incredible Alk hat schon Recht damit, wenn AMD gleichauf/ schneller wäre in dem Segment, würden die Mondpreise sehr schnell fallen und, welch Überraschung, es bleibt immer noch genug marge offen, nur wären dann eben die fetten Jahre vorbei. Kann ja jeder handhaben wie er will aber eine einzelne GPU zum Preis von zwei Gaminglaptops oder 5 aktuell GEN Konsolen ist einfach nicht mehr feierlich, vor allem wenn man sich vor Augen hält, dass die Rohleistung nicht mal ausreicht um aktuelle Features zu nutzen und auf Upscaling gesetzt werden muss, um das überhaupt spielbar zu machen. Für Nvidia natürlich super, maximaler finanzieller Output trifft auf minimalen Ressourceneinsatz.

MfG

LastManStanding

PCGH-Community-Veteran(in)

Bist du Vorpubertär? Aufgestampft..."Ich habe Recht", hast Du dabei mit dem Fuß auf den Boden gestampft?

Leider nein, leider gar nicht. Also dass Du Recht hast.

Sorry hab dich im Moment des Ausschaltens vor ein paar Tagen vollkommen vergessen, Ich musste sogar meinen eigenen Beitrag nochmal lesen um zu wissen was du jetzt überhaupt willst.

Ich bin Keinem Sozialen Netzwerk und außer ein paar Händlern ingesamt in 4 Foren angemeldet. Warum sollte mir Deine fiktive-Internet-Meinung so wichtig sein, wenn mir der rest vom Internet für mein Reales Leben schon nicht Wichtig ist?

Die 4090 schafft keine Spielbaren FPS in 4K Maximum Settings und RT/PT in CP2077, Nativ kommen da keine 30 Bilder bei raus. Mehr sagte ich von Anfang an nicht. Was du daraus machst ist mir ein Rätsel

https://www.computerbase.de/2023-04/cyberpunk-2077-raytracing-overdrive-modus/

Lies was ich geschrieben habe und nicht was Du denkst was es bedeuten soll!

Es gibt keinen Tieferen Sinn, kein Subtext nichts. Nur das was da steht, Ohne "man könnte auch Downsampling nutzen"

Ist doch schön das es das gibt. ne sehr interessante Technik für diejenigen die es nutzen wollen.

Ich habe grundsätzlich von Rohleistung gesprochen, und in diesem Kontext auch Recht. Mehr nicht.

Und du machst ein rieeeeesen Film davon. Rein Spekulativ bist du, augenscheinlich ein richtig überzeugter selbst Darsteller!

JoDie Effizienz der 4090 ist super.

Ja? Meinste? 3 Ausreden; Bin mid. 30(Alt), und Ausländer. außerdem ist Nativ ein doofes Wort.Echten- das entlarvt jeden als Dinosaurier.

ja eigentlich hätte ich wohl "echten " schreiben müssen um es zu betonen.

Das sollte eine Anspielung auf rapid s "echt vs unecht" kram sein

Ja kannst du machen, super das es das gibt. Mir solls nur recht sein.Dann nehme ich lieber die unechten FPS, als diese altbacken Grafik, die offensichtlich fast in jeder Szene brutal falsch ausgeleuchtet wird.

Ich habe weder die passende GPU noch irgendein Spiel was das nur annähernd nötig oder möglich macht^^

Aber der raPid-81 der scheint ja unheimlich Wert auf eine Schubladisierung zu legen. Der fing von echt oder unecht als Bemessungsgrundlage an, ich nich. Mit ihm kannst du das gerne ausdiskutieren.

Zuletzt bearbeitet:

DaStash

PCGH-Community-Veteran(in)

Wenn man von sich auf andere schließt.Bist du Vorpubertär? Aufgestampft...

Sorry hab dich im Moment des Ausschaltens vor ein paar Tagen vollkommen vergessen, Ich musste sogar meinen eigenen Beitrag nochmal lesen um zu wissen was du jetzt überhaupt willst.

Ich bin Keinem Sozialen Netzwerk und außer ein paar Händlern ingesamt in 4 Foren angemeldet. Warum sollte mir Deine fiktive-Internet-Meinung so wichtig sein, wenn mir der rest vom Internet für mein Reales Leben schon nicht Wichtig ist?

Genau das, was ich auch shcon oft festgestellt habe. Ohne DLSS als Gehhilfe, wäre das eine miserable Performance, im Verhältnis zum Preis.Die 4090 schafft keine Spielbaren FPS in 4K Maximum Settings und RT/PT in CP2077, Nativ kommen da keine 30 Bilder bei raus. Mehr sagte ich von Anfang an nicht. Was du daraus machst ist mir ein Rätsel

https://www.computerbase.de/2023-04/cyberpunk-2077-raytracing-overdrive-modus/

Das ist auch das was allgemein in der Debatte darum etwas untergeht. DLSS ist ja gut und schön aber es täuscht meiner Meinung nach deutlich darüber hinweg, dass das Verhältnis zwischen Preis und Leistung, wie eine Schere, auseinanderdriftet oder aber es zeigt gut auf, dass die beworbenen Features eben bei weitem nicht so gut laufen, wie es in solch einem Segment eigentlich sein sollte, ohne Hilfen.Lies was ich geschrieben habe und nicht was Du denkst was es bedeuten soll!

Es gibt keinen Tieferen Sinn, kein Subtext nichts. Nur das was da steht, Ohne "man könnte auch Downsampling nutzen"

Ist doch schön das es das gibt. ne sehr interessante Technik für diejenigen die es nutzen wollen.

Ich habe grundsätzlich von Rohleistung gesprochen, und in diesem Kontext auch Recht. Mehr nicht.

Und du machst ein rieeeeesen Film davon. Rein Spekulativ bist du, augenscheinlich ein richtig überzeugter selbst Darsteller!

Man muss nicht über jedes Stöckchen springen, was einem irgendwer hinhält.Jo

Ja? Meinste? 3 Ausreden; Bin mid. 30(Alt), und Ausländer. außerdem ist Nativ ein doofes Wort.

ja eigentlich hätte ich wohl "echten " schreiben müssen um es zu betonen.

Das sollte eine Anspielung auf rapid s "echt vs unecht" kram sein

Jep, genau so ist es.Ja kannst du machen, super das es das gibt. Mir solls nur recht sein.

Ich habe weder die passende GPU noch irgendein Spiel was das nur annähernd nötig oder möglich macht^^

Aber der raPid-81 der scheint ja unheimlich Wert auf eine Schubladisierung zu legen. Der fing von echt oder unecht als Bemessungsgrundlage an, ich nich. Mit ihm kannst du das gerne ausdiskutieren.

Und zur GPU, ja, ich orientiere mich auch mehr auf die Rohleistung. RT/PT wird für mich dann erst interessant, wenn es a) sich deutlich sichtbar ohne Lupe und Slider von der regulären Berechnung abhebt und dann auch nativ gerendert wird, ohne Hilfen wie DLSS. Ich verweise an der Stelle noch einmal darauf, dass man hier den Hersteller dazu verhilft, die Margen künstlich zu erhöhen, ohne die Rohleistung im gleichen Maße anzuheben.

MfG

derneuemann

Volt-Modder(in)

Die 4090 schafft keine Spielbaren FPS in 4K Maximum Settings und RT/PT in CP2077, Nativ kommen da keine 30 Bilder bei raus. Mehr sagte ich von Anfang an nicht. Was du daraus machst ist mir ein Rätsel

https://www.computerbase.de/2023-04/cyberpunk-2077-raytracing-overdrive-modus/

Doch schafft die, mit DLSS und FG usw..

Die 77 Fps aus deinem Link in 4k sind absolut ausreichend. Selbst mit einer 4070ti in verschiedenen Auflösungen und Settings herum probiert. Mit FG und ab 70Fps, war für mich super spielbar.

Ich habe grundsätzlich von Rohleistung gesprochen, und in diesem Kontext auch Recht. Mehr nicht.

Aber auch mehr und mehr sinnfrei, nur auf Rohleistung zu schauen.

Man kann auch mit 30 schon Dinosaurier Ansichten haben.Ja? Meinste? 3 Ausreden; Bin mid. 30(Alt),

Die meisten Dinosaurier waren Ausländer, aber was hat das damit zu tun.und Ausländer.

Warum, allgemein weiß jeder was gemeint ist.außerdem ist Nativ ein doofes Wort.

WEiß nicht wer angefangen hat, mir auch Latte.ja eigentlich hätte ich wohl "echten " schreiben müssen um es zu betonen.

Das sollte eine Anspielung auf rapid s "echt vs unecht" kram sein

Warum ist dir dann die Rohleistung der 4090 wichtig, bzw. die Rohleistung der aktuellen GPUs?Ja kannst du machen, super das es das gibt. Mir solls nur recht sein.

Ich habe weder die passende GPU noch irgendein Spiel was das nur annähernd nötig oder möglich macht^^

Absolut überflüssiger Beisatz, was willst du damit bezwecken.Aber der raPid-81 der scheint ja unheimlich Wert auf eine Schubladisierung zu legen. Der fing von echt oder unecht als Bemessungsgrundlage an, ich nich. Mit ihm kannst du das gerne ausdiskutieren.

DaStash

PCGH-Community-Veteran(in)

@derneuemann

Rohleistung ist dann z.B relevant, wenn durch Bildverbesserer wie Frame Generation Latenzen/Inputlag entstehen. Und um technisch herauszufinden was schneller ist und was nicht ist es nun einmal relevant auf die Rohleistung zu schauen, sonst bräuchte man ja auch keine 720p CPU Benchmarks, wenn doch real eh nur in wqhd oder 4K gespielt wird.

MfG

Rohleistung ist dann z.B relevant, wenn durch Bildverbesserer wie Frame Generation Latenzen/Inputlag entstehen. Und um technisch herauszufinden was schneller ist und was nicht ist es nun einmal relevant auf die Rohleistung zu schauen, sonst bräuchte man ja auch keine 720p CPU Benchmarks, wenn doch real eh nur in wqhd oder 4K gespielt wird.

MfG

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 69

- Aufrufe

- 3K

- Antworten

- 83

- Aufrufe

- 4K

- Antworten

- 24

- Aufrufe

- 1K

- Antworten

- 104

- Aufrufe

- 6K