Anstrengend? Ist halt ein Technik forum hier, oder?So schwer ist das doch nicht. Ich bin raus. Das wird mir echt zu anstrengend.

Da spricht man auch mal tiefgreifender über solche Themen.

Anstrengend? Ist halt ein Technik forum hier, oder?So schwer ist das doch nicht. Ich bin raus. Das wird mir echt zu anstrengend.

Exakt, bis auf die Ausnahmen, die ich genannt hatte.Das klingt mir zu wohlfeil, nach der Logik hätten alle Entwicklerstudios stand heute nur Mist abgeliefert und können mit der Technik nicht umgehen.

DLSS braucht Pixelmenge in der Ausgabeauflösung um effektiv arbeiten zu können. Und ja- Die aktuellen implementierungen sind oft nicht überzeugend. Was ich aber auch nie bestritten habe und was auch nicht meine Kernaussage des ganzen widerspiegelt.Fakt ist, wie @huenni87 schon sagt, die aktuellen implementierungen sind oft nicht überzeugend. Vor allem wenn die Basisauflösung QHD und niedriger ist.

Fakt ist, dass Du behauptet hast, dass es Fakt wäre, dass DLSS nicht auf Reflexionen wirken kann. Ich habe Dir an einem Praxisbeispiel das Gegenteil bewiesen (mit Vergleichsscreenshot und den Originalen im Anschluss).Fakt ist immer noch, WDL und CP nutzen kein DLSS auf den Reflektionen.

Wenn Du keine handfesten Beweise akzeptierst, dann bist Du durch nichts zu überzeugen. Dann ist aber auch diese Diskussion sinnlos und all meine Mühen, Dir das nahezubringen.Control bin ich auch noch nicht wirklich überzeugt.

Kann ich Dir heute Abend anfertigen.Hat mal jemand vernünftige Snaps von Control mit Basis QHD und dann zuschalten der Modi von DLSS?

Du hast nicht verstanden, was Supersampling bedeutet. Du rechnest intern mit größerer "Pixelanzahl" als Nativ Deinen engültigen Farbwert. Daher kann DLSS auch mehr Details bzw. Details die in nativer Auflösung Quantisierungsfehler aufweisen, richtig darstellen.Naja solange es dir gefällt ist es ja in Ordnung. Solange DLSS nicht wie ursprünglich versprochen auf die native Auflösung aufsetzt, kann da nichts besseres raus kommen. Mal gespannt ob und wann man das endlich mal nachreicht. Das würde die Technik deutlich interessanter machen.

In Bewegung hast du Ghosting, was du ohne DLSS nicht hast, also ist es schlechter.Das ist nachweislich Unsinn.

Das stimmt halt so nicht. Es gibt einige Beispiele, in denen es schlechter ist. Das liegt aber nicht an DLSS selbst, sondern an der Art und Weise, wie es implementiert wurde. Genau das ist auch der Punkt, den Zerozerp dir die ganze Zeit versucht zu erklären.DLSS ist immer schlechter als Nativ, redet euch doch nichts ein. Wenn man die Leistung daraus nicht benötigt, schaltet man es nicht ein.

Das passiert leider viel zu selten.Da spricht man auch mal tiefgreifender über solche Themen.

Stimmt halt nicht. DLSS2.0 basiert auf 16K-Rohmaterial, mit dem die KI trainiert wird. Hinzu kommen die Nachbearbeitungsalgorithmen. Es gibt viele Beispiele, wo DLSS2.0-Quality deutlich besser, detailreicher und schärfer aussieht als nativ - bei erheblich besserer Performance. Es gibt Titel wo es aktuell besser läuft und andere, wo es noch nachgebessert werden muss. Grundsätzlich ist deine Aussage aber völlig ignorant und nachweislich in einigen Fällen falsch.DLSS ist immer schlechter als Nativ, redet euch doch nichts ein. Wenn man die Leistung daraus nicht benötigt, schaltet man es nicht ein.

Ganz meine Meinung-Das passiert leider viel zu selten.

Da muss man ganz genau sein, sonst gibts wieder Missverständnisse: Die interne Auflösung wird durch temporale Akkumulation von Frame zu Frame höher.Der Sinn von DLSS ist anhand einer niedrigeren internen Auflösung und KI Algorithmen ein Bild zu berechnen welches dem nativen mindestens ebenbürtig ist und dabei auch noch eine Menge Performance freizugeben.

Das ist richtig, jedoch ist das im Gegensatz zu DLSS1.0, wo man tatsächlich versucht hat, das neuronale Netz Details erraten zu lassen, nunmehr eher eine Nachbearbeitung des vorher durch Akkumulation schon höher aufgelösten Bildes. Die KI schaut im Nachgang darauf, welchem Look sich das Bild annähern muss, um als Artefaktarm durchzugehen.Stimmt halt nicht. DLSS2.0 basiert auf 16K (?) Rohmaterial, mit dem die KI trainiert wird.

Ich habe es nicht nur behauptet, sondern es wurde ja auch entsprechend belegt. Die Anwendungen auf die ich Zugriff hatte,Fakt ist, dass Du behauptet hast, dass es Fakt wäre, dass DLSS nicht auf Reflexionen wirken kann. Ich habe Dir an einem Praxisbeispiel das Gegenteil bewiesen (mit Vergleichsscreenshot und den Originalen im Anschluss).

Mir gefällt die herangehensweise bei Control nicht. Ich würde es von Nativ QHD/UHD mit DLSS runterbrechen und dann vergleichen. Sollte das Upscaling korrekt funktionieren, soltle die Reflektion nur marginal leiden wie der Rest vom Bild auch. DLSS verwendet zusätzlich zur Skalierung ja auch Schärfefunktionen und matscht die Farbwerte zusammen.Wenn Du keine handfesten Beweise akzeptierst, dann bist Du durch nichts zu überzeugen. Dann ist aber auch diese Diskussion sinnlos und all meine Mühen, Dir das nahezubringen.

Gerne.Kann ich Dir heute Abend anfertigen.

Ja, hab ich schon verstanden. Ändert aber nichts daran dass die Auflösung sinkt und man das eben sieht. Ich weiß nicht was es daran nicht zu verstehen gibt. Es macht das Bild in vielen Fällen ruhiger, vor allem filigrane Strukturen was definitiv ein großer Vorteil ist. Die Texturqualität an sich leider aber eben auch beträchtlich, zudem kommen weitere negative Eigenschaften hinzu wie das veränderte Farbbild, Treppchen etc.Du hast nicht verstanden, was Supersampling bedeutet. Du rechnest intern mit größerer Pixelanzahl als Nativ Deinen engültigen Farbwert. Daher kann DLSS auch mehr Details bzw. Details die in nativer Auflösung Quantisierungsfehler aufweisen, richtig darstellen.

Ich verstehe nicht warum Ihr alle immer so weinerlich seid. Ich kritisiere da wo ich es für nötig erachte, mein erster Post hier in dem Thread lautet:ch verstehe nicht, wie du das auch noch so kleinste Haar in der Suppe bzgl. Nvidia rauspickst, aber keine Kritik auf AMD kommen lässt.

Total hochgeleobtIch vermute da wird nicht groß was gescheites bei rum kommen, wenn es proprietär wird wie bei NV ist es für die Tonne.

Ich hab dass doch bereits an entsprechenden Benchmarks dargelegt, meine XT ist Undervoltet schneller als meine 3090 Foudner Undervoltet in den meisten Szenarien.Das OC und UV sei ja so viel besser, was in der Realität gerade mal ein paar Prozentchen sind.

Naja Dirt 5, Godfall und The Medium laufen mit RT schon deutlich runder auf den Radeons als die älteren Titel.Die Reaktion der Leute: Ist ja auch für Nv optimiert. Pustekuchen. Phillipp hat übrigens erstmal ein Ticket bei AMD erstellt

Wir sind weinerlich oder vielleicht bist du einseitig in deiner Sichtweise. Und die reagierst teils völlig stur auf offensichtliche Beweise.Ich verstehe nicht warum Ihr alle immer so weinerlich seid. Ich kritisiere da wo ich es für nötig erachte, mein erster Post hier in dem Thread lautet:

Ja, neuere Titel.... Die daraus fälschlicherweise gezogene Konsequenz, dass die "älteren" Titel dann automatisch auf Nvidia optimiert sein müssen, beobachte ich leider sehr häufig.Naja Dirt 5, Godfall und The Medium laufen mit RT schon deutlich runder auf den Radeons als die älteren Titel.

In Godfall ist aber das Denoising crap.

Du hast es aufgrund Deiner Erfahrungen und der Aussage von CB generalisiert. Es ist mir schon klar, dass das im Gesamtbild für Dich ein: "So muss es sein" ergibt.Ich habe es nicht nur behauptet, sondern es wurde ja auch entsprechend belegt. Die Anwendungen auf die ich Zugriff hatte,

Den Vergleich liefere ich Dir auch heute Abend.Mir gefällt die herangehensweise bei Control nicht. Ich würde es von Nativ QHD/UHD mit DLSS runterbrechen und dann vergleichen.

Supersampling eben. Du erhältst statt einem im Normalfall fehlerhaft quantisierten Pixel den Schnittwert mehrerer Pixel. Dieser "Matsch", wie Du ihn bezeichnest enthält aber korrektere Farbinformationen als das "native" Pixel, welches auf eine Zielauflösung quantisiert wurde.DLSS verwendet zusätzlich zur Skalierung ja auch Schärfefunktionen und matscht die Farbwerte zusammen.

Wie bereits geschrieben. In Frame 1 ist sie niedriger. In Frame zwei ungefähr gleich hoch und ab den folgenden Frames ist sie höher. Das lässt sich im Übrigen auch capturen. Da kann man das sehr schön sehen, wenn ein Szenenwechsel stattfindet.Ja, hab ich schon verstanden. Ändert aber nichts daran dass die Auflösung sinkt und man das eben sieht.

JupIch weiß nicht was es daran nicht zu verstehen gibt. Es macht das Bild in vielen Fällen ruhiger, vor allem filigrane Strukturen was definitiv ein großer Vorteil ist.

Die Texturqualität KANN bei DLSS2.0 nicht leiden, weil diese laut Leitfaden unberührt bleiben muss!!:Die Texturqualität an sich leider aber eben auch beträchtlich, zudem kommen weitere negative Eigenschaften hinzu wie das veränderte Farbbild, Treppchen etc.

Ist ja keiner weinerlich, zumindest habe ich nicht das Gefühl, dass das hier einer wäre.Ich verstehe nicht warum Ihr alle immer so weinerlich seid. Ich kritisiere da wo ich es für nötig erachte, mein erster Post hier in dem Thread lautet:

Und deine Einschätzung zu dem Umstand lautet dann wie? Ich kann gerne mal ne Frametimeanalyse von Godfall machen.Ja, neuere Titel.... Die daraus fälschlicherweise gezogene Konsequenz, dass die "älteren" Titel dann automatisch auf Nvidia optimiert sein müssen, beobachte ich leider sehr häufig.

Ich hab es selbst getestet und das ist meine Einschätzug dazu, ich muss nicht alles feiern nur weil andere das machen und ich muss auch nicht zum hundersten male Wiederholen wo ich einen Nutzen oder die Stärken der Technik sehe nur damit sich man einer gebauchpinselt fühlt hier.Wir sind weinerlich oder vielleicht bist du einseitig in deiner Sichtweise.

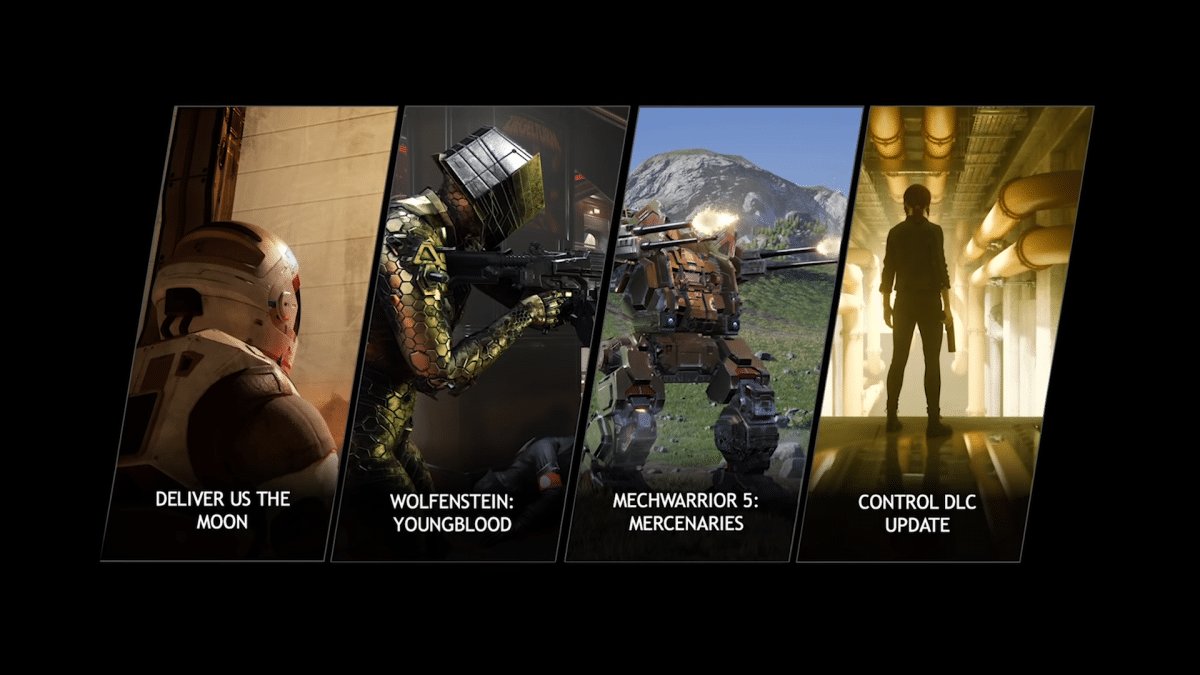

Das ist mein derzeitiger Kenntnisstand, RT Reflektionen werden nicht von DLSS erfasst. Die Aussge wurde sowohl von mehrern Mags getätigt und bei meinen Beobachtungen kann ich das auch klar bestätigen (Youngblood, Mechwarrior(ein Bughaufen mit RT&DLSS), WDL, Brigth Memory und Metro).

Dien Beispiel ais Control ist interessant, keine Frage. Wenn es denn dort der Fall ist dass die Reflektionen erfasst werden, dann ist es zumindest technisch möglich und wird aber quasi nie angewendet. Wahrscheinlich um Leistung zu sparen oder aber Latenzen zu vermeiden.

Auf der Basis werden wir uns einig denke ich

Genau um das macht ein Computerforum doch aus: Solche Sachverhalte zu Diskutieren, das Verständnis und den Kenntnisstand aufzubessern. Know how zusammentragen, vergleichen und schlauer wieder rausgehen...

Nix wurde belegt. Es steht Aussage gegen Aussage. Du ignorierst die Gegenbeweise ja völlig und behauptest Dinge die nicht stimmen. Hier wurde schon mehrfach um Bildbeweise gebeten und die gab es von beiden Seiten. Wenn man nicht gerade DLSS-Performance auf FHD/WQHD als Vergleich heranzieht, sondern vielleicht WQHD oder 4K mit DLSS-Quality, dann ist das Bild schlicht genau so gut oder teils besser, je nachdem ob die Filter laufen oder nicht. Scroll ein paar Seiten zurück und gucke mal auf Control oder zieh dir Bilder von Death Stranding rein. Auch bei Cyberpunk ist DLSS-Quality erste Sahne. Es werden Dinge in der Entfernung sichtbar, die nativ gar nicht existieren. Gab dazu auch schon Bilder hier im Thread. In der Entfernung kommen Details hinzu, die Bildschärfe nimmt normalerweise zu und die Performance steigt um 60% oder mehr, wie wir hier gesehen haben. Wie man da nur rumhaten kann ist mir schleierhaft.Ich habe es nicht nur behauptet, sondern es wurde ja auch entsprechend belegt.

Du fährst in deinem Hypetrain am Thema vorbei.Nix wurde belegt. Es steht Aussage gegen Aussage. Du ignorierst die Gegenbeweise ja völlig und behauptest Dinge die nicht stimmen. Hier wurde schon mehrfach um Bildbeweise gebeten und die gab es von beiden Seiten. Wenn man nicht gerade DLSS-Performance auf FHD/WQHD als Vergleich heranzieht, sondern vielleicht WQHD oder 4K mit DLSS-Quality, dann ist das Bild schlicht genau so gut oder teils besser, je nachdem ob die Filter laufen oder nicht. Scroll ein paar Seiten zurück und gucke mal auf Control oder zieh dir Bilder von Death Stranding rein. Auch bei Cyberpunk ist DLSS-Quality erste Sahne. Es werden Dinge in der Entfernung sichtbar, die nativ gar nicht existieren. Gab dazu auch schon Bilder hier im Thread. In der Entfernung kommen Details hinzu, die Bildschärfe nimmt normalerweise zu und die Performance steigt um 60% oder mehr, wie wir hier gesehen haben. Wie man da nur rumhaten kann ist mir schleierhaft.

Wo ist das Pendant von AMD? Wir sprechen uns wenn Fidelity FX Super Resolution da ist und dann werden wir die selben Maßstäbe anlegen. Es wird ein Fest.

Habe das Thema nur so am Rande verfolgt, allerdings ist mir nur ein Spiel mit DLSS 2.0 in Screenshots wirklich negativ aufgefallen und das ist Cyberpunk. Ich werde die Funktion pauschal aktivieren, wenn sie verfügbar ist.Boah Leute... Es geht um die Aussage man sollte DLSS IMMER anschalten wenn verfügbar. Sorry aber nein.

Das sehe ich auch so.In Death Stranding kann man es bspw. problemlos immer anschalten da die Implementierung hier besser ist.

Bei Cyberpunk aber erst ab 4K, darunter wird das Bild schlechter. Zäune werden schlechter dargestellt, das rote Menü ist verpixelt und die Kantenglättung ist schwer zu ertragen. Ich habe das live bei einem Kollegen gesehen.Auch bei Cyberpunk ist DLSS-Quality erste Sahne. Es werden Dinge in der Entfernung sichtbar, die nativ gar nicht existieren.

Das stimmt nicht. Control, Death Stranding, Mechwarrior, Deliver Us the Moon, usw.DLSS ist immer schlechter als Nativ, redet euch doch nichts ein. Wenn man die Leistung daraus nicht benötigt, schaltet man es nicht ein.

Manche Details sind mit DLSS offenbar besser.Das ist nachweislich Unsinn.

Eingebundener InhaltYoutubeAn dieser Stelle findest du externe Inhalte von Youtube. Zum Schutz deiner persönlichen Daten werden externe Einbindungen erst angezeigt, wenn du dies durch Klick auf "Alle externen Inhalte laden" bestätigst: Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit werden personenbezogene Daten an Drittplattformen übermittelt.

Für mehr Informationen besuche die Datenschutz-Seite.

Welche Titel sind das denn? Cyberpunk finde ich nach Sichtung des Videos etwas schlechter, aber immer noch wesentlich besser als pures Upscaling, ab 4K dann gleichwertig.die aktuellen implementierungen sind oft nicht überzeugend.

Immerhin sitze ich nicht Trübsal blasend am Bahnhof fest.Du fährst in deinem Hypetrain am Thema vorbei.

Das hier ist aus deinem verlinkten Video. Das ist WQHD und DLSS sieht besser aus als nativ. Und der Knaller... man muss erstmal 4x heranzoomen um überhaupt Unterschiede zu finden.Bei Cyberpunk aber erst ab 4K, darunter wird das Bild schlechter. Zäune werden schlechter dargestellt, das rote Menü ist verpixelt und die Kantenglättung ist schwer zu ertragen. Ich habe das live bei einem Kollegen gesehen.

Unter 4K ist es keine Option in Cyberpunk, Death Stranding dagegen klappt sehr gut.

ist dochn witz das ich mit einer 700€ karte runter raufskalieren rekonstruktieren muss um spielbare fps zu bekommen. Früher(als 700€ karten wirklich 700€ gekostet haben) hat mal alles auf ultra geknallt und hatte ruhe.

ist dochn witz das ich mit einer 700€ karte runter raufskalieren rekonstruktieren muss um spielbare fps zu bekommen. Früher(als 700€ karten wirklich 700€ gekostet haben) hat mal alles auf ultra geknallt und hatte ruhe.