Hagelzuckererbse

Freizeitschrauber(in)

Einige hier sind schon echt Hobbylos den ganzen Tag wie kleine Kinder am Diskutieren...

Einige hier sind schon echt Hobbylos den ganzen Tag wie kleine Kinder am Diskutieren...

Ne vorm Pc sitzen würde ich jetzt nicht unbedingt als richtiges Hobby bezeichnenIst es kein Hobby ein "PC Enthusiast" zu sein?

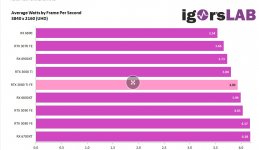

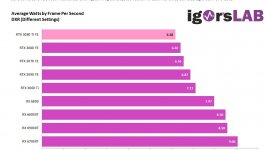

Lehn dich nicht zu weit aus dem Fenster sonst wirst du als AMD Fanboy beschriehen das passiert hier bei einigen genau so schnell wie man bei dem Stromverbrauch bei Ampere weggucken konnte...komischerweise war der Verbrauch bei Ampere kein Problem für viele, auch hier auf dem Board und jetzt meint man bei Ada wieder dass es gegenüber RDNA3 eines wäre,

wobei der Verbrauch der 4070Ti sowie der 4080 gar nicht soweit auseinander liegt zur 7900XT/X, aber die 4070 gegenüber der 7800XT reißt es dann wieder raus, einfach nur stumpfes Stammtischgehabe mehr nicht

Ne vorm Pc sitzen würde ich jetzt nicht unbedingt als richtiges Hobby bezeichnen

Lehn dich nicht zu weit aus dem Fenster sonst wirst du als AMD Fanboy beschriehen das passiert hier bei einigen genau so schnell wie man bei dem Stromverbrauch bei Ampere weggucken konnte...

Wie immer war/ist das halt einseitige Betrachtung.Hier im Forum war DIE HÖLLE los weil Ampere 20-50 Watt mehr TDP hatte (bei vergleichbaren Karten) als RDNA2.

Das ist kein Anhaltspunkt, dass dem nicht so wäre. Die wenigsten verkünden öffentlich, dass Sie Ihren Kauf bereuen. Im Gegenteil, die meisten reden Ihre eigenen Karten eher besser, damit sie sich nicht als "Fehlkäufer" outen.Bislang halten sich die Klagen von 3080-Besitzern in Foren wie diesen wohl eher in ziemlich engen Grenzen.

...

Starfield hat(te) eine achtstellige Spielerschaft. In deiner "Rechnung" mit deiner aus den Fingern gelutschten Zahl hat es aber wohl den denselben Stellenwert wie ein 2€-Steam-Spiel mit 20 Spielern. Keine weiteren Fragen, Euer Ehren.0,000001% aller Fälle = keine Relevanz. Niemand optimiert auf diesen Fall. Niemand kauft etwas nur für diesen Fall.

Genau, weil die meisten Spiele es heute nicht benötigen, wird es in Zukunft auch nicht anders sein. Bestechende Logik. Wenn wir die überall anwenden würden, würden wir noch in Höhlen wohnen.Deine Aussage, dass die These "Nvidia macht schönere Bilder als AMD weil es 1(!!!!!!!!!!!!!!!) Spiel gibt, welches per Default mit Upscalern ausgestattet ist" korrekt ist, da es in Zukunft immer so sein wird ist sehr unwahrscheinlich, da 80% der Games auch heute keine Upscaler brauchen um mit 100+ FPS zu laufen.

Auf Steam alleine gibt es über 50.000 Spiele. Das heißt, alleine nur auf Steam entspricht 1 Spiel ungefähr: 0,002%Starfield hat(te) eine achtstellige Spielerschaft. In deiner "Rechnung" mit deiner aus den Fingern gelutschten Zahl hat es aber wohl den denselben Stellenwert wie ein 2€-Steam-Spiel mit 20 Spielern. Keine weiteren Fragen, Euer Ehren.

Lesen. Ich redete von der falschen Allgemeingültigkeit der Aussage. Sagen wir Ori 5 zum Beispiel. Das wird auch 2030 nicht per Default mit Upscaler gespielt werden (höchstwahrscheinlich). Starfield 6 natürlich schon.Genau, weil die meisten Spiele es heute nicht benötigen, wird es in Zukunft auch nicht anders sein. Bestechende Logik. Wenn wir die überall anwenden würden, würden wir noch in Höhlen wohnen.

Zum mittlerweile dritten Mal: Starfield ist kein Einzelfall. Und ein AAA-Spiel wie Starfield mit allen anderen Steam-Spielen zu vergleichen was Spielerzahlen/Verbreitung angeht oder den Optimierungswillen der GPU-Hersteller..Auf Steam alleine gibt es über 50.000 Spiele. Das heißt, alleine nur auf Steam entspricht 1 Spiel ungefähr: 0,002%

Das ist selbst für deine Verhältnisse erbärmlich.

Das ist selbst für deine Verhältnisse erbärmlich.Der Vergleich war Schwachsinn, denn Upscaling ist teilweise heute schon Standard und/oder Pflicht. 24GB VRAM für 1080p nicht. In keinem einzigen Spiel. Das es nie so kommen wird hab ich nie behauptet. Glatte Lüge. Aber nix neues bei dir.Interessant, dass du von Höhlenbewohnern sprichst, aber dann die Aussage von mir, dass eine Zeit kommen wird, in der 24GB VRAM nicht mehr für FHD ausreichen werden für völlig hanebüchen und unrealistisch hältst.

Ich habe nicht gesagt, dass auch nur einer der Punkte falsch bzw. nicht zutreffend ist.

Entweder es trifft zu, oder nicht. Weniger zutreffend gibt es nicht. Aber du bist ja der Meister der Wortklaubereien.(...) anderen Punkte mal mehr oder mal weniger zutreffend sind(...),

Wie immer war/ist das halt einseitige Betrachtung.

Kein Problem würde ich so nicht sagen; es hat halt nur die Leute in vielen Fällen nicht davon abgehalten, trotzdem zu einer Ampere-Nvidia zu greifen. Dass die Leute ohne diese Schwäche erst recht zu einer Ada-Nvidia greifen, ist ja nur folgerichtig.komischerweise war der Verbrauch bei Ampere kein Problem für viele, auch hier auf dem Board und jetzt meint man bei Ada wieder dass es gegenüber RDNA3 eines wäre,

Natürlich ist es 2 Stufen schlechter. BQ und Bildruhe. Mach dir selbst Bild und Videovergleiche.So ist FSR 3 nicht "2 Stufen schlechter" als DLSS.

Was lediglich eine unsinnige Unterstellung darstellt, aber du kannst ja auch nicht "argumentieren".Nur scheint dir Effizienz bei GPUs ungemein wichtig zu sein, bei CPUs wiederum völlig unwichtig.

.gif)

Achso, dann war das alles Ironie, obwohl das Argument ja richtig ist und es gar nicht um CPUs ging, sondern um GPUs.Und das ist - wie ich bereits erwähnte - ironisch. Falls du das nicht siehst, ist das schade.

Dann stimmst du ihm doch zu. Also wozu dann die Diskussion?Das mag sein.

Bei den neuen Spielen ist FSR/DLSS die Standardeinstellung, bzw wird von den Spielern sowieso aktiviert, weil TAA zu nutzen unsinnig wäre was Aufwand/Nutzen angeht. Gut bei FSR kommt man häufiger nicht an Nativ ran, aber es ist viel besser als die Auflösung zu senken.Aber "sehr bald =/= jetzt".

In etwa 10 Jahren, ja, vielleicht.Sehr bald sind auch 24GB VRAM zuwenig für FullHD.

In welchem Spiel bekommt man in Full HD die 24GB voll? Die Tatsache, dass du das mit der Verbreitung von FSR und DLSS vergleichst, impliziert ja einiges. Hast du überhaupt eine 4080?Jetzt natürlich noch nicht (außer man brute forced es) - aber es hat daher aktuell keine Relevanz.

.gif)

Naja, es gibt schon noch einen Unterschied zwischen weggucken und in Kauf nehmen.Lehn dich nicht zu weit aus dem Fenster sonst wirst du als AMD Fanboy beschriehen das passiert hier bei einigen genau so schnell wie man bei dem Stromverbrauch bei Ampere weggucken konnte...

Du könntest keine subjektivere Aussage treffen, selbst wenn du es versuchen würdest. Welche AMD GPU hast du denn für deine Vergleiche herangezogen?Natürlich ist es 2 Stufen schlechter. BQ und Bildruhe. Mach dir selbst Bild und Videovergleiche.

Es gibt bessere FSR Implementierungen, indem es nur eine Stufe ist, aber meistens sind es 2.

Balanced sieht besser aus als FSR Quality, quasi immer.

Dabei beziehst du dich für diese Aussage nicht auf Upscaling sondern behauptest es einfach so allgemeingültig. Dann spricht man euch darauf an und plötzlich kommen die hanebüchensten Aussagen.Und bei AMD ist weder die BQ, der Stromverbrauch noch die RT Leistung "angemessen".

Keine Ahnung, ich wollte nur @HisN vorbeugen, welcher (früher) gerne Mal Screenshots gepostet hat mit übergelaufenem VRAM wenn er irgendwo Sätze wie "XYZ VRAM kriegt man nicht voll" gelesen hatIn welchem Spiel bekommt man in Full HD die 24GB voll? Die Tatsache, dass du das mit der Verbreitung von FSR und DLSS vergleichst, impliziert ja einiges. Hast du überhaupt eine 4080?.gif)

Gibt aber auch andere Spiele, mit denen man selbst in QHD und RT mit DLSS Quality etwas mehr als 10GB benötigt.Ja, ich habe weiterhin Spaß mit meiner 3080 10GB und keine Probleme. Ich zocke in WQHD, selbst CP2077 mit PT und DLSS Balanced reizt da nicht den VRAM aus und läuft bei 50-60 FPS. Kann das eine 6800XT auch? Ich denke nicht...

Legacy läuft mit 10GB auf ultra wie ein Sack Nüsse, da braucht man eher ~ 11GB, es sei denn man benutzt Regler.Vor 3 Jahren habe ich die 3080 gekauft, was war da los hier im Forum, "VRAM Krüppel", "nächstes Jahr wird da nix mehr laufen", etc etc. Nichts davon ist eingetroffen in meinem Fall.

Ampere war dennoch effizient, vor allem dann wenn RT mit reinkam. Selbst die 3090Ti kann heute noch mit einer 7900XTX mithalten.Hier im Forum war DIE HÖLLE los weil Ampere 20-50 Watt mehr TDP hatte (bei vergleichbaren Karten) als RDNA2. Und das ging einseitig und ausschließlich von Team Red aus.

Die Fähnchen drehen sich nicht nur bei AMD Befürwortern, zumindest ist das mein Eindruck.Jetzt bei RDNA3 vs Ada ist das natürlich ALLES nicht mehr so wichtig. Schon witzig wie sich die Fähnchen im Wind drehen...

Schau doch einfach den Vergleich von HWU, wenn du mir schon nicht glaubst.Du könntest keine subjektivere Aussage treffen, selbst wenn du es versuchen würdest. Welche AMD GPU hast du denn für deine Vergleiche herangezogen?

Nein, ich rede in diesem Zusammenhang permanent von Upscaling (was sowieso jeder nutzt) und du weißt genau, dass ich auch nur das meine und mich darauf beziehe.Dabei beziehst du dich für diese Aussage nicht auf Upscaling sondern behauptest es einfach so allgemeingültig.

Welche Aussage ist von mir denn "hanebüchen"?Dann spricht man euch darauf an und plötzlich kommen die hanebüchensten Aussagen.

Natürlich ist die Effizienz bei einem Max-Leistung Setup sekundär. Das eine hat doch null mit dem anderen zu tun.Und zur Effizienz: Wer sich einen 14900K in den Rechner bastelt (und ihn dann noch übertaktet, was wie wir alle wissen, die Effizienz noch weiter runterzieht im Gegensatz zum undervolten), dem ist Effizienz egal.

Finde ich charakterlich nicht in Ordnung von dir, lieber Drayygo. Aber das weißt du eh.Und das ist ein valider Standpunkt, das meine ich Ernst und nicht negativ. Aber dann argumentiere nicht mit Effizienz bei anderen Bauteilen.

Diesen "Frame" gibst ja du vor. Du hast hier als einziger ein OC System wo es um Leistung geht mit einem puren Vergleich von GPU A/B hergestellt, alleine um etwas provokantes rauszuhauen.Das ist wie (um dein Autovergleich aufzugreifen) n Musclecar mit ~20l/100km Verbrauch zu fahren aber dann zu sagen: "Aber ich tanke ja nicht immer voll, sonst verbraucht der ja mehr wegen des hohen Gewichtes des Benzins im Tank".

Es gibt X Spiele in denen pauschal ein Upscaler eingestellt ist. Guten Morgen.Ich habe das in keiner Silbe mit der Verbreitung von FSR/DLSS verglichen, sondern mit der Verbreitung von Spielen, in denen eine native Auflösung wahlweise nicht auswählbar ist oder per Default ein Upscaler eingestellt ist.

Der Mensch soll ja täglich über 200 mal lügen. Sehr schlaue Argumentation.Und das war ein Beispiel, was dein Kumpel eingebracht hat. Aber das weißt du, nur du scheinst ganz gerne zu lügen

https://de.m.wikipedia.org/wiki/Argumentum_ad_hominem. Gern geschehen.Du solltest vielleicht mal googlen, was ad hominem bedeutet

Klar ist das Stromverbrauchsargument valide - das habe ich nie bestritten. AMD ist bei GPUs aktuell (bzw. seit einer Weile) ineffizienter.

Nur ist es ironisch, bei GPUs den Stromverbrauch bzw. die Effizienz als Argument zu nutzen, während man sie bei CPUs ignoriert (bzw, die Effizienz durch Übertaktung sogar aktiv verschlechtert).

Hier bei PCGH schafft die 4090 in 2160p selbst mit Hilfe von quality-upsampling gerade mal 28 fps und bei tpu sind es in nativ mehr? Na klar.Native ohne DLSS. TPU testet nicht mit DLSS bzw testet extra.

Natürlich schafft es eine 4090 PT in native 4k, sieht dir doch die Werte an, die ich verlinkt habe.