derneuemann

Volt-Modder(in)

Nochmal:

Was wirklich hinter den Abstürzen und Instabilitäten der GeForce RTX 3080 und RTX 3090 stecken könnte | Investigativ | igor´sLAB

Nicht nur die Redakteure und Tester wurden von plötzlichen Instabilitäten der neuen GeForce RTX 3080 und RTX 3090 überrascht, sondern auch die ersten Kunden, die Boardpartnerkarten aus der ersten…www.igorslab.de

,

Du kannst mir sicher erklären wie man so testen will....

Und:

Du kannst gerne Igor hier im Forum dazu fragen.

Der einzige der hier schwafelt, bist du. "mimimi du verstehst die Situation nicht". Tjo anscheinend kannst du nur diesen Satz wiederholen, aber keinerlei Erklärung oder Aufklärung liefern.

Dann kannst du mir erklären, warum EVGA, ASUS, alle einfach, egal wer, es dann released hat. Nicht weil Nvidia die gezwungen hat. Wenn man es nicht testen kann, dann kann man noch nicht verkaufen. Wenn es dann so ist, das Nvidia hier Dreck am stecken hat, weil der Treiber zum Beispiel zu spät zur Verfügung steht, dann wird das auch entsrpechend geregelt. (Finanziell)

Aber ob die Partner, schon veröffentlichen liegt in der Verantwortung der Partner.

GErade das Statement von Gigabyte gelesen und am Ende liegt die Wahrheit überall etwas dazwischen.

Am Ende bleibt, der Treiber funktionierte nicht einwandfrei, mit allen Varianten, die mtiunter auch, durch die BP in den Umlauf gebracht wurden und Nvidia hat hier ein Update gebracht.

Also, immerhin ein Fehler, der durch ein Softwareupdate behoben werden konnte. Wo jetzt die Abstimmung gehakt hat... Wer sich ein Urteil erlauben möchte, bitte

.

.Wenn es nicht an den Kondensatoren liegen sollte, dann war es ja lediglich ein Treiberfehler. Wie er schon bei etlichen Releases vor kam.

Zuletzt bearbeitet:

.gif)

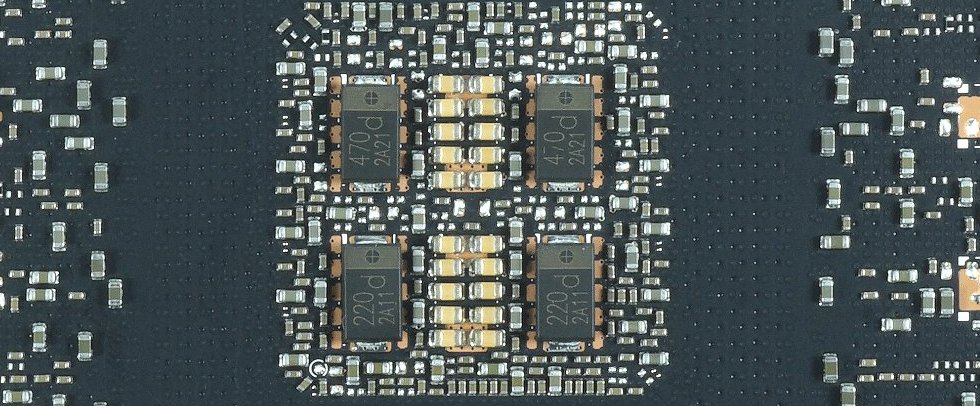

Die unaufällige Vorschau zeigt aber bereits 4+2 - ich denke ich wollte man auf Nummer sicher gehen und wird zukünftig in 4+2 fertigen.

Die unaufällige Vorschau zeigt aber bereits 4+2 - ich denke ich wollte man auf Nummer sicher gehen und wird zukünftig in 4+2 fertigen.