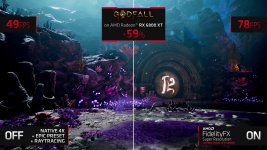

Bezüglich der AMD-Präsentation:

Finde die Bildvergleiche relativ durchsichtig.

AMD FSR Off --> hellere, detailreichere Bildbereiche

AMD FSR ON --> dunkle, schlecht ausgeleuchtete Bildbereiche

Man dreht den Winkel immer so, dass die Unschärfe der Presets nicht auffällt.

Es ist aber im Zoom schon jetzt erkennbar.

Denke, wenn unabhängige Reviewer später die gleichen Maßstäbe wie bei DLSS ansetzen, wird man zu einem vernichtenden Urteil bezüglich der Qualität kommen.

Volle Auflösung:

Man muss nicht mal großartig suchen und es ist schon trotz Youtube-Bildkompression sichtbar.

Da können die ihre Ansichten drehen und wenden wie sie wollen.

Und das da ist das

"Ultra-Quality-Preset":

---

Nvidias KI-Upscaling DLSS ist spätestens seit Version 2.0 so erfolgreich, dass AMD dringend eine Alternative benötigt. Jetzt sind mehr Details und ein Releasedatum bekannt zu "Super Resolution".

mixed.de

Nvidias KI-Upscaling DLSS ist spätestens seit Version 2.0 so erfolgreich, dass AMD dringend eine Alternative benötigt.

AMD hat ein Problem: Immer mehr Titel setzen auf das aufwendige Lichtrenderverfahren Raytracing und Nvidias KI-Upscaling DLSS. Die Technologie bringt teils massive Leistungsgewinne und erzeugt gerade in hohen Qualitätseinstellungen ein hochgerechnetes Bild, das der originalen Auflösung nahekommt und in den Augen manch eines Betrachters sogar übertrifft – dank zusätzlicher KI-generierter Details.

Ja, auch schon gemerkt?

Auf einmal merken alle, dass intelligentes Upscaling die Zukunft ist.

Titel wie Cyberpunkt 2077, die visuell stark von Raytracing profitieren, lassen sich nur mit DLSS in spielbaren Bildwiederholraten erleben.

Ob Cyberpunk 2077 ein gutes oder schlechtes Spiel ist, entscheiden die AMD-Fanboys abhängig davon, wie gut AMD FSR dort funktioniert.

Aktuell ist das Game natürlich schlecht und Raytracing ist kompletter Müll. Mal gucken, wie der Wind dreht, wenn AMD FSR genutzt werden kann und es hoffentlich "gut" ist.

Laut AMD soll sich die Bildwiederholrate im Performance-Modus durchschnittlich verdoppeln im Vergleich zum nativen 4K-Rendering.

Im Qualitätspreset sind es ca 60%, so wie bei DLSS2.0 auch.

Die Leistungsverbesserung ist augenscheinlich gut.

Mal schauen wie die Qualität dann aber auch in der Realität ist, denn:

Wie genau FSR funktioniert, ist weiter unklar. Allerdings verriet AMD gegenüber Anandtech, dass FSR eine räumliche Upscaling-Technologie sein wird und daher nur jedes Bild separat hochrechnet, ohne Bewegungsdaten (Bewegungsvektoren) aus dem Spiel zu berücksichtigen.

Einen ähnlichen Ansatz verfolgte Nvidia mit DLSS Version 1.0, deren Ergebnisse qualitativ weit hinter denen von DLSS 2.0 liegen, das zusätzlich Bewegungsvektoren mit in die Upscaling-Berechnungen integriert.

Das Upscaling soll ab dem 22. Juni als GPUOpen-Technologie verfügbar sein und zu Beginn in “zehn Titeln und Engines” zum Einsatz kommen. Welche das sind, verrät AMD nicht.

Also überall und nirgendwo.

Das ist ja schlimmer als bei DLSS.

DLSS kam im

Februar 2019. AMD FSR kommt jetzt zweieinhalb Jahre später im

Juni 2021 und kämpft wohlmöglich mit den gleichen Kinderkrankheiten, die DLSS damals hatte.

Wenige Games und

suboptimale Umsetung bis zum Refresh der Technologie mit der nächsten Generation.

Außerdem wohl

kein vernünftiger KI-Ansatz.

16K-Rohmaterial kam auch erst mit DLSS2.0.

Das wird ne richtig bittere Nummer für einige Gehypte - im Vergleich natürlich.

Grundsätzlich ist die Technologie natürlich super für alle Beteiligten.

Bin sehr gespannt auf die Direktvergleiche hinsichtlich Qualität und Performance!

Das ist auf jeden Fall für uns Gamer der richtige Schritt gewesen, NVs DLSS Technik wird dann nach und nach von der Bildfläche verschwinden.

Schwachsinn. DLSS ist gerade mal in den wichtigsten Engines implementiert worden. Das lässt sich mittlerweile mit wenigen Klicks per Plugin hinzuschalten. Das bleibt jetzt garantiert erst mal ne ganze Weile.

Ganz davon haben BigNavi-Grafikkarten im Vergleich zu Turing/Ampere-Grafikkarten kaum einen relevanten Marktanteil, wenn man sich die Hardware-Surveys anschaut. DLSS-Nutzer gibt es mittlerweile extrem viele.

DLSS ist keine schlechte Technik aber warum sollten Entwickler Zeit und Geld investieren und am Ende nur die halbe Käuferschaft ansprechen, wenn sie mit einer offenen Technik alle inklusive Konsolen erreichen?

Weil es kein großer Akt ist DLSS zu aktivieren.

Das hat jetzt quasi Nativ-Support in der UnrealEngine und in Unity, weitere folgen.

Man kann das eine machen ohne das andere zu lassen.

Zurück zum Artikel: AMD Fidelity FX Super Resolution: Der DLSS-Konkurrent im Video

Zurück zum Artikel: AMD Fidelity FX Super Resolution: Der DLSS-Konkurrent im Video

Aktuell ist das Game natürlich schlecht und Raytracing ist kompletter Müll. Mal gucken, wie der Wind dreht, wenn AMD FSR genutzt werden kann und es hoffentlich "gut" ist.

Aktuell ist das Game natürlich schlecht und Raytracing ist kompletter Müll. Mal gucken, wie der Wind dreht, wenn AMD FSR genutzt werden kann und es hoffentlich "gut" ist.

.

.