TheFanaticTesters

Software-Overclocker(in)

Damit war jetzt gemeint das nun auch der Monitor das Ganze unterstützen muss.

Daher nochmal die Rückfrage. Gab es damals denn keine HDR Monitore oder warum kommen die erst jetzt?

Das kommt mir irgendwie alles sehr seltsam vor.

korrekt es gab noch keine hdr fähige tvs gibt es seit ende 2015 mein samsung js9000 einer der ersten war der es konnte...und selbst der ist nicht mehr ganz top den die neuen können eben 1000nits meiner nur 500 und es macht sehr viel aus...

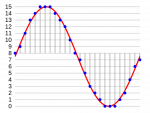

der erklärt es recht gut damit hab ich damals angefangen

Samsung SUHD JS9590: HDR und Quantum Dot Farbraumerweiterung erklart (dt. UT) - YouTube