Aber wir haben das doch gesehen, Nvidia hat Ampere völlig überhastet auf den Markt gebracht, weil sie die Hosen voll hatten und wussten was AMD mit RDNA2 geleistet hat.

AMD kann jetzt die Architektur in Ruhe weiter entwickeln, währen Nvidia ganz neu ran muss, dazu kommt noch der entwicklungs Vorsprung den AMD bei MCM inne hält, es sieht für die Grünen mittelfristig nicht gut aus.

Meine Vermutung ist gar, dass Nvidia das gleiche Schicksaal wie Intel ereilen wird, eher früher als später.

Himmel Chatstar, komm doch mal runter von deiner kindlich-naiven Fürsprache:

> "

Aber wir haben das doch gesehen ..." Haben wir das? Ich glaube du verwechselst das eher mit deinem Wunschdenken und deine Meinungsäußerung bekommt nicht dadurch mehr Gewicht, weil du versuchst dich einer vermeintilch größeren Gruppe zuzurechnen, die das angeblich genau so sieht wie du.

> "

Nvidia hat Ampere völlig überhastet auf den Markt gebracht ..." Du scheinst einen direkten Draht in die nVidia-Chefetage zu haben oder aber übernatürliche Fähigkeiten zu besitzen. Bei allem was mir so untergekommen ist (und das war durchaus viel) gab es nichts, was auf einen derartigen Schluss führte. (

Überhastete Veröffentlichungen waren zuletzt eher AMDs Metier, und das gleich mehrfach.)

> ".

.. weil sie die Hosen voll hatten und wussten was AMD mit RDNA2 geleistet hat." Natürlich wussten die das, denn die entwickeln deutlich länger und erfolgreicher GPUs als AMD und können das entsprechend abschätzen. Nur warum sollten die die "

Hosen ...."? AMD wird ihnen nirgends wirklich gefährlich und die können jedes AMD-Produkt mit ein oder zwei eigenen Produkten kontern und zu allem Ungemach für AMD kommt derzeit noch hinzu, dass die offensichtlich weitaus weniger Karten als nVidia liefern können.

> "

AMD kann jetzt die Architektur in Ruhe weiter entwickeln, währen Nvidia ganz neu ran muss ..." Lol, das kann nVidia als Marktführer ebenso "

in Ruhe" angehen lassen (

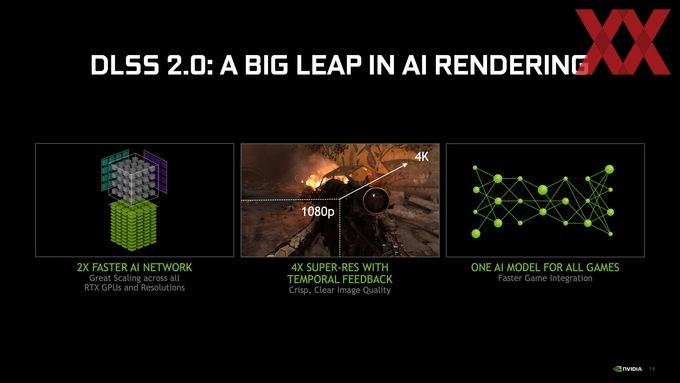

wenn man es derart künstlich überzogen und diametral darstellen will) und warum sollten die alles neu aufrollen müssen? Dazu haben die überhaupt keinen Anlass. Die haben die anscheinend bessere RT-Implementation, haben Tensor Cores und ein entsprechendes Äquivalent fehlt AMD derzeit gar komplett, und die haben die deutlich durchsatzstärkeren Shader.

Du hast hier die Designziele von RDNA2 nicht verstanden. AMD hat hier sehr konservativ entwicklet und sich im Wesentlichen auf die Effizienz und einen hohen Takt konzentriert, d. h. sich hier im Wesentlichen auf den Implementations/Fertigungsprozess konzentriert. RDNA2 ist schlussendlich weitaus konservativer und biederer geworden, als man zuerst vermuten konnte bzw. hoffte und die dargebotene Leistung wird primär durch den hohen Takt erreicht.

Die leistungsfähigere Architektur hat zweifellos nVidia, die sich für die Verwendung von Samsungs 8LPP entschieden haben, was denen absehbar wieder eine hohe Marge bescheren wird, also aus geschäftstechnischer Sicht eine durchaus nachvollziehbare Entscheidung. Hätten die die kleineren Ampere's ebenfalls auf TSMCs N7 gefertigt, hatte AMD wohl gar nicht mehr mithalten können, denn dann hätten auch die Ampere-Modelle noch ein paar MHz mehr vertragen (

zweifellos nicht auf den Niveau der Navi-Chips, aber dennoch mehr) und wären dadurch noch einmal pauschal schneller geworden. AMD muss hier architektonisch weiterhin aufholen, denn auf dem Niveau von nVidia sind sie noch längst nicht.

> "

... dazu kommt noch der entwicklungs Vorsprung den AMD bei MCM inne hält ..." Äh, what? AMD ist hier Nachzügler, nix Vorsprung. MCM ist schon ein alter Hut. Erstens weiß man noch gar nicht ob RDNA3 schon ein MCM wird, denn deren kürzlich gesichtetes Patent kann sich durchaus auf spätere Designs beziehen oder wird erst mal mit Blick auf CDNA2 umgesetzt? Darüber hinaus präsentierte nVidia schon in 2019 auf einer Tech-Konferenz ein MCM-HPC-Design, d. h. die sind da schon lange dran und werden zweifellos auch deutlich mehr Ressourcen als AMD haben. Und Intel wird gar schon gesichert in 2021 entsprechende Datacenter-Produkte mit Xe-HP in den Markt brignen und Xe-HPC dürfte AMDs aktuelle Möglichkeiten gar deutlich übertreffen.

Darüber hinaus kann man nicht einmal gesichert behaupten, dass AMD diesen "Vorsprung" bei CPUs inne hat. Die haben zwar entsprechende Produkte im Markt, technologisch ist Intels Portfolio bzgl. derartiger Technologien wie EMIB, Co-EMIB, Foveros und ODI deutlich reichhaltiger und voraussichtlich auch leistungsfähiger. (

AMD hatte hier jahrelang Glück, dass Intel so lange durch seine Fertigungsprobleme ausgebremst wurde; bspw. brauchbare 10nm Anfang 2018 mit Cannon Lake und dann in 2019 auf dem Desktop wären kein Spaß für AMD und ein echtes Problem für Zen2 gewesen.)

> ".

.. es sieht für die Grünen mittelfristig nicht gut aus" In deiner Fantasiewelt? nVidia wird dieses Jahr mit mindestens +65 % mehr Umsatz und mit etwa +200 % mehr Gewinn als AMD abschließen. Die sind wirtschaftlich deutlich erfolgreicher und technologisch stehen die eh gut da. (

Der aktuellen Entwicklung nach wird AMD nicht mal mit dem Jahresabschluss 2023 (trotzt ihrer CPU-Sparte) an nVidia heranreichen können.)

> "

Meine Vermutung ist gar, dass Nvidia das gleiche Schicksaal wie Intel ereilen wird, eher früher als später." Du meinst der unangefochtene Marktführer in ihrem Segment zu sein mit Umsatz und Gewinn, das sich bereits deutlich von der zweitplatzierten Konkurrenz absetzt?

AMD wird bis zur Mitte dieses Jahrzehnts nicht einmal ansatzweise an Intel heranreichen können, weil solche Marktentwicklungen viel Zeit beanspruchen. Die grob 70 Mrd. US$ Umsatz von Intel sind für AMD noch in sehr, sehr weiter Ferne ... Entweder hat hier dein Bias gesprochen oder du hast schlicht kein Verständnis für den Markt und seine Entwciklungen. Nur weil eine Firma ein gutes Produkt liefert, dass insbesondere du magst und allen anderen vorziehst, wird diese Firma dadurch nicht automatisch zum Marktführer.

Einfach mal einen Gang zurückschalten und etwas nüchtener auf die Tatsachen blicken. Zudem solltest du grundsätzlich im Hinterkopf behalten, dass der Markt in seiner Gesamtheit die vermeintlichen Kritikpunkte an nVidia und ihrer Ampere-Generation eher weniger zu teilen scheint, d. h. rein soziopsychologisch treffen sich hier in solchen Foren eher eingefleischte Fans auf der Suche nach Gleichgesinnten, jedoch sollte deren Anhäufung nicht zu dem Fehlschluss verleiten, dass das eine allgemein vorherrschende Sichtweise oder gar Tatsache darstellt. Wäre dem so, müsste man dem Großteil der Marktteilnehmer unterstellen, dass die gegen ihren Willen gezwungen werden nVidia-Produkte zu kaufen ... und das dürfte wohl eher weniger der Fall sein. Da bleibt dann als Rettungsanker für die eigene, verzerrte Sichtweise nur, dass der durchschnittliche PC-Käufer/Gamer dumm wie Brot ist und sich kein Bisschen um das kümmert, was er da gerade im Begriff ist, zu kaufen, auch wenn er da mehre Hundert oder gar Tausend Euro aus dem Fenster wirft ... und anscheinend werden solche frei zugänglichen Publikationen wie hier auf der PCGH-Webseite auch von keinem sonst konsumiert ...

ich sehe schon, es ist sehr schwer hier sachlich und faktenbasiert zu diskutieren, warum eigentlich?

Äh, what? Du solltest vielleicht bzgl. deiner Selbstwahrnehmung noch ein wenig nachjustieren ...

Von "

sachlich und faktenbasiert" erscheinst du mir hier so weit weg zu sein wie kaum ein anderer. Es gibt da zwar noch ein paar Gesellen, aber bei denen habe ich eher den Eindruck, dass die sehr genau wissen, was die da in dem Moment sagen/posten und eher provozieren wollen ... bei dir dagegen habe ich eher den Eindruck, du glaubst den Unsinn, denn du da so stellenweise verzapfst auch tatsächlich ...

en.wikipedia.org

Ich kenn's ja von meinem Ryzen. Ganz klassisch. AMD kündigt immer irgendwas richtig Fettes an, die Fans sind begeistert und hypen in den Foren rum wie Sau und mit der Zeit kommen dann allmählich minimale Verbesserung, die dann aber am Ende entweder keine Sau mehr interessieren, weil dann schon die Next-Gen ansteht und neue Hype-Gerüchte umhergehen oder sie sind dann doch so irrelevant, dass man gar nicht mehr großartig darüber berichtet. Das ist der perfekte Marketing-Kreislauf.

Ich kenn's ja von meinem Ryzen. Ganz klassisch. AMD kündigt immer irgendwas richtig Fettes an, die Fans sind begeistert und hypen in den Foren rum wie Sau und mit der Zeit kommen dann allmählich minimale Verbesserung, die dann aber am Ende entweder keine Sau mehr interessieren, weil dann schon die Next-Gen ansteht und neue Hype-Gerüchte umhergehen oder sie sind dann doch so irrelevant, dass man gar nicht mehr großartig darüber berichtet. Das ist der perfekte Marketing-Kreislauf.