Skysnake

Lötkolbengott/-göttin

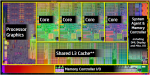

Sandy Bridge DIE-Shot im Rückblick

Nachdem Sandy Bridge nun schon einige Zeit offiziell zu kaufen ist, wolle ich mir mal einige Spekulationen zu Sandy Bridge rückblickend anschauen, was wahr wurde und was nicht.

Hierbei bin ich auf einen DIE-Shot gestoßen, welcher bereits 2009! Sandy Bridge zeigte. Vergleicht man diesen mit dem finalen DIE, sieht man eine verblüffend große Übereinstimmung, man könnte fast meinen, das Bild von 2009 war bereits ein finaler Sandy Bridge. Sicher gab es noch viele kleine aber wichtige Änderungen, das Grundkonzept etc. stand 2009 aber definitiv bereits fest.

PC Watch hatte mit Hiroshige hier eine wirklich gute Quelle. Hoffen wir das zu den nächsten und übernächsten Generationen ebenso gute Quellen aufgetrieben werden

Bilder zu breit

Quelle: [Šg‘å‰æ‘œ]yŒã“¡O–΂ÌWeeklyŠCŠOƒjƒ…[ƒXz WestmereŒnCPU‚̃‰ƒbƒVƒ…‚Æ‚È‚éIntel‚Ì2010”Nƒ[ƒhƒ}ƒbƒv

Nachdem Sandy Bridge nun schon einige Zeit offiziell zu kaufen ist, wolle ich mir mal einige Spekulationen zu Sandy Bridge rückblickend anschauen, was wahr wurde und was nicht.

Hierbei bin ich auf einen DIE-Shot gestoßen, welcher bereits 2009! Sandy Bridge zeigte. Vergleicht man diesen mit dem finalen DIE, sieht man eine verblüffend große Übereinstimmung, man könnte fast meinen, das Bild von 2009 war bereits ein finaler Sandy Bridge. Sicher gab es noch viele kleine aber wichtige Änderungen, das Grundkonzept etc. stand 2009 aber definitiv bereits fest.

PC Watch hatte mit Hiroshige hier eine wirklich gute Quelle. Hoffen wir das zu den nächsten und übernächsten Generationen ebenso gute Quellen aufgetrieben werden

Bilder zu breit

Quelle: [Šg‘å‰æ‘œ]yŒã“¡O–΂ÌWeeklyŠCŠOƒjƒ…[ƒXz WestmereŒnCPU‚̃‰ƒbƒVƒ…‚Æ‚È‚éIntel‚Ì2010”Nƒ[ƒhƒ}ƒbƒv

Anhänge

Zuletzt bearbeitet von einem Moderator: