Vorbestellt bei Alternate ok aber die Angabe "13.-15. Juli" wird wohl nur ein Platzhalter sein, die anderen Shops reden von 30. Juli.

Schade, der 3900X ist für meinen Workload wirklich ein brutales Gerät... und jetzt kann ich wieder Wochenlang auf den DHL-Mann warten.

Caseking spuckt für alle CPUs den 10.07. aus. Außer für den Ryzen 5 3600...

Die CPU erreicht kaum den genanten Boost Takt.. es ist jetzt anscheinend der absolute maximal Takt.

Also quasi, wie es Intel seit jeher macht? Dort wird auch groß und werbewirksam "5GHZ!!!" drangeschrieben... Dass das genaugenommen nur für den SC-Turbo gilt, wird natürlich verschwiegen.

Wenn der 6 Kerner schon so heiß wird, was wird dann wohl mit dem 12 oder 16 Kerner

Ich würde da einfach mal abwarten. Nicht umsonst gibts ne TDP - der 3900X hat auch nur 105W TDP, da können 12 Kerne halt nicht maximal schnell takten.

Viel wärmer wird dort (vermutlich) nix.

Die CPUs sind ohne Frage stark, ausgehend von einem 7820X mit OC, schnellen Ram und optimierten Timings lohnt sich ein kompletter Plattformwechsel für mich jedoch in keinem Fall. Gut, dass ich ohnehin geplant hatte auf Cascade Lake-X zu warten. Taugt der was und wird der nicht zu teuer, wird es der wohl werden. Wenn nicht, bleibe ich erst mal beim 7820X.

Naja gut - bei allem was man sich von Ryzen 3000 erhofft hat - aber gegenüber einem 7820X OC da noch deutliche Vorteile zu erwarten ist dann doch etwas übertrieben gewesen, oder?

Weil man damit Geld verdienen kann. Es muss nicht alles sinnvoll sein was Kohle bringt...

Warten wir mal die 12- und 16-Kerner mit OC ab.

Dass die Achtkerner abseits von PCIe 4.0 keine großartigen Nachteile auf X370/X470 haben werden ist nun kein großes Wunder. Gabs doch schließlich schon Achtkerner für die Boards.

Gerade mit OC dürften aber die ein oder anderen X470- und auch etliche B450-Mainboards spätestens mit dem 12-Kerner aber auf thermale Grenzen stoßen.

An alle, die den Umfang bemängeln:

Wir haben noch ein Heft

Naja gut, dass ihr das Heft noch habt ist die eine Sache. Der Testumfang ist leider doch ein bisschen zu dünn ausgefallen - es gibt ja leider nicht mal Temperaturwerte.

Wie man an den Namen erkennen kann, haben wir aber seit dem 1.7. einen neuen CPU-Fachredakteur, das hat die Testkapazitäten eingeschränkt. Schlechtes Timing, böses AMD

Willi ist ja jetzt auch nicht wahnsinnig über seine Sonntagsarbeit begeistert. In vielerlei Hinsicht war der Launch für euch ungünstig.

Darf man fragen, wer sich vorher um den CPU-Fachbereich gekümmert hat bzw. wer gegangen ist?

Bei Zen hat AMD gesagt, AM4-CPUs haben maximal 95 Watt und MSI hat 95-W-Mainboards designt

Bei Zen+ hat AMD gesagt, AM4-CPUs haben maximal 105 Watt und MSI hat 105-W-Mainboards designt.

Jetzt erzählt AMD, AM4-CPUs hätte maximal 105 Watt, aber schon der 12-Kerner verbrät gerne mal 140-150 W ohne manuelles OC (zum 16-Kerner habe ich hinter vorgehaltener Hand deutlich höhere Zahlen bei nicht gerade revolutionären Taktraten gehört) und MSI designt Mainboards von denen sie hoffen, dass die mit Ryzen 4000 nicht direkt wieder am Limit laufen.

Diese Vorbereitung für mehr gibt es aber nicht umsonst.

Naja, die Mainboards knapp auf Kante auslegen ist bei Boards und CPUs die prinzipiell OC erlauben generell blöd. Da braucht sich MSI nicht wirklich wundern wenn sie dafür kritisert werden. Mit B450/X470 hat MSI dafür ja auch ganz gute Arbeit geleistet...

Der8auer ist der Superguru.

Der8auer ist doch schon sehr stark durch seine Influencer-Rolle getrieben. Auch wenn er zweifelsfrei ne Menge Ahnung hat, aber aufgrund dessen würde ich mich nicht 100%ig auf ihn verlassen (sollte man eh nie, aber naja...).

Die finalen Taktraten sind für mich auch eher enttäuschend da ich ein paar Hundert MHz mehr erwartet hatte an "Luft" aber was solls.

Die Taktraten sind doch relativ latte (braucht ich dir nicht erklären, aber bist ja nicht der Einzige der hier liest

).

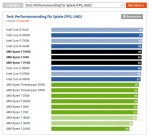

Trotz deutlich geringeren Taktraten reicht Ryzen 3000 in Spielen relativ weit an Intel ran bzw. ist zum Teil sogar flotter. Selbst wenn Ryzen 3000 langsamer ist - er ist deutlich günstiger. In Anwendungen steht die Leistungsfähigkeit von Ryzen 3000 sowieso nicht zur Debatte, da sieht Intel jetzt schon alt aus.

Spätestens wenn die ersten 10nm-Desktop-CPUs von Intel auf den Markt kommen wird auch den Intelanern der Takt auf einmal nicht mehr so wichtig sein.

Da läufts nach aktuellem Kenntnisstand ja auch auf keine großartigen Leistungssteigerungen hinaus, da die angeblich recht hohen IPC-Steigerungen durch die deutlich geringeren Taktraten verpuffen.

Wurde erwähnt, dass die Intel CPUs nicht mit den aktuellsten Windows Patches getestet wurden?

Hier bei der PCGH oder wie?

Der 3000er bringt was versprochen wurde und nun ja die 7NM kann man halt nich so einfach kühlen, Fläche ist zu klein. Das ist auch der Grund wieso die 3000er Serie trotz extreme niedrigen Verbrauch also 3900X so warm wird.

Meinen Erfahrungen nach wird auch schon Ryzen 2000 mit OC ziemlich warm... Da bin ich extrem gespannt wie beim 3800X die Temperaturen mit meiner Wakü ausfallen (Heatkiller IV Pro + MO-RA 3 420 + 360er-Radi).

. 1080p Low und ner 2080TI fertig.

. 1080p Low und ner 2080TI fertig.

.gif)