Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

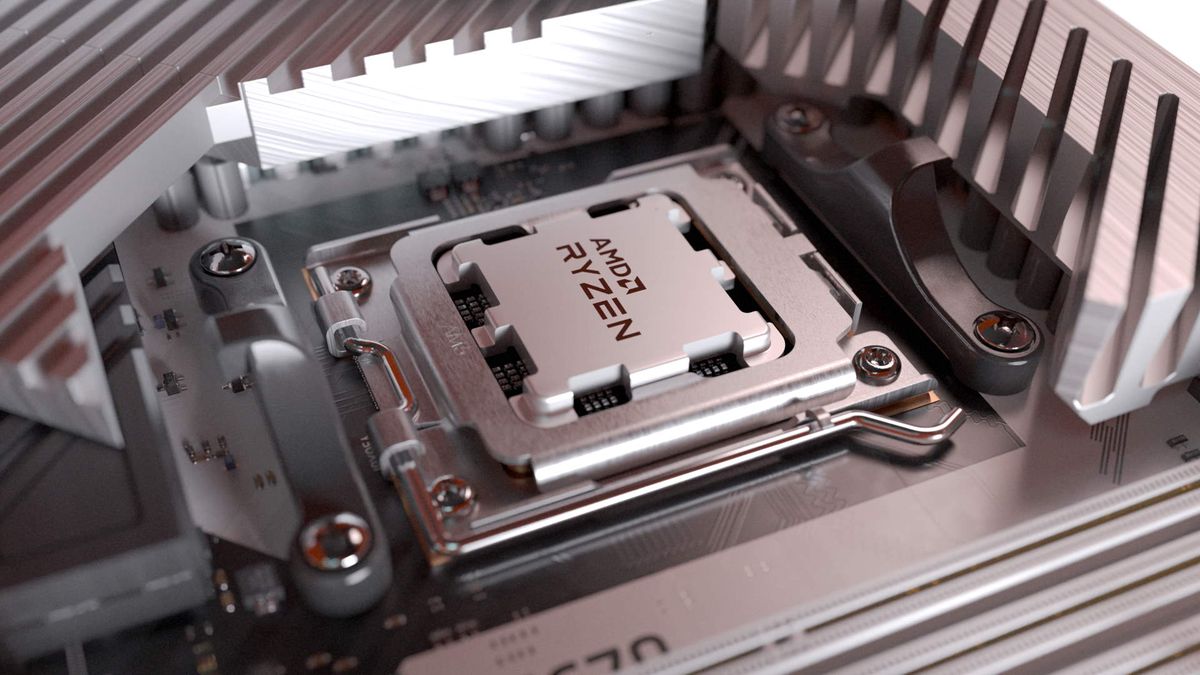

News Ryzen 7 7800X3D vs. Ryzen 9 7950X3D: Auch der große Bruder wird laut AMD in ausgewählten Spielen geschlagen

- Ersteller PCGH-Redaktion

- Erstellt am

Snowhack

BIOS-Overclocker(in)

Wäre damit aber trotzdem 100€ teurer als ein 13700KF. Und bringt in Games (außer in FHD auf einer 4090) wahrscheinlich kein FPS mehr. Wer wirft die 100€ freiwillig zum Fenster raus für nicht optimalen RAM-Support, lange bootzeiten (nicht nur beim ersten initial ram-training sondern dauerhaft) und am ende trotzdem "nur" einen 8-Kerner. Bin da nicht ganz so optimistisch, ob das ein guter Deal ist...

Ich würde die 100€ Investieren für die Zukunftssicherung bis 2026 wird der Sockeln noch Nachschub bekommen an CPUs

Dann noch mal schön einen Ryzen 7 10800X3D drauf und man spielt wieder ganz vorne mit bei einer 4 Jahre alten Platform.

Bei Intel kannst erstmal komplett neu anfangen. CPU Mobo eventuell DDR6

Bis 2026.

Bis 2026.

Zuletzt bearbeitet:

G

Gast1684876202

Guest

bis 2025 sind 5 Jahre? der TR4 wurde trotz "long-term support" mit der nächsten Generation beerdigtAM5 haste noch die nächsten 5 Jahre, die Intel 13000er Plattform ist tot z.b. wäre für mich schon das einzige Argument was ich bräuchte.

der 7800x3d wird doch erst morgen Released oder verpasse ich da was?Übrigens: abwarten und F5 drücken. hehe ;-P

Bobhais

Software-Overclocker(in)

Wenn man mit der Kiste nur spielt ist es auf absehbare Zeit ein guter Deal.Bin da nicht ganz so optimistisch, ob das ein guter Deal ist...

Kann sich natürlich auch nach 2 Jahren als Irrtum herausstellen und ein 13700K/13900K zieht aufgrund der Kerne vorbei.

In Cyberpunk inkl. RT sind es schon 20 bis 30% zwischen 8 und 16 Kernen.

Nathenhale

Volt-Modder(in)

Ja, aber der Test soll schon eute um 15 Uhr kommen.der 7800x3d wird doch erst morgen Released oder verpasse ich da was?

derneuemann

Volt-Modder(in)

Wo denn?Wenn man mit der Kiste nur spielt ist es auf absehbare Zeit ein guter Deal.

Kann sich natürlich auch nach 2 Jahren als Irrtum herausstellen und ein 13700K/13900K zieht aufgrund der Kerne vorbei.

In Cyberpunk inkl. RT sind es schon 20 bis 30% zwischen 8 und 16 Kernen.

Gerade bei PCGH nochmal geschaut

AMD Ryzen 9 7950X3D im Test: Der Gipfel der CPU-Entwicklung [Update zum Verkaufsstart]

Hier finden Sie Benchmarks in Spielen und Anwendungen zum 7950X3D. Die Beobachtung wird durch einen Index abgeschlossen.

von 6 Kernen auf 16 Kerne sind es bei PCGH schon nur 17% ( 7600X auf 7950X) 8 Kerne habe ich nicht heran gezogen, denn entweder ist Cyberpunk fehlerhaft programmiert, oder es handelt sich um einen Messfehler. Ansonsten könnte es nicht sein, das ein 8 Kerner mit gleichem Takt schlechter läuft als der 6 Kerner. Zumindest nicht wenn 12, oder 16 Kerne wieder schneller sind.

Selbst wenn man jetzt mal sehr theoretisch eine für Spiele idieelle Parallelisierung annimmt, wird man erstmal unabhängig von der verbrauchten Energie mit 16/32 zu 8/16 K/T nur maximal plus 52% an Fps raus holen können (Heute eher 5-20%). Wenn man aber beiden CPUs die selbe TDP zuteilt wird man zum Beispiel fiktiv bei der kleinen CPU bei 100W rund 5Ghz fahren können und bei der großennur rund 4GHz.

Da wäre man arg theoretisch bei nur noch 25-30% Vorteil für einen 16/32 Boliden. (also in einer Zukunft, wo jedes Spiel darauf optimiert ist und so gut optimiert ist, wie heute kein einziges)

Dabei bliebe immernoch das Problem, das manche Berechnungen länger brauchen als andere und oder auf andere waretn müssen. Hier könnte die große CPU durch die 4GHz überproportional an Leistung verlieren.

Nur mal so als Idee.

Die Entwicklung ist nicht umsonst wie die ist. Intel macht aus gutem Grund 8 P Kerne und nicht mehr. AMD wollte doch auch mal auf das big little Konzept.

ich persönlich glaube das Spieler noch in 2030 mit 8 P Kernen optimal aufgestellt sind und auch das Spiele auch dann immer noch nur minimal von mehr als 8 Kernen profitieren werden.

Ein 7600X mit 3d Cache wäre für mich rein technisch mal ultra interessant. Denn dieser würde wieder deutlich machen, das Kerne nicht alles sind.

Ein 1800X gewinnt immer noch nicht flächendeckend gegen einen 7700k. Auch damals sagte man schon, das bald werden Spiele mit 8 Kernen davon laufen.

Nathenhale

Volt-Modder(in)

Wie gesagt Cyberpunk ist was AMD 8 Kernern angeht eine Außnahme weil er für Cyberpunk auch mit Threads nur 8 kerne hat.Wo denn?

Gerade bei PCGH nochmal geschaut

AMD Ryzen 9 7950X3D im Test: Der Gipfel der CPU-Entwicklung [Update zum Verkaufsstart]

Hier finden Sie Benchmarks in Spielen und Anwendungen zum 7950X3D. Die Beobachtung wird durch einen Index abgeschlossen.www.pcgameshardware.de

von 6 Kernen auf 16 Kerne sind es bei PCGH schon nur 17% ( 7600X auf 7950X) 8 Kerne habe ich nicht heran gezogen, denn entweder ist Cyberpunk fehlerhaft programmiert, oder es handelt sich um einen Messfehler. Ansonsten könnte es nicht sein, das ein 8 Kerner mit gleichem Takt schlechter läuft als der 6 Kerner. Zumindest nicht wenn 12, oder 16 Kerne wieder schneller sind.

Da CDPR keine lust hat einen Fehler zu beheben der seit tag 10 oder so bekannt ist.

Meist ist der Unterschied zwischen einem 8 oder mehr kerne in Games realtive egal.

"Bisschen Schade, dass er gerade in Spielen Federn lässt, in den schon der 7950x3d schlechter als der 13900k war. Speziell Cyberpunk."

Warum sollte er sich da so dermassen anders verhalten? Ist dir klar was ein 7950X3D ist, und wie er in Spielen arbeitet?

Es sind einfach 2 zusammengepappte 8 Kerner, und ein CCD wird in Games einfach abgeschalten, solange 16 Threads ausreichen, und zwar das ohne den Zusatzcache.

Also ist er Quasi beim zocken auch nix anders als ein 7800x3D mit schlafendem 2 Chiplet.

(mit etwas anderem Taktverhalten, deswegen wundert es mich das der an den grossen rankommen soll, denn der läuft mit dem meisten Takt)

Der 7950x3D nutzt da auch nur 8 Kerne, und hier wird über die Leistung des reinen 8 Kerners berichtet. Wo soll da deiner Meinung nach ein grösserer Unterschied herkommen? Erklär mir das doch mal bitte.

Antwort auf den Einwurf eines anderenUsers:

"Ein 7600X mit 3d Cache wäre für mich rein technisch mal ultra interessant. Denn dieser würde wieder deutlich machen, das Kerne nicht alles sind."

Wenn dich das interessiert, schau dir den Test des 7900x3D an. Andere Seiten haben den sogar auch nur mit 1 Chiplet betrieben, es kommen einstelligen Unterschied im Durchschnitt, mit 2 Abweichungen von bis zu 2x FPS raus. Allerdings bewegen wir uns dort in einem Bereich von ca. 300 FPS, so das man da in der Realität nix von merken dürfte, da es natürlich 720p ist. Je höher die Auflösung, desto geringer die Auswirkung die die fehlenden Kerne zur Zeit haben.

Auch wenn viele es nicht gern hören, der 7900x3D war im Index an 4 Stelle nach 7950x3D, 13900ks, 13900k. Er hällt in meinen Augen mit allen Hig End CPUs gut mit, und ist, zum entsprechenden Preis in meinen Augen keine so schlechte Alternative, sofern der 7800x3D nicht oder nur zu Mondpreisen verfügbar ist.

Somit sollte es eigentlich, wenn man nicht gerade eine 4090 betreiben will kein CPU Bottleneck geben.

Lies CB den Thread zum 7900x3D dort habe ich alles genau beschrieben. (änlicher Nickname).

Um es deutlich zu sagen, der 7900 nutzt genau wie der 7950 auch nur das "x3D" Chiplet, das andere legt er genauso schlafen. (also dein Vergleich 6 zu 8 Kernen) Somit sollte deine Frage beantwortet sein. Es macht real kaum einen Unterschied zum jetzigen Zeitpunkt, wenn ich nach den Tests gehe.

Grüsse.

Warum sollte er sich da so dermassen anders verhalten? Ist dir klar was ein 7950X3D ist, und wie er in Spielen arbeitet?

Es sind einfach 2 zusammengepappte 8 Kerner, und ein CCD wird in Games einfach abgeschalten, solange 16 Threads ausreichen, und zwar das ohne den Zusatzcache.

Also ist er Quasi beim zocken auch nix anders als ein 7800x3D mit schlafendem 2 Chiplet.

(mit etwas anderem Taktverhalten, deswegen wundert es mich das der an den grossen rankommen soll, denn der läuft mit dem meisten Takt)

Der 7950x3D nutzt da auch nur 8 Kerne, und hier wird über die Leistung des reinen 8 Kerners berichtet. Wo soll da deiner Meinung nach ein grösserer Unterschied herkommen? Erklär mir das doch mal bitte.

Antwort auf den Einwurf eines anderenUsers:

"Ein 7600X mit 3d Cache wäre für mich rein technisch mal ultra interessant. Denn dieser würde wieder deutlich machen, das Kerne nicht alles sind."

Wenn dich das interessiert, schau dir den Test des 7900x3D an. Andere Seiten haben den sogar auch nur mit 1 Chiplet betrieben, es kommen einstelligen Unterschied im Durchschnitt, mit 2 Abweichungen von bis zu 2x FPS raus. Allerdings bewegen wir uns dort in einem Bereich von ca. 300 FPS, so das man da in der Realität nix von merken dürfte, da es natürlich 720p ist. Je höher die Auflösung, desto geringer die Auswirkung die die fehlenden Kerne zur Zeit haben.

Auch wenn viele es nicht gern hören, der 7900x3D war im Index an 4 Stelle nach 7950x3D, 13900ks, 13900k. Er hällt in meinen Augen mit allen Hig End CPUs gut mit, und ist, zum entsprechenden Preis in meinen Augen keine so schlechte Alternative, sofern der 7800x3D nicht oder nur zu Mondpreisen verfügbar ist.

Somit sollte es eigentlich, wenn man nicht gerade eine 4090 betreiben will kein CPU Bottleneck geben.

Lies CB den Thread zum 7900x3D dort habe ich alles genau beschrieben. (änlicher Nickname).

Um es deutlich zu sagen, der 7900 nutzt genau wie der 7950 auch nur das "x3D" Chiplet, das andere legt er genauso schlafen. (also dein Vergleich 6 zu 8 Kernen) Somit sollte deine Frage beantwortet sein. Es macht real kaum einen Unterschied zum jetzigen Zeitpunkt, wenn ich nach den Tests gehe.

Grüsse.

Zuletzt bearbeitet:

Nathenhale

Volt-Modder(in)

liegt aber nicht an den Kernen sondern daran das CDPR SMT auf AMD 8 kernen nicht zum laufen bringt. Warum keine ahnung.Wenn man mit der Kiste nur spielt ist es auf absehbare Zeit ein guter Deal.

Kann sich natürlich auch nach 2 Jahren als Irrtum herausstellen und ein 13700K/13900K zieht aufgrund der Kerne vorbei.

In Cyberpunk inkl. RT sind es schon 20 bis 30% zwischen 8 und 16 Kernen.

Beuteutet es gibt bis auf ein Parr wenige Spiele nichts im moment wo mehr als 8 kerne nützlich sind.

Und selbst dann hätte der 13700k und 13900k auch nur 8 kerne die E cores müssen erstmal eingebunden werden. Und das dauert noch im moment sind Intel CPUS mit abgeschalten E cores in Games sogar schneller.

JahJah192

PC-Selbstbauer(in)

na so wären es dann minimum dennoch 2+ Jahre, also noch mind. 1 Gen an CPUs.bis 2025 sind 5 Jahre? der TR4 wurde trotz "long-term support" mit der nächsten Generation beerdigt

AMD sagt min. bis 2025 und weiter

AMD plans to support the new AM5 socket through 2025 and beyond

Which coincides nicely with the news that the Zen 5 design is on track for release in 2024.

RyzA

PCGH-Community-Veteran(in)

Limitiert dein 5800X3D irgendwo? Oder warum möchtest du eine noch schnellere CPU?7800X3D vs. 5800X3D... das ist das Einzige, was mich interessiert. Und da müssten dann schon mehr als 20% Leistungszuwachs rumkommen, um die 1000+ Euro für einen Plattformwechsel zu rechtfertigen.

facehugger

Trockeneisprofi (m/w)

Laut Hersteller wurde schon "manches" versprochen Aber das Warten auf DIE GAMING-CPU und aussagekräftige Benches

Aber das Warten auf DIE GAMING-CPU und aussagekräftige Benches

(Prohost@PCGH_Dave ) is ja bald vorbei...

) is ja bald vorbei...

Gruß

Aber das Warten auf DIE GAMING-CPU und aussagekräftige Benches

Aber das Warten auf DIE GAMING-CPU und aussagekräftige Benches(Prohost@PCGH_Dave

) is ja bald vorbei...

) is ja bald vorbei...Gruß

OField

Software-Overclocker(in)

Vielleicht Weil der 7950 auf einem CDD höher taktet und in manchen Fällen Takt wichtiger ist als Cache?"Bisschen Schade, dass er gerade in Spielen Federn lässt, in den schon der 7950x3d schlechter als der 13900k war. Speziell Cyberpunk."

Warum sollte er sich da so dermassen anders verhalten? Ist dir klar was ein 7950X3D ist, und wie er in Spielen arbeitet?

Es sind einfach 2 zusammengepappte 8 Kerner, und ein CCD wird in Games einfach abgeschalten, solange 16 Threads ausreichen, und zwar das ohne den Zusatzcache.

Grüsse.

Darum gings doch gerade, lies doch was er schreibt, er beschwert sich, das der 8 Kerner schlechter läuft in Spielen in denen der Grosse auch schlecht läuft, und ich bat ihn darum mir zu erklären, wie eine CPU die grundsätzlich genauso aufgebaut ist, und voraussichtlich weniger Takt hat, dann da ein anders Ergebnis bringen soll?

Sag mal hast du überhaupt gelesen / verstanden was ich schrieb ich sage doch nix anderes als du.........

Der grosse schaltet das TAKT höhere Chiplet aus wenn man spielt........so ist die Software zur Zeit eingestellt laut allen Tests.... hier wurde doch sogar von einem Bug berichtet, der auch bei den normalen 7950x das 1 Chiplet deaktivierte.........Also muss das wohl standartmässig so eingestellt sein.....Ist doch für AMD auch die einfachere Variante, anstatt eine echte Withelist zu führen.

Muss man halt selber testen und Prozesslasso nutzen, für maximale Performance.

Sag mal hast du überhaupt gelesen / verstanden was ich schrieb ich sage doch nix anderes als du.........

Der grosse schaltet das TAKT höhere Chiplet aus wenn man spielt........so ist die Software zur Zeit eingestellt laut allen Tests.... hier wurde doch sogar von einem Bug berichtet, der auch bei den normalen 7950x das 1 Chiplet deaktivierte.........Also muss das wohl standartmässig so eingestellt sein.....Ist doch für AMD auch die einfachere Variante, anstatt eine echte Withelist zu führen.

Muss man halt selber testen und Prozesslasso nutzen, für maximale Performance.

Nathenhale

Volt-Modder(in)

ja, aber in Cyberpunk liegt es an Fehlenden SMT für amd 8 Kerner.Vielleicht Weil der 7950 auf einem CDD höher taktet und in manchen Fällen Takt wichtiger ist als Cache?

Hübie

Software-Overclocker(in)

Ich frage mich, ob der 7800X3D dann ein CCD aktiv hat oder ob es auch welche mit zwei gibt, wo zwei oder vier Kerne dann keinen zusätzlichen Cache haben. Theoretisch wäre es ja möglich, um die Ausbeute zu maximieren.

Der 7950X3D hat weiterhin den Vorteil die Grundlast, abseits des Spiels, auf die non3D Kerne zu verteilen. Das könnten schon diese ~5% sein...

Der 7950X3D hat weiterhin den Vorteil die Grundlast, abseits des Spiels, auf die non3D Kerne zu verteilen. Das könnten schon diese ~5% sein...

Nathenhale

Volt-Modder(in)

Nein, weil das Performance Technisch große Probleme machen würde . Man könnte maximal einen 7300X3d machen da wäre der Cache aber fast so teuer wie der Core selbst lohnt sich also nicht.Ich frage mich, ob der 7800X3D dann ein CCD aktiv hat oder ob es auch welche mit zwei gibt, wo zwei oder vier Kerne dann keinen zusätzlichen Cache haben. Theoretisch wäre es ja möglich, um die Ausbeute zu maximieren.

Der 7950X3D hat weiterhin den Vorteil die Grundlast, abseits des Spiels, auf die non3D Kerne zu verteilen. Das könnten schon diese ~5% sein...

Was noch kommen könnte ist 7600x3d. Aber auch der wäre im Produkt Stack etwas schwer unterzubringen

Mottekus

Software-Overclocker(in)

Wobei ich es sehr interessant fände, wo dieser landen würde. Sry ich bin da nicht so gut im ableitenWas noch kommen könnte ist 7600x3d. Aber auch der wäre im Produkt Stack etwas schwer unterzubringen

Ändert sich dass aufgrund der Umstellung der Uhren? Oder ist das unabhängig davon immer 15 Uhr?Ja, aber der Test soll schon eute um 15 Uhr kommen.

blautemple

Kokü-Junkie (m/w)

In den USA gibt es auch eine Zeitumstellung. Der Release erfolgt, wie üblich, um 9AM EST. Das entspricht aktuell dann 15 Uhr in Deutschland.Ändert sich dass aufgrund der Umstellung der Uhren? Oder ist das unabhängig davon immer 15 Uhr?

Ähnliche Themen

- Antworten

- 5

- Aufrufe

- 1K

- Antworten

- 19

- Aufrufe

- 1K

- Antworten

- 28

- Aufrufe

- 2K

- Antworten

- 49

- Aufrufe

- 2K

- Antworten

- 54

- Aufrufe

- 3K