Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Special Nvidia Geforce RTX 4070 im XXL-Test: Der neue Effizienzmeister

- Ersteller PCGH-Redaktion

- Erstellt am

Hannesjooo

BIOS-Overclocker(in)

Meine hatte sich fast 220 Watt in Hogwarts Legacy gegönnt, war aber feinifein, Die Tuf hat Super gekühlt undIch denke das trifft auf manche, aber nicht alle Nutzer zu. Viele haben nur ein Problem damit 600€ und mehr für mittlere bis hohe Einstellungen zu zahlen.

Meine RTX 3060 12 GB läuft mittlerweile bei 0,825 V @1710 MHz zwischen 95 und 110 Watt Boardpower nach Anzeige. Mal schauen was noch so kommt...

Größter Nachteil der 7900 XT ist der noch immer teilweise vorhandene hohe Verbrauch im Idle und bei Video, vor allem im Zusammenhang mit mehreren Bildschirmen.

macht auch bei 2440 MHz net schlapp. Ich würde mir auch nie eine dual Lüfter Karte einbauen.

Hab genug Platz ?.... Aber jedem das seine.

Die Tuf hat so in etwa die Leistung der 2080 allerdings mit dem Vorteil von 12 GB Speicher.

Langt bis zum Release der neuen Intel Karten.

Die "4070" wäre eine schöne 4060 geworden, aber so wirds nichts mit der Nachbarin.

Mindestens 250 Tacken zu teuer.

Das wäre dann aber die erste "Super", die besser ist als 'ne Ti.Einfach bis zum Herbst warten. Dann kommt eine rtx 4070 Super mit 14/16GB Speicher

Nvidia müsste dafür abgewrackte AD103-Chips verwenden. Wenn die Ausbeute (Yield) nicht gut ist, könnte man das machen, dazu liest man aber nichts -> sehr unwahrscheinliches Szenario.

Nvidia müsste dafür abgewrackte AD103-Chips verwenden. Wenn die Ausbeute (Yield) nicht gut ist, könnte man das machen, dazu liest man aber nichts -> sehr unwahrscheinliches Szenario.MfG

Raff

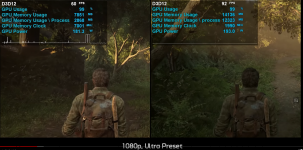

Vielleicht solltet ihr mal hinterfragen warum sich die RTX 3070 nicht mal ihren vollen VRam reservieren darf und warum nur ~2.9GB VRam in benutzung sind. Das ist genauso Müll wie die 14/12GB der RX 6800.Man müsste Dir das Hardware Unboxed Video über VRAM Verbrauch um die Ohren hauen,

normalerweise sieht das bei einer 8GB Karte eher so aus wenns voll wird.

Eine RTX 3060 auf dem Level einer RTX 2080...glaube ich kaum.Die Tuf hat so in etwa die Leistung der 2080

owned139

BIOS-Overclocker(in)

Ich verstehe diese VRAM Diskussion nicht.

Die 4070 ist kein Flaggschiff, also muss ich bei der Grafik Abstriche machen. Das war schon immer so und ist nicht neu.

Woher kommt der Anspruch alles auf Ultra spielen zu wollen?

Bei AMD geht das auch nicht! Da kann man vielleicht die Texturen um einen Step erhöhen, aber muss andere settings dafür minimieren.

Die 4070 ist kein Flaggschiff, also muss ich bei der Grafik Abstriche machen. Das war schon immer so und ist nicht neu.

Woher kommt der Anspruch alles auf Ultra spielen zu wollen?

Bei AMD geht das auch nicht! Da kann man vielleicht die Texturen um einen Step erhöhen, aber muss andere settings dafür minimieren.

Hannesjooo

BIOS-Overclocker(in)

Mit OC kommt man an eine einfache 2080. Und in Kombination 12 GB sinnvoll ausgenutzt und dem OCEine RTX 3060 auf dem Level einer RTX 2080...glaube ich kaum.

Ist man schneller als jede 8 oder 10 GB Karte in den letzten AAA spielen, was traurig ist für Leute die so viel

Geld ausgegeben haben und jetzt in 1080p die Details runter schrauben müssen.

Die tun mir fast etwas leid.

Nvidia hätte einen richtige Bombe platzen lassen und diese Karte als 4060 platzieren können. Für 449€

Wäre dies sicher ein Marketing Oberhammer gewesen, wollten sie nicht, dann will ich eben auch nicht.

So Long Boys, Intel wird immer besser mit der Arc...

Wenn Nvidia denkt so mich zu überzeugen sag ich nö.

@owned139 Nvidia bewirbt die 4070 aber so....

Nö...eine theoretische RTX 3080 muss keinenfalls auf 1080p runter. Die liefert in 1440p zB in dem sooo VRam fressendem Game TLOU (angeblich 14GB 1080P) immer noch gute Performance bei guter Optik ab.Ist man schneller als jede 8 oder 10 GB Karte in den letzten AAA spielen, was traurig ist für Leute die so viel

Geld ausgegeben haben und jetzt in 1080p die Details runter schrauben müssen.

Mal raus aus dem muffigen Keller und nachgeschaut was die Gestalten im Garten so treiben

Ich glaube, dass Du mit deiner 12GB VRam RTX 3060 nicht mal das 1440p Bild mit 8GB erreichst...VRam ist nicht alles.

Auf low schauts halt

aus.

aus.Und so schaut es aus, wenn die 12GB nicht nur an einemTrabbi hängen..

Zuletzt bearbeitet:

seahawk

Lötkolbengott/-göttin

Der 104er Chip ging schon lange nicht als 60er Karte durch.

Man muss bei der 40er Serie sehen, dass NV bei AD102 gnadenlos das Machbare ausgenutzt hat.

Man ging von 628mm² (GA102) zu 604mm² (AD102) - man hat also den Vorteil des neuen Prozesses komplett ausgenutzt. Man ging von 28 Milliarden Transistoren auf 76 Milliarden. Das ist ein Sprung den man so lange nicht gesehen hat.

Typischer wäre der Sprung von GA102 zur AD103 mit 46 Milliarden.

Aber auch bei den 104er Chips kann man mit einem Sprung von 17,4 auf 35,8 nicht meckern. Das ist deutlich mehr als der Sprung von TU104 zu GA104 (13,6 -> 17,4)

Ich bin immer mehr der Überzeugung, dass NV sich den Shitstorm primär dadurch angetan hat, weil die 4090 als erste Karte kam und zu billig war.

Hätte man so gelauncht:

1. 4080ti - Vollausbau GA103 - 1499$

2. 4080 - wie bekannt - 1199$

3. 4070ti - wie bekannt

4. 4070 - wie bekannt

5. 4090 - wie bekannt als Titan für 1999$

6. Titan X - Vollausbau GA102 - 2599$

der Shitstorm wäre kleiner.

Man muss bei der 40er Serie sehen, dass NV bei AD102 gnadenlos das Machbare ausgenutzt hat.

Man ging von 628mm² (GA102) zu 604mm² (AD102) - man hat also den Vorteil des neuen Prozesses komplett ausgenutzt. Man ging von 28 Milliarden Transistoren auf 76 Milliarden. Das ist ein Sprung den man so lange nicht gesehen hat.

Typischer wäre der Sprung von GA102 zur AD103 mit 46 Milliarden.

Aber auch bei den 104er Chips kann man mit einem Sprung von 17,4 auf 35,8 nicht meckern. Das ist deutlich mehr als der Sprung von TU104 zu GA104 (13,6 -> 17,4)

Ich bin immer mehr der Überzeugung, dass NV sich den Shitstorm primär dadurch angetan hat, weil die 4090 als erste Karte kam und zu billig war.

Hätte man so gelauncht:

1. 4080ti - Vollausbau GA103 - 1499$

2. 4080 - wie bekannt - 1199$

3. 4070ti - wie bekannt

4. 4070 - wie bekannt

5. 4090 - wie bekannt als Titan für 1999$

6. Titan X - Vollausbau GA102 - 2599$

der Shitstorm wäre kleiner.

B

bulli007

Guest

Sorry aber bei Jährlichen Stromkosten, die bei einen Normalzocker von GPU zu GPU bei ca. 30€ unterschied liegen und das bei System kosten die bis zu 2000€ und mehr betragen, ist so eine Bewertung einfach nur lächerlich.

Mag sein das es Leute gibt die 4 Stunden und mehr am Tag zocken, aber das wird aber wohl eher die aller kleinste Gruppe hier sein und damit auch die Bewertung unwichtig wie auch der Titel "Effizienzmeister".

Mag sein das es Leute gibt die 4 Stunden und mehr am Tag zocken, aber das wird aber wohl eher die aller kleinste Gruppe hier sein und damit auch die Bewertung unwichtig wie auch der Titel "Effizienzmeister".

JoM79

Trockeneisprofi (m/w)

Ahja deine 12GB 3060 ist also schneller als zB ne 3080 10GB.Mit OC kommt man an eine einfache 2080. Und in Kombination 12 GB sinnvoll ausgenutzt und dem OC

Ist man schneller als jede 8 oder 10 GB Karte in den letzten AAA spielen, was traurig ist für Leute die so viel

Geld ausgegeben haben und jetzt in 1080p die Details runter schrauben müssen.

Die tun mir fast etwas leid.

Eher nein.

Khaos-Thanathan

Software-Overclocker(in)

Das ist - mit Verlaub - Bullshit. Die Rohleistung einer 4070 würde durchaus für deutlich mehr reichen - der limitierende Faktor in vielen neuen Spielen ist allerdings und so ziemlich ausschließlich der VRAM. Nvidia hat schlicht und ergreifend den Konsolengenerationswechsel verschlafen - man möchte (aufgrund Upselling) meinen: bewusst. Der Sprung von PS4/Xbox One auf PS5/Xbox Series X brachte eine Verdoppelung des Speichers von 8 GB auf 16 GB mit sich - mit entsprechenden Folgen für die Spieleentwicklung. Die VRAM-Diskussion ist mehr als berechtigt.Ich verstehe diese VRAM Diskussion nicht.

Die 4070 ist kein Flaggschiff, also muss ich bei der Grafik Abstriche machen. Das war schon immer so und ist nicht neu.

Woher kommt der Anspruch alles auf Ultra spielen zu wollen?

Bei AMD geht das auch nicht! Da kann man vielleicht die Texturen um einen Step erhöhen, aber muss andere settings dafür minimieren.

owned139

BIOS-Overclocker(in)

Dann stell halt nur auf high, anstatt Ultra. Wo ist das Problem?Das ist - mit Verlaub - Bullshit. Die Rohleistung einer 4070 würde durchaus für deutlich mehr reichen - der limitierende Faktor in vielen neuen Spielen ist allerdings und so ziemlich ausschließlich der VRAM.

Optisch ist der Unterschied sowieso nur mit der Lupe zu erkennen.

Das ist auch noch so ein Ding. Hier wird jedesmal darüber diskutiert, wie wenig Ray Tracing optisch angeblich bringt bzw. dass es keinen Unterschied macht aber Ultra Texturen müssen sein, weils sonst matschig ist

Hannesjooo

BIOS-Overclocker(in)

In 5 Spielen schon Jetzt.Ahja deine 12GB 3060 ist also schneller als zB ne 3080 10GB.

Eher nein.

Max setting 1080/1440p +Max RT

HoLe, FC6, HL2, RE4, Portal, kommen noch viele weitere wo den 10 Gigabytechen die

Luft ausgehen wird...

S

sonny1606

Guest

Ganz einfach weil wir Gamer für 650€ im Jahr 2023 ein min 16gb vram erwarten in der Mittelklasse erwarten ider mehr. Klar reichen dieses Jahr die 12 gb noch aus, es gibt aber Titel die sich 10-12 nehmen. Ich hab auch einen PC mit 32gb auch wenn noch 16 ausreichen. Ram+vram will ich einfach etwas Reserven und nicht die Angst das nächste AAA im den nächsten Monaten plötzlich >12gb will.Ich verstehe diese VRAM Diskussion nicht.

Die 4070 ist kein Flaggschiff, also muss ich bei der Grafik Abstriche machen. Das war schon immer so und ist nicht neu.

Woher kommt der Anspruch alles auf Ultra spielen zu wollen?

Bei AMD geht das auch nicht! Da kann man vielleicht die Texturen um einen Step erhöhen, aber muss andere settings dafür minimieren.

G

Gast1684876202

Guest

und in fünf Jahren, auf niedrig? weil Nvidia zu geizig beim VRAM war (bei 600€+)Dann stell halt nur auf high, anstatt Ultra. Wo ist das Problem?

Thomas5010

Software-Overclocker(in)

Immerhin kannst du mithilfe der Einstellungen den knappen VRAM Speicher entgehen.und in fünf Jahren, auf niedrig? weil Nvidia zu geizig beim VRAM war (bei 600€+)

DLSS mit Frame Generation fehlen dagegen bei AMD unwiederbringlich.

Eine Grafikkarte ohne diese Features ist auch nicht mehr wirklich vorstellbar.

Knapper Speicher hin oder her.

Na klar...in fünf Jahren spielt man mit einer RTX 4070 noch auf ultra.und in fünf Jahren, auf niedrig? weil Nvidia zu geizig beim VRAM war (bei 600€+)

Auf low zu spielen, aber dafür eine Texturstufe höher...genau mein Ding.

Da kann man eigentlich schon aufhören zu lesen...für was soll eine RTX 4070 deutlich mehr reichen?Das ist - mit Verlaub - Bullshit. Die Rohleistung einer 4070 würde durchaus für deutlich mehr reichen

Zeig doch mal endlich was von deiner RTX 4080....

Falls Du wirklich eine hast....warum muss man mit der heute schon Abstriche machen...wenn schon die kleine RTX 4070 für deutlich mehr reicht.

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 178

- Aufrufe

- 9K

- Antworten

- 40

- Aufrufe

- 3K

- Antworten

- 135

- Aufrufe

- 8K

- Antworten

- 238

- Aufrufe

- 14K

- Antworten

- 3

- Aufrufe

- 523