Jetzt ist Ihre Meinung gefragt zu Intel Baseline Profile ausprobiert: Wie verhalten sich Core i9-13900K und i9-14900K?

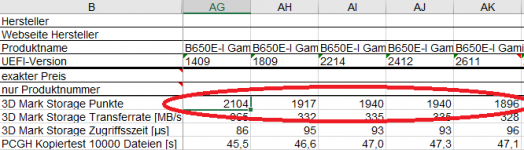

PCGH testet anhand eines Core i9-13900K und Core i9-14900K die Auswirkungen des Intel Baseline Profils auf zwei verschiedenen Mainboards: Asus Z790 Dark Hero und Gigabyte Z790 Aorus Pro X. Die spannenden Ergebnisse begleitet eine Analyse der BIOS-Versionen von Asus und schlüsselt jene Optionen auf, die zum Baseline Profil führen.

Bitte beachten Sie: Der Kommentarbereich wird gemäß der Forenregeln moderiert. Allgemeine Fragen und Kritik zu Online-Artikeln von PC Games Hardware sind im Feedback-Unterforum zu veröffentlichen und nicht im Kommentarthread zu einer News. Dort werden sie ohne Nachfragen entfernt.

Zurück zum Artikel: Intel Baseline Profile ausprobiert: Wie verhalten sich Core i9-13900K und i9-14900K?

PCGH testet anhand eines Core i9-13900K und Core i9-14900K die Auswirkungen des Intel Baseline Profils auf zwei verschiedenen Mainboards: Asus Z790 Dark Hero und Gigabyte Z790 Aorus Pro X. Die spannenden Ergebnisse begleitet eine Analyse der BIOS-Versionen von Asus und schlüsselt jene Optionen auf, die zum Baseline Profil führen.

Bitte beachten Sie: Der Kommentarbereich wird gemäß der Forenregeln moderiert. Allgemeine Fragen und Kritik zu Online-Artikeln von PC Games Hardware sind im Feedback-Unterforum zu veröffentlichen und nicht im Kommentarthread zu einer News. Dort werden sie ohne Nachfragen entfernt.

Zurück zum Artikel: Intel Baseline Profile ausprobiert: Wie verhalten sich Core i9-13900K und i9-14900K?

.gif)

.gif) ).

).

..das wird nur durch das Temp-Limit gebremst aktuell. Stabil sind aber alle 3 CPUs

..das wird nur durch das Temp-Limit gebremst aktuell. Stabil sind aber alle 3 CPUs