troppa

Software-Overclocker(in)

Schauen wir mal lieber erst wie der Scheduler in Win 11 sich mit dem Thread Director in Alder Lake verstehen wird... Wenn evtl. Kinderkrankheiten ausgemerzt sind könnte sich so ein 12900K auch in der Anwendungsleistung mit nem 5900X anlegen...

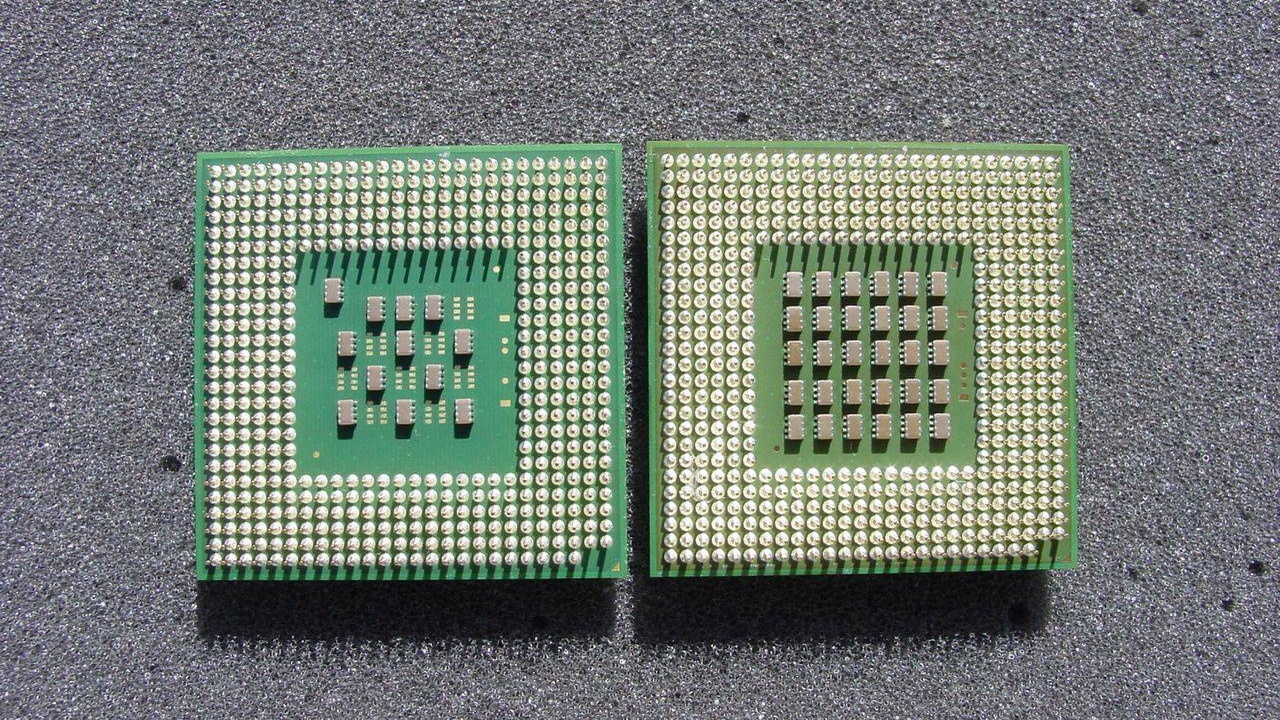

Ich persönlich freu mich auf Alder Lake und Sapphire Rapids. Denke aber nicht, dass Intel direkt die Leistungskrone komplett an sich reißt. Was die Spieleleistung angeht: Sicherlich, aber bei Anwendungsleistung wird AMD wahrscheinlich nochmal mit Zen 4 noch die Nase ein wenig vorne haben. Vor Allem, wenn die Gerüchte von nem Mainstream 24 Kerner und Server 96 Kerner stimmen sollten... Und wer weiß wie Zen 5 mit dem gleichen Konzept von Alder Lake performen wird... Der Leistungskrieg ist definitiv noch nicht entschieden..

In der Zwischenzeit: Endlich mal neues Silizium mit neuer Fertigungstechnik von Intel und dann noch gleich mit dem neuem Ansatz. Da würde ich gerne mal wieder Hand an nen Intelprozi legen. Nach gefühlt 6 Jahren Skylake und 2 Jahren Intel Abstinenz ...

...

Ja, schon klar, ARM hat big.LITTLE schon lange, aber dass hier wird imho ehr so big.MIDDLE. Quasi en 11900K mit nem 6700T on Top. Und ja ich weiß, Rocket Lake ist genau genommen nicht mehr Skylake...

Der einzige Wermutstropfen bei Sapphire Rapids ist, dass es keine volle CXL 1.1 Unterstützung gibt, aber naja...

So bleibt Resizable BAR also wohl noch ein wenig von Bedeutung... Und alle scheinen eh auf CXL 2.0 zuwarten.

Der eine PCIe 5.0 x16 Slot auf Z690 holt mich dagegen nicht hinter Ofen hervor. Sicher nice to have, aber es gibt noch keine Grafikkarte, die PCIe 4.0 ausreitzt und ich glaube nicht, dass RTX 4000 bzw. RDNA3 das volle Potential von PCIe 5.0 nutzen werden und dass jemand da per Adapter ne 30 TB E3.L SSD reinstöpselt... (Ne Videoidee für Linus?!)

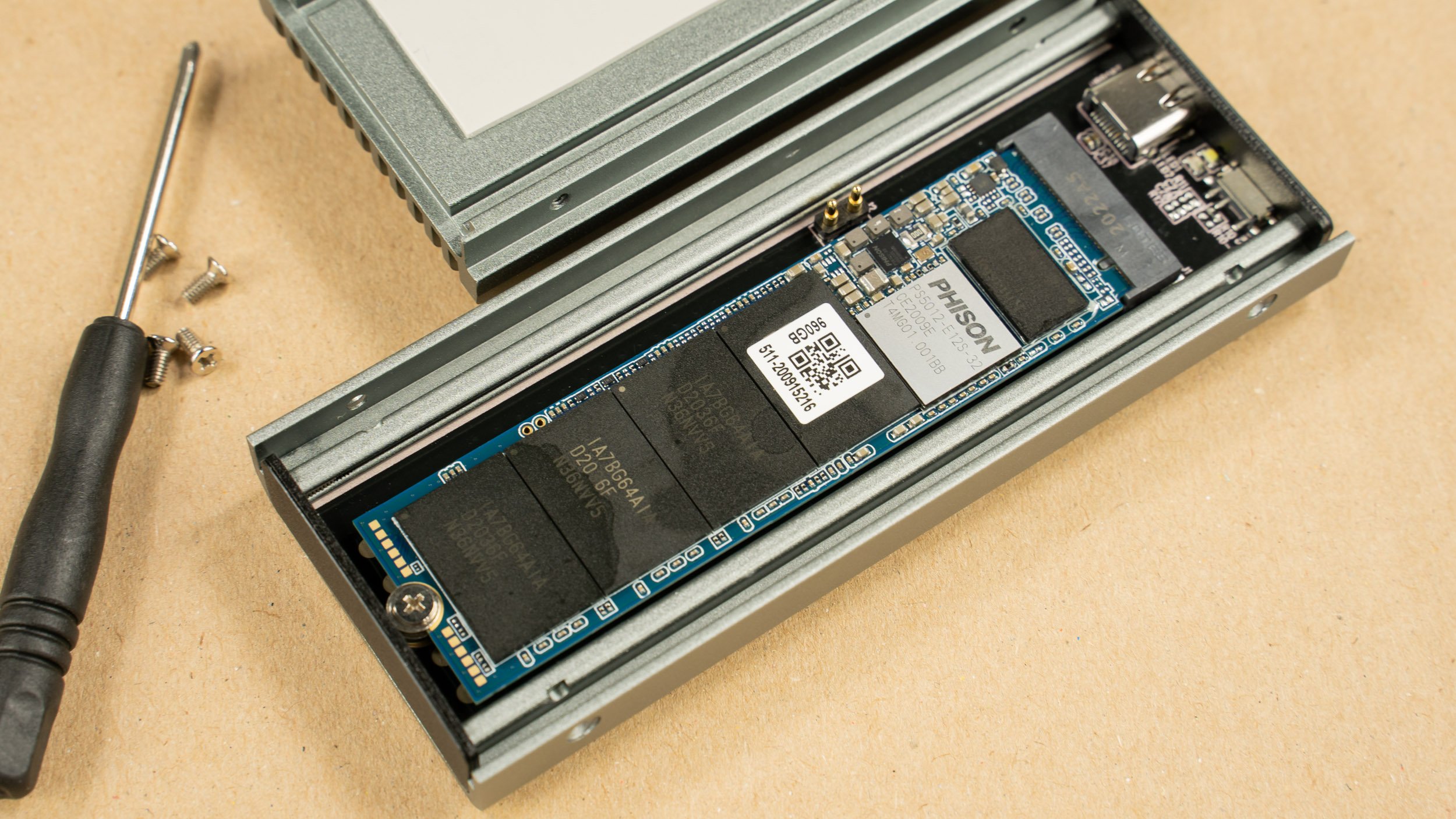

Ja genau, die M.2 SSD an der CPU und alle anderen Slots vom PCH werden PCIe 4.0 bleiben.

Edit: Und ja, endlich werden Nerds wieder gebraucht! Erklär mal nem Normalo, dass der 6+0+32 Prozi schneller ist als 2+4+96 wird bestimmt lustig...

Ich persönlich freu mich auf Alder Lake und Sapphire Rapids. Denke aber nicht, dass Intel direkt die Leistungskrone komplett an sich reißt. Was die Spieleleistung angeht: Sicherlich, aber bei Anwendungsleistung wird AMD wahrscheinlich nochmal mit Zen 4 noch die Nase ein wenig vorne haben. Vor Allem, wenn die Gerüchte von nem Mainstream 24 Kerner und Server 96 Kerner stimmen sollten... Und wer weiß wie Zen 5 mit dem gleichen Konzept von Alder Lake performen wird... Der Leistungskrieg ist definitiv noch nicht entschieden..

In der Zwischenzeit: Endlich mal neues Silizium mit neuer Fertigungstechnik von Intel und dann noch gleich mit dem neuem Ansatz. Da würde ich gerne mal wieder Hand an nen Intelprozi legen. Nach gefühlt 6 Jahren Skylake und 2 Jahren Intel Abstinenz

...

...Ja, schon klar, ARM hat big.LITTLE schon lange, aber dass hier wird imho ehr so big.MIDDLE. Quasi en 11900K mit nem 6700T on Top. Und ja ich weiß, Rocket Lake ist genau genommen nicht mehr Skylake...

Der einzige Wermutstropfen bei Sapphire Rapids ist, dass es keine volle CXL 1.1 Unterstützung gibt, aber naja...

So bleibt Resizable BAR also wohl noch ein wenig von Bedeutung... Und alle scheinen eh auf CXL 2.0 zuwarten.

Der eine PCIe 5.0 x16 Slot auf Z690 holt mich dagegen nicht hinter Ofen hervor. Sicher nice to have, aber es gibt noch keine Grafikkarte, die PCIe 4.0 ausreitzt und ich glaube nicht, dass RTX 4000 bzw. RDNA3 das volle Potential von PCIe 5.0 nutzen werden und dass jemand da per Adapter ne 30 TB E3.L SSD reinstöpselt... (Ne Videoidee für Linus?!)

Ja genau, die M.2 SSD an der CPU und alle anderen Slots vom PCH werden PCIe 4.0 bleiben.

Edit: Und ja, endlich werden Nerds wieder gebraucht! Erklär mal nem Normalo, dass der 6+0+32 Prozi schneller ist als 2+4+96 wird bestimmt lustig...

Zuletzt bearbeitet:

Ich hoffe, dass der 3700x auch so wenigstens 7-8 Jahre drin bleiben kann. Aber vermutlich bleibt AMD bei dem Tempo und haut sicherlich irgendwann die nächsten Kracher raus. Für uns Kunden ist es doch hervorragend.

Ich hoffe, dass der 3700x auch so wenigstens 7-8 Jahre drin bleiben kann. Aber vermutlich bleibt AMD bei dem Tempo und haut sicherlich irgendwann die nächsten Kracher raus. Für uns Kunden ist es doch hervorragend.

)

)