derneuemann

Volt-Modder(in)

Und die Spiele, bei denen es miese frametimes bei AMD gibt? Sind ja eher um die Hälfte der spiele.Was soll es denn sonst sein?

Ist ja schließlich nicht das 1. Mal so.

Mal bei AMD, mal bei Nvidia schlechtere frametimes...

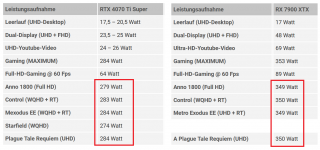

Komisch das andere Tests die 4070ti s stärker bei den min Fps, bzw. Lows sehen.Ich vermute einfach mal, das die 4070TiS auch wg. der fehlenden Bandbreite so schlechte minFps hat.

(dagegen kann sich sogar die XT ganz gut behaupten, ganz zu schweigen von der XTX, die Welten besser

= smoother läuft fürs gleiche Geld und da hilft der TiS auch nicht die Farbkompression und verbesserte Cacherei,

... bei den 7900ern kommt sogar als Handicap ca. 10% höhere Latenz durch MCD obendrauf)

Nvidia GeForce RTX 4070 Ti Super im Test: Taktraten, Performance-Ratings in FHD, WQHD und UHD

GeForce RTX 4070 Ti Super im Test: Taktraten, Performance-Ratings in FHD, WQHD und UHD / GPU-Taktraten unter Last

Siehe maximale Last 4k mit RT gemischte benchmarks.

Average ist die 4070ti s 12% vor der xtx und 15% vor der xtx bei den lows.

Auch hier

Geforce RTX 4070 Ti Super im Test: Warum nicht gleich so, Nvidia?

Raytracing-Benchmarks & Leistungsindex

Einfach bei den benchs mit RT schauen, da ist der frametime- Vorteil genauso oft auf Seiten der 4070ti s , auch gegenüber der xtx.

Zuletzt bearbeitet:

)

)

(Natürlich überspitzt von mir)

(Natürlich überspitzt von mir)

.gif)