Thomas5010

Software-Overclocker(in)

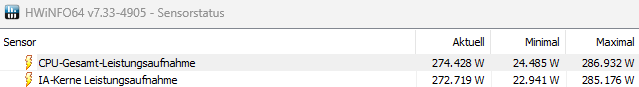

Was vermutlich am Kühler liegt.In der Firma habe ich nun jetzt neu einen 13600K bekommen.

Mein Fresse, ist der schlecht!

Bei meinem 2700K ist der Lüfter nie merklich angesprungen, wenn der bei einfacher Arbeit Teillast hatte.

Der 13600K springt sofort auf Turboturbine, wenn der einmal in der Stunde mal 30 Sekunden was berechnen soll.

Jetzt weiß jeder, ob ich arbeite, oder nicht. Daher von mir: keine Empfehlung. lol

Ich dulde keine Kritik am 13600K. Die CPU ist über allem erhaben. Gut, ich habe vielleicht etwas übertrieben mit dem Begriff "Wunderwerk der Technik" aber innerhalb der CPU Entwicklung ist der 13600K ein famoses Stück Technik mit Kultstatus.

Eine CPU für die Ewigkeit. Ich frage mich, ob Menschen wirklich solch eine Technologie entwickeln können? Ich vermute einen Ursprung im Bereich der Präastronautik.

.

.