Jetzt ist Ihre Meinung gefragt zu Unreal Engine 5 endlich spielbar: Wie hoch sind die Systemanforderungen für die Demo zu Layers of Fear?

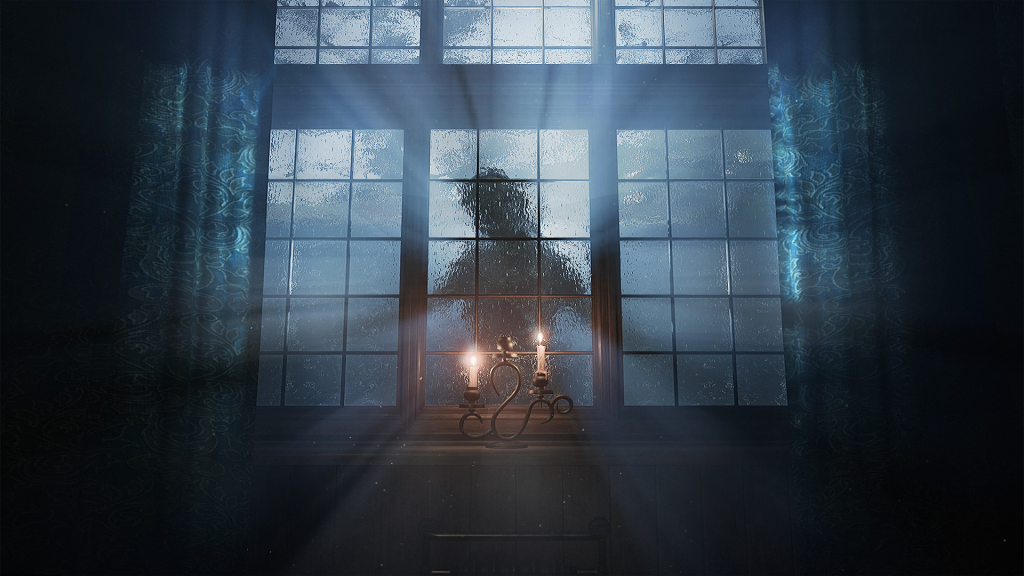

Mit Layers of Fear wird nach Fortnite das erste Unreal-Engine-5-Spiel in Form einer Demo kommende Woche spielbar sein. Wie hoch fallen die Systemanforderungen aus?

Bitte beachten Sie: Der Kommentarbereich wird gemäß der Forenregeln moderiert. Allgemeine Fragen und Kritik zu Online-Artikeln von PC Games Hardware sind im Feedback-Unterforum zu veröffentlichen und nicht im Kommentarthread zu einer News. Dort werden sie ohne Nachfragen entfernt.

Zurück zum Artikel: Unreal Engine 5 endlich spielbar: Wie hoch sind die Systemanforderungen für die Demo zu Layers of Fear?

Mit Layers of Fear wird nach Fortnite das erste Unreal-Engine-5-Spiel in Form einer Demo kommende Woche spielbar sein. Wie hoch fallen die Systemanforderungen aus?

Bitte beachten Sie: Der Kommentarbereich wird gemäß der Forenregeln moderiert. Allgemeine Fragen und Kritik zu Online-Artikeln von PC Games Hardware sind im Feedback-Unterforum zu veröffentlichen und nicht im Kommentarthread zu einer News. Dort werden sie ohne Nachfragen entfernt.

Zurück zum Artikel: Unreal Engine 5 endlich spielbar: Wie hoch sind die Systemanforderungen für die Demo zu Layers of Fear?