Weils neu ist und einer der größten Faktoren, in denen sich RDNA3 und Lovelace unterscheiden.

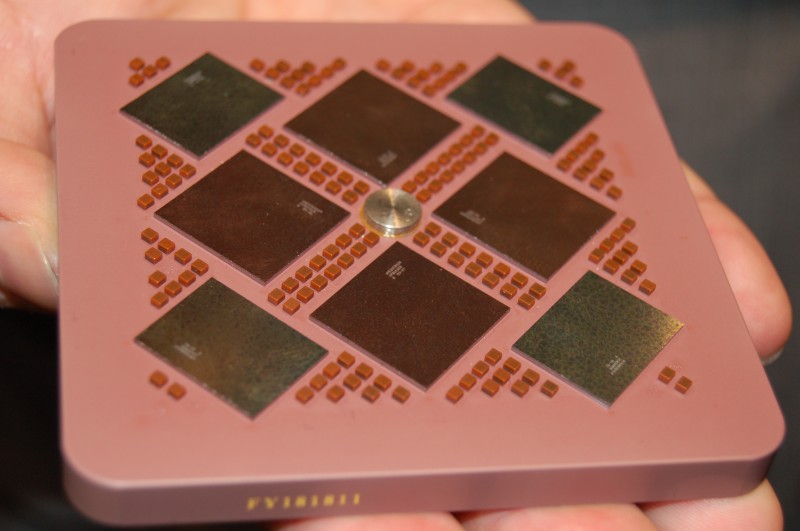

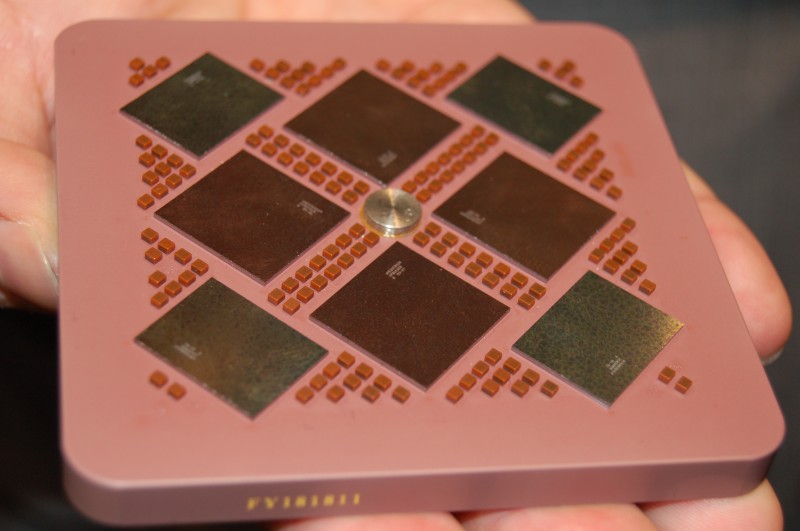

Alle vorherigen Generationen waren monolithisch (okay, es gab Grakas mit zwei GPUs, aber das ist nochmal was anderes). Wir haben jetzt das erste mal MCM vs monolithisch, deswegen hebe ich es hervor.

Ich weiß auch genau, warum du dich daran störst. Es passt dir nicht, weil es negativ für AMD ausgelegt werden kann und du selbst ein AMD System hast. Ist aber ironisch, dass du dich nur daran störst, wenn es gegen AMD geht.

Zu dem unqualifizierten Nonsense von Chatstar und co. gegen Nvidia hast du dich in diesem Thread nicht einmal geäußert. Wortwörtlich angegangen bist du nur mich und das ist pure Doppelmoral.

Sei dir versichert, dass ich kein Fanboy bin. Ich habe auch in diesem Thread bereits klar ausgedrückt, dass derzeit für mich eine Nvidia die bessere Wahl ist!

Warum ich mich genau daran störe?

Eigentlich ganz einfach, weil es eben eine absolut einseitige und am Markt so nicht realistische Sichtweise ist! Bzgl. der AMD Fraktion hier könnte ich auch ellenlange Texte verfassen, weiß gar nicht ob ich da immer alle sehe oder einige auf der IgnoreListe hab, aber ich bin da so ehrlich, wenn Nonsens so offensichtlich ist (irgendwo hab ich hier einen 3D Mark Thread gesehen (Link oder so; wo dann die 6900XT die beste sein sollte, obwohl die ersten 50 Plätze an die 3090 gehen, was soll ich da schreiben? Deine Aussage war mit einer gewissen fachlichen Nuance (MCM ineffizienter als Monolith) geschrieben, so dass viele Leser diese Aussage durchaus für plausibel halten könnten, was sie mit Rahmenbedingungen ja auch ist. Das dies der falsche Vergleich ist und die Rahmenbedingungen komplett anders sein werden (mehr Shader und weniger Takt; so zumindest im CPU Bereich recht konsequent umgesetzt) habe ich nun zum Ausdruck gebracht.

Das habe ich dann wohl nicht so gelesen, wie es gemeint war. Dann sorry!

Weils neu ist und einer der größten Faktoren, in denen sich RDNA3 und Lovelace unterscheiden.

Nochmal, weil den Satz verstehe ich falsch oder du verstehst gerade nicht was ich meine.

MCM ist grds. im Gamingbereich eine Neuerung, aber warum sollte man jetzt eine Basis vergleichen, die perfekt auf den Monolithischen Chip zugeschnitten ist? In meinen Augen machen gerade nur zwei Vergleiche wirklich Sinn (weil sie für den Markt interessant sind); man vergleicht zwei GPUs die in der Fertigung das gleiche kosten, ergo Chips die in der selben Preiskategorie antreten sollten oder man vergleich die maximale Leistung der Architektur. Zweiteres wird seit jeher für viel zu viele User als das Interessanteste Merkmal auf dem Markt angesehen, eine 3090 wird ja gemeinhin als "geile" Karte bezeichnet, da sie die meiste Leistung bietet! Der Verbrauch und die Kosten werden dabei (in meinen Augen leider) oft außer Acht gelassen. Ergo bietet der Markt eigentlich einen sinnvollen Vergleich an, maximale Leistung der Architektur!!!

Den Vergleich (der nicht unbedingt pro MCM ausfallen muss) fände ich interessant, auch wenn wie alle Vergleiche hier nur maximale Spekulation stattfindet. Aber MCM hat hier sicherlich den Vorteil, dass man skalieren könnte! So wie es aussieht wird RDNA3 aber nicht skalieren, sondern maximal 2 Chips nutzen, sowie 1 Chip GPUs anbieten. Eine Skalierung ist daher in meinen Augen nicht zu erwarten. Ein weiterer Vorteil der MCM Technik ist dennoch, dass es möglich sein wird (dank der höheren Ausbeute) zwei große Chips zu einem MegaChip zusammenzufassen, während Monolithisch ein sehr großer Chip wird. Man wird also bei dem vorliegenden MCM Design vermutlich mehr Fläche haben, womit man tendenziell mehr Shader verbauen kann, die man um die gleiche Leistung zu erreichen entsprechend niedriger takten könnte (vorausgesetzt die Voraussetzungen mm² je Shader und die Effizienz der Shader wären identisch, was ja schon nicht der Fall ist)

In der Theorie (auch hier habe ich hoffentlich mehr als einmal darauf hingewiesen, dass diese Theorie nur auf Gerüchten basiert und noch dazu mal nicht mit den PS auf der Straße zu tun haben muss), wird ein MCM Design dank mehr Shader, vermutlich in der Lage sein mehr Leistung zu erbringen, man hat mehr Shader und durch die größere Chipfläche mehr Kühlfläche und kann so vermutlich (bei gleicher Effizienz) mehr Energie umsetzen, womit man die Maximalleistung erhöhen kann.

Aber, der Nachteil von MCM und der Vorteil von monolithisch ist ja überhaupt nicht von der Hand zu weisen, der Chip ist zum einen viel einfacher, man spart sich Fläche und Verbrauch für Interposer, man hat viel geringere Latenzen und viel weniger Overhead. Auch da spricht vieles für einen Vorteil bei monolitischer Bauweise.

Der größte Vorteil wird aber in meinen Augen in der Praxisleistung liegen, denn monolitische Chips sind erprobt, die Software darauf programmiert und die Treiber sind darauf schon ausgelegt. Ein MCM Design ist in meinen Augen theoretisch überlegen, wird aber gerade zu Beginn Optimierungsarbeit bedürfen und AMD ist nicht bekannt dafür zum Start hin schon gute bis sehr gute Treiber zu haben. Meine Erwartungen (bzw. Befürchtungen) an die neue Generation, sprich Lovelace und RDNA3 wird daher sein, dass wir auf eine auf dem Papier überlegene, wahrscheinlich sogar deutlich überlegene RDNA3 Architektur stoßen werden, die bei den ersten Benchmarks dann aber katastrophal abschneidet, da weder die Software noch die Treiber vernünftig funktionieren. Zum Ende der Generation würde ich dagegen erwarten, dass AMD immer näher an Lovelace heranrücken wird und ein äußerst unangenehmer Gegner werden wird, mich würde es nicht wundern, wenn RDNA3 besser als jede Generation vorher altern würde (gerade dies war ja oft eine Stärke der AMD Karten, aber sicherlich bedingt durch deren Unfähigkeit von Beginn an gute Treiber zu bringen)

en.wikipedia.org

en.wikipedia.org

**) und du scheinst auch komplett AMDs Grund für dessen Implementation zu verpeilen, denn hier geht es im Wesentlichen um eine günstige Fertigung und weniger um zusätzliche Performance, denn die liefert der Cache nicht, sondern der soll lediglich, das herunterskalierte SI kompensieren.

**) und du scheinst auch komplett AMDs Grund für dessen Implementation zu verpeilen, denn hier geht es im Wesentlichen um eine günstige Fertigung und weniger um zusätzliche Performance, denn die liefert der Cache nicht, sondern der soll lediglich, das herunterskalierte SI kompensieren.