Gerade im Profi Segment nimmt aber Nvidias RT Fahrt auf

Nicht wirklich. Visualisierungen in der Medizin sind recht spezifisch. Nvidias RT ist da im Moment nicht viel mehr als ein Tropfen auf den heissen Stein. Visualisierungsmodelle basierend auf Raytracing gibts übrigens auch in der Medizin schon länger. Wobei dort aufgrund der vereinfachten Darstellung eher auf Raycasting zurückgegriffen wird.

Dabei muss man unterscheiden zw. dem einfachen 7nm bei TSMC und dem 7nm EUV bei Samsung.

Die Radeon VII und auch Navi sind nur mit dem einfachen 7nm gefertigt.

Als Ergänzung, TSMC hat auch noch einen besseren 7nm Prozess mit EUV, 7+nm. Der sollte dann für Produkte im nächsten Jahr genutzt werden. Wie Zen3 oder eventuell auch Navi 20.

Bei den 7nm sollte man sich eher fragen:

Radeon VII läuft bereits mit 7nm, GTX 1080 Ti ist 16nm. Ratet mal welche schneller ist und welche mehr Strom verbraucht.....

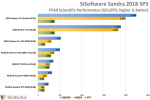

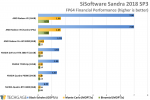

Man kann beides nicht wirklich vergleichen. Daher sollte man auch mal etwas über den Tellerrand schauen. Die Radeon VII ist halt einfach nur eine umgelabelte Profi-Karte, zwar mit besserem Feature Set, aber ohne signifikante Änderungen an der Mikroarchitektur im Vergleich zu Vega 10 und daher auch alles andere als eine optimale Lösung fürs Gaming. Zumal dort die einfache 7nm Fertigung von TSMC genutzt wurde, die zwar eine deutliche Flächeneinsparung ermöglicht, aber nicht so viel energieeffizienter ist wie man vielleicht denkt. Die Radeon VII liefert vor allem hohe SP/DP Performance für GPGPU. In solchen Disziplinen hat selbst die GTX 2080 Ti oft nicht den Hauch einer Chance, gerade bei DP:

Von nichts kommt halt auch nichts. Genau deswegen wurde ja RDNA entwickelt, eine Mikroarchitektur die nicht mehr auf GCN basiert und für Gaming optimiert wurde.

RTX ist die Hardware bzw. der Treiber der in der Lage ist DirectX 13 alias DXR auszuführen.

RTX wird von nVidia selbst als Plattform bezeichnet. Und dazu gehört nicht nur Hardware, sondern auch Software wie APIs und SDKs. Vermutlich meinte KrHome das. Und da hat er nicht ganz unrecht. Als eigenständige Software hat RTX keine grosse Zukunft. Ein grundsätzliches Problem von proprietären Lösungen, die auf den Massenmarkt abzielen, siehe AMDs Mantle. Und da Microsoft diesmal recht fix war mit einer DirectX basierten Schnittstelle für Raytracing wird es nVidia auch nicht so durchsetzen können wie CUDA, sofern sie das überhaupt vorhaben. Auch Vulkan (ehem. Mantle) wird Lösungen für Raytracing bieten bzw tut es schon.

@topic

Einige haben vergessen oder womöglich gar nicht mitbekommen, dass an Raytracing schon lange geforscht wird. AMD hatte dazu schon vor 10 Jahren Echtzeit-Rendering gezeigt, eine Mischung aus Voxel und Raytracing Technik. Intel hatte damals an einer Raytracing-Engine für CPUs gearbeitet, die ein Spiel komplett rendern konnte. Gezeigt wurde das anhand von Quake. Selbst in der Demoszene gab es immer mal wieder nette Umsetzungen, natürlich stark vereinfacht.

Damals wie auch heute sind das trotzdem nicht viel mehr als Tech-Demos. Daran ändert auch nVidias RTX nichts. Solange weiterhin auch herkömmliche Rasterizer genutzt werden müssen, bleibt es nur Stückwerk. Raytracing wird erst dann interessant, wenn 3D Szenen damit komplett gerendert werden können, logischerweise in Echtzeit mit ausreichend FPS. Davon sind wir aber noch weit entfernt. GPUs sind dafür immer noch deutlich zu schwach. Und das wird sich auch in den kommenden 2-3 Jahren nicht ändern. Daher tut AMD gut daran, hier nichts zu überstürzen. Diese Ressourcen können im Moment sinnvoller genutzt werden.

?

?

lächerlich.

lächerlich.