Locuza

Lötkolbengott/-göttin

Eine neue ISA, mit durchschnittlich 4-Cycles für Instruktionen gegenüber den aktuellen 6-Cycles und einer veränderten Cache-Struktur stellt "eigentlicht" nur Pascal + Tensor Cores dar?Weil Volta eigentlich nur Pascal + Tensor Cores ist.

Für Gaming bringt das nichts.

[...]

[...]

Von der Fertigung?

"New Streaming Multiprocessor (SM) Architecture Optimized for Deep Learning

Volta features a major new redesign of the SM processor architecture that is at the center of the GPU.

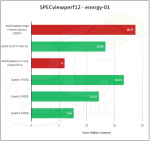

The new Volta SM is 50% more energy efficient than the previous generation Pascal design, enabling major boosts in FP32 and FP64 performance in the same power envelope.

New Tensor Cores designed specifically for deep learning deliver up to 12x higher peak TFLOPSfor training and 6x higher peak TFLOPS for inference.

With independent parallel integer and floating-point data paths, the Volta SM is also much more efficient on workloads with a mix of computation and addressing calculations.

Volta’s new independent thread scheduling capability enables finer -grain synchronization and coope ration between parallel threads.

Finally, a new combined L1 data cache and shared memory unit significantly improves performance while also simplifying programming.New Streaming Multiprocessor (SM) Architecture Optimized for Deep Learning"

https://images.nvidia.com/content/volta-architecture/pdf/Volta-Architecture-Whitepaper-v1.0.pdf

Es ergibt wenig Sinn, dass eine kostenoptimierte Node für große Effizienzsteigerungen sorgen soll.[...]

Ja, was ist daran jetzt so schwer zu verstehen?

1. Bei Vega 10 ist die DP-Leistung mit 1/16 richtig angegeben, mehr hat der Chip (höchstwahrscheinlich) nicht drauf.[...]

DP schein da bei Vega übrigens falsch angegeben zu sein!

[...]

An die CPU trotzdem nur per PCIe, nur bei POWER gibt es NVLink in der CPU.

Klarer Punkt für AMD, sie können Vega per HT an Naples anbinden!

Für einen anderen Vega-Ableger könnte AMD natürlich auch 1/2 verwenden, aber darüber gibt es keine offiziellen Informationen.

2. Stellt sich nur die Frage, wann AMD das auch wirklich tut (IF/xGMI) und anbietet.

(und das sind nur ein paar Beispiele, es gibt noch mehr. GidF!

(und das sind nur ein paar Beispiele, es gibt noch mehr. GidF!

) daherkommt...

) daherkommt...