RX480

Lötkolbengott/-göttin

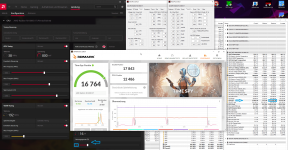

Die 6800xt lässt sich doch auch schon ganz gut UVen!? (und der Preis ist heiß!... 679€)

(Settings je nach Chip- und Vramgüte)

statt 255Wtgp halt mal 150Wtgp ausprobieren, später kann man eeh noch bei Bedarf auf 180Wtgp hochgehen

(255Wtgp=300Wtbp und 150Wtgp=178Wtbp)

als Bsp. RaceOwl vom Luxx, der allerdings sehr guten Vram+SOC hat:

(schafft net jeder Dort so sehr zu UVen, macht aber nur je ca. 2W aus, wenn man net ganz so scharf rangeht)

(Settings je nach Chip- und Vramgüte)

statt 255Wtgp halt mal 150Wtgp ausprobieren, später kann man eeh noch bei Bedarf auf 180Wtgp hochgehen

(255Wtgp=300Wtbp und 150Wtgp=178Wtbp)

als Bsp. RaceOwl vom Luxx, der allerdings sehr guten Vram+SOC hat:

(schafft net jeder Dort so sehr zu UVen, macht aber nur je ca. 2W aus, wenn man net ganz so scharf rangeht)