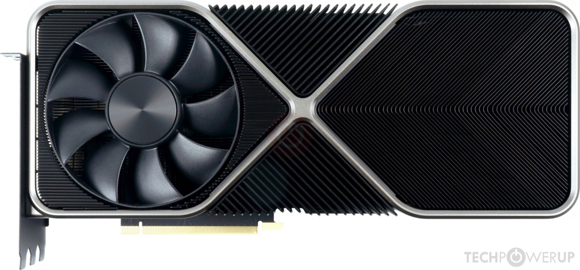

Moment, das sehe ich immer noch etwas anders, Ampere ist letzlich als Chip nicht wirklich gut. Er ist in meinen Augen hinter RDNA2 zurückgefallen (natürlich nicht dramatisch weit) und kompensiert das durch Mehrverbrauch. Die 3090 und 6900XT liegen ziemlich gleich auf. [...]

Mit dem von mir zuletzt zitierten Satz hast du deine Begründung quasi selbst ad absurdum geführt.

Noch mal zur Klarstellung. Ampere wird in einem Prozess der 10nm-Klasse gefertigt. RDNA2 verwendet einen deutlich moderneren Node der 7nm-Klasse. Samsung's Äquivalent hierzu ist deren 7LPP, wohingegen nVidia sich jedoch mit dem 8LPP (

von nVidia selbst als 8N bezeichnet) begnügt. Dass das weitere Beschränkungen auferlegt, sollte klar sein, Wenn du jetzt erklärst, dass die "

6900 XT und die 3090 so ziemlich gleich auf liegen", kannst du dir leicht selbst ausrechnen, wie das aussehen würde, wenn man das Ampere-Design unverändert auf TSMCs N7(P) transferieren würde. Entsprechend sind sie hier architektonisch mindestens gleich auf, wenn nicht gar leicht führend (

beim Raytracing und der ML-Performance stellt sich die Frage nicht einmal) und es bleibt schlicht zu vermuten, dass sie Margen-technisch den für sie optimalen Weg gewählt haben. Sie umgehen die Konkurrenzsituation bei TSMC und fertigen hier den Großteil ihrer Chips mit einem günstigeren Prozess und können aufgrund der großvolumigen Fertigungsübertragung hin zu Samsung voraussichtlich zusätzlich noch mit guten Konditionen rechnen.

Aber nicht auf Hopper Basis [...]

Nein, natürlich nicht, denn das erwuchs ja dem Kontext, den 4thVariety aufspannte.

Nimmt man es genau, ist aktuell bei nVidia mit Bezug auf Lovelace alles noch Spekulatius, da die hier viele Möglicheiten haben und sich gerüchtetechnisch noch nichts Belastbares verdichtet hat. Schlussendlich könnten die selbst mit einer geteilten Fertigung die Consumer-HighEnd-Chips bei TSMC fertigen und den Rest bei Samsung in einem moderneren aber günstigeren Node.

Was jedoch dafür spricht, dass nVidia einen modernen und aktuellen Node für die Consumer-Top-Produkte der NextGen verwenden wird ist, dass sie das schlicht nötig haben aufgrund ihrer

angeblichen Designentscheidung, die Konkurrenz in dieser Iteration weiterhin mit einem rein monolithischen Design kontern zu wollen. Sowohl von AMD als auch Intel ist bekannt, dass die mit MCMs aufwarten werden, d. h. hier kann sich nVidia nicht zusätzlich noch fertigungstechnischen Beschränkungen unterwerfen. Wie schon zuvor erklärt, wäre die einzige Einschränkung hierzu, wenn sie sich bewusst entscheiden würden, dass das kleine oberste Marktsegment dieses Mal die zusätzlichen Aufwendungen nicht wert ist und man dafür lieber eine bessere Marge mitnimmt, aber so richtig glauben kann ich daran nicht, dass nVidia hier der Konkurrenz freiwillig die Spitze, Halo-Produkte und auch die absoluten HighEnd-Profi-Produkte überlassen will. Entsprechend würde ich davon ausgehen, dass sie dennoch versuchen werden über das gesamte Spektrum hin zu konkurrieren und dafür wird am oberen Ende einiges nötig sein, so auch eine moderne Fertigung.

Bei TSMC könnten sie sich eine gute Ausgangsbasis mit etwas wie dem N5P verschaffen, bei Samsung, was auch denkbar wäre, müsste es schon als äquivalentes Gegenstück der 4LPE sein. Wenn sie sogar sehr überraschen, würden sie gar TSMCs N4 verwenden, der zu der Zeit ebenso zur Verfügung steht, aber das denke ich eher nicht, denn bisher hat nVidia hier sehr mit Bedacht auf die Marge geplant, sodass ich vermuten würde, dass man wenn es TSMC werden sollte, es beim N5P als beste Möglichkeit belassen würde.

Letzten Endes, da nVidia aber aufgrund der Konkurrenzsituation derart den Deckel draufhält, werden vermutlich noch einige Monate vergehen, bis man weitere Info-Brotkrumen zur Hand hat.

Abschließend noch der Hinweis auf vorausgegangenen Absatz, denn weniger Effizienz haben sie architektonisch anscheinend nicht, da man hier beim Vergleich Ampere gegen RDNA2 auch zu einem wesentlichen Teil 8LPP gegen N7P vergleicht.

Das ist eher Wunschdenken als Realität. Erstens hat Nvidia oft grössere Chips gebraucht, weil sie bezüglich Flächeneffizienz unterlegen waren, und nicht weil sie die leichter fertigen lassen können als AMD. Und zweitens ist Samsung bisher auch nicht unbedingt durch extrem gute Yields aufgefallen, TSMC schon eher.

Du müsstest schon richtig lesen, denn bei mir steht bspw. nirgends, dass sich größere Chips leichter fertigen lassen. nVidia hat die Ressourcen um solche großen Chips zu fertigen und kann diese sowie den Ausschuss weitaus besser absetzen, weil die den Großteil des Marktes bedienen. Um es mal in leicht verständliche, exemplarische Zahlen zu stecken: Es macht einen signifikanten Unterschied aus, ob die Entwicklungskosten (sowie anteiligen Fertigungskosten) am Ende 15 % des Umsatzes oder aber 30 % des erzielten Umsatzes ausmachen.

Das vermeitliche "Yield-Argument" sollte man eher nicht mehr aufgreifen, da es hierzu keinerlei belastbare Zahlen gibt, denn das sind Werte, die alle Hersteller möglichst unter Verschluss halten wollen und nur herauskramen, wenn es um Werbung und Marketing geht. Beispielsweise bei TSMCs 7nm-Prozessen gab es zwischenzeitlich auch diverse Meldung zu schlechten und später auch eingebrochenen Yields. Interessanterweise ist die Community hier weniger bedacht sich daran zu erinnern, voraussichtlich eher ein psychologisches Thema. Darüber hinaus warb TSMC mit einem sehr gutem Yield beim N5 (

übrigens, ebsno etwas wobei man bspw. einem Intel bei einer vergleichbaren Aussage erst mal ein "Talk is Cheap" vorwerfen würde, bei TSMC dagegen scheint jede Aussage für bare Münze genommen zu werden, erneut ein p...) Um das aber auch ins richtige Licht zu stellen, die (Werbe)Aussage von TSMC hierzu bezogen sich auf Test-Chips, typischerweise kleine Chips, die zu einem Teil aus Logik-Schaltung und zu einem anderen aus simplen SRAM-Zellen bestehen. Das hat erst mal nicht unmittelbar was mit mehreren 100 mm2 großen GPU-Chips zu tun.

Unterm Strich würde ich jedoch auch davon ausgehen, dass TSMC hier diesbezüglich etwas solidier aufgestellt ist, aber die hier und dort lesbaren Kommentare der Art "TSMC quasi 97 % Yield, Samsung bestenfalls 43 % Yield" (

absichtlich etwas überspitzt

) sind nicht belegbar und zudem auch abwegig, weil das für Samsung selbst auch unrentabel wäre, denn für den Yield steht der Hersteller ein. Wenn hier vereinbarte Vorgaben nicht eingehalten werden, würden Kunden wie nVidia schlicht Kompensationen verlangen und wenn man sich ansieht, wie viele GPUs nVidia ausstößt, müssten die ja regelrechte Unmengen an Wafern bei Samsung verbrauchen um die zu fertigen, wenn der Yield so schlecht wäre und Samsung würde dennoch kaum was verdienen, weil das zu deren Lasten ginge.

Der war gut. Der tatsächliche Grund ist, dass AMD Chiplets kann und es der nächste technologische Schritt ist. Warum hängt denn AMD Intel seit geraumer Zeit bei Servern ab? Weil sie dank Chiplets einfach mehr Performance pro Sockel liefern können. Nvidia kann eben noch keine Chiplets. Deshalb müssen sie für die kommenden Generationen primitivere MCM Designs verwenden. Und Wirtschaftlichkeit ist für beide wichtig und notwendig. Deshalb sind grosse monolithische Design auch alles andere als gut oder einfacher zu fertigen. Und deshalb wird AMD bei den grösseren Navi 3x auf Chiplets setzen. Bei den kleineren Navi 3x reicht ein monolithisches Design aus. Dank dieser Flexibilität wird man da mit 2 oder 3 Designs ein komplettes Portfolio stellen können und sogar noch abgestufter Modelle spezifizieren können. Wo aktuell 4 Designs verwendet werden. Was auch wiederum Kosten spart.

Nein "gut" war daran überhaupt nichts, nur schlicht wirtschaftlich gedacht. Was dir jedopch anscheinend nicht bewusst ist: AMD ist hier keinesfalls ein Pionier. Multi-Chip-Designs gab es schon lange vorher im Markt, selbst bei Intel. AMD hat nun zwar großflächige CPUs damit in den Markt gebracht, aber in erster Linie weil sie es mussten, weil sie ansonsten nicht die Consumer- und Server-Fertigung unter einen Hut gebracht hätten und voneinaner eigenständige Entwicklungsprojekte hätten schlicht ihre Möglichkeiten überstiegen (

bzw. ihre Wachstumskurve verringert). Ihnen mehr zugeneigte oder gar extrem wohlwollende Gesellen werden nicht müde das als "genial" etc. zu bezeichnen, faktisch war es jedoch nur ein wirtschaftliche Notwendigkeit.

Dass das MCM-Design bei AMD im CPU-Segment ganz klar seine Grenzen hat, konnte man schon lange vor Alder Lake sehen, denn die kleineren 14nm-CPUs von Intel konnten von denen konkurrenzfähig und weitaus günstiger gefertigt werden, weil in dieser Größenordnung der Yield nur eine untergeordnete Rolle spielte (

insbesondere bei einem derart ausgereiften Prozess; abgesehen davon, dass Intel auch hier ganz andere Möglichkeiten hat mit "Ausschuss" umzugehen).

Beispielsweise bis zu Zen2 konnte sich AMD architektonisch nicht nennenswert von Intel absetzen. Die Schere ging erst dann deutlich auf, wenn man den Skalierungeffekt durch TSMCs N7 hinzu nahm und CPUs mit sehr vielen Kernen betrachtete, etwas was insbesondere im Servergeschäft gefordert wird.

Was du aber auch zum Zweiten gleich missverstehst: Intel ist bzgl. Multi-Chip-Designs vermutlich AMD voraus, denn die entwickeln schon viel längern an dem Thema. Dass Intel das bisher noch nicht großflächig angewendet hat (

wobei sie das mittlerweile schon längst machen), lag eher daran, dass ihre Fertigungsprobleme hier die Zugewinne zu sehr geschmählert hätten, sodass sich die zusätzlichen Aufwendungen nicht lohnten.

Weiterhin dürftes du dich ebenso bei nVidia gar noch viel eklatanter täuschen. Selbstredend können die MCM-Designs konstruieren und werden auch daran wahrscheinlich schon länger als AMD arbeiten (

schlicht eine Frage der Ressourcen). Hopper ist ein solches Design (

und wird absehbar CDNA2 deutlich übertreffen) und ebenso wie für AMD stellt auch hier TSMC einen wesentlichen Teil der Technologie bereit. *) Mit ihren um ein Vielfaches größeren Ressourcen bzgl. der GPU-Entwicklung kannst jedoch sicherlich davon ausgehen, dass im Zweifelsfall eher nVidia die Nase KnowHow-technisch vorne haben wird, was nichts mit Wunschdenken, sondern schlicht mit wirtschaftlichem und projekttechnischem Sachverstand zu tun hat. Man wird nicht zum (und bleibt) Marktführer, indem man laufend Manpower und andere Ressourcen in die falschen Entwicklungsprojekte investiert.

*) Entsprechen noch ein möglicher Punkt der auch bei Lovelace die Möglichkeit offen lässt, dass man auch bei Samsung im 5LPE (oder gar 4LPE) fertigen könnte, denn Packaging-technisch hört man von Samsung weitaus weniger als von TSMC, d. h. wenn die sich entschlossen haben sollten bei Samsung mit der Consumer-Fertigung zu bleiben, könnte das einmal mehr dafür sprechen, dass man noch einmal ein monolithisches Design entwickelt.

Zu deinem "Kostenpunkt/sparen" ebenso der Hinweis, dass das nicht mehr als Spekulation ist. Ich könnte mir eher vorstellen, dass RDNA3 mit seinem MCM-Design für AMD mit die teuerste und aufwendigste Entwicklung sein wird, die sie bisher aufgesetzt haben bei den GPUs, weil MCM bei GPUs ein völlig anderes Thema als bei CPUs ist.

Unterm Strich einfach mal abwarten. Am Ende bin ich genau so gespannt wie du, wie das NextGen-Rennen "ausgehen" wird. Mich interessiert jedoch weitaus mehr das wirtschaftliche Szenario, sprich war es effizient, wie sehen die Margen, Umsätze und Gewinne aus, hat man hier aufs richtige Pferd gesetzt, wenn es

möglicherweise monolitisch und ebenso

möglicherweise erneut Samsung werden sollte? Wie ich schon schrieb, haben sie bzgl. Ampere mit Samsung's 8LPP vermutlich weitaus mehr Richtig als falsch gemacht, denn am Ende geht es denen weniger darum Gamern ein Lächeln ins Gesicht zu zaubern als vielmehr darum den bestmöglichen Umsatz und Gewinn zu erzielen und das schaffen sie zurzeit offensichtlich mit Leichtigkeit.

Das entbehrt jeglicher Logik. Andersrum wird ein Schuh draus, zumindest wenn wir RDNA3 und Lovelace vergleichen. Das einzige Szenario, in dem Nvidia AMD klar schlagen könnte, wenn sie ein so grosses monolithisches Design basteln, dass so stromhungrig und so teuer in der Fertigung wird, dass sie dies nur mit Mondpreisen für Unbelehrbare amortisieren können. Wobei selbst dieses Szenario für mich unrealistisch erscheint dank des Chiplet Designs von RDNA3. Selbst Intel schafft es seit Jahren bei CPUs nicht, hier was vergleichbares zu bieten. Warum sollte es ausgerechnet Nvidia schaffen, die da noch weiter hinterherhinken als Intel?

Mir scheint eher, du hast meine Aussage nicht wirklich verstanden, aber mal anders herum aufgezogen: Ich bin mir ziemlich sicher, das es mit sehr, sehr hoher Wahrscheinlichkeit kein Szenario geben wird, in dem Lovelace RDNA3 deutlich schlagen wird (

vielleicht mal Spezialfunktionalitäten außen vor gelassen). Das liegt schlicht daran, dass nVidia daran überhaupt kein Interesse hat, sondern einfach nur im Gesamten das etwas bessere Produkt abliefern muss um attraktiver für den Markt zu sein. Ein deutliches Übervorteilen würde deutlich mehr Aufwand in Forschung und Entwicklung sowie voraussichtlich auch die Fertigung erfordern und diese Aufwändungen wird man nur auf sich nehmen, wenn die einen deutlichen Mehrwert generieren. Consumer sind vielleicht bereit für die GPU mit dem längsten Balken etwas mehr zu bezahlen, aber weil der Balken vielleicht um 40 % länger ist, als beim Topprodukt der Konkurrenz, werden diese in der breiten Masse nicht bereit sein nochmal zusätzliche +40 % mehr auszugeben.

Darüber hinaus gehört es ebenso zum wirtschaftlichen Denken sein Pulver nicht unnötig zu verschießen und wenn man einige architektonische oder designtechnische Verbesserungsmöglichkeiten in der Hinterhand hat, die man aktuell noch nicht braucht, um die Konkurrenz in Schach zu halten oder die Marktposition zu zementieren, kann man sich einige davon auch noch gut für die nächste Iteration aufheben, denn auch in den kommenden Jahren sollen ja schließlich noch neue Produkte an den Mann und die Frau gebracht werden.

Als abschließende Randbemerkung: Intel ist mit (Co)EMIB, Foveros, etc. schon weiter als das was AMD zurzeit bietet (

übrigens ebenso inkl. des V-Cache). Wie schon zuvor erklärt ist das Problem die Fertigung, die jetzt erst so langsam wieder auf dem Weg in normale Fahrwasser ist.

Sapphire Rapids SP wird einen ersten Vorgeschmack bieten, jedoch immer noch durch die 10nm-Fertigung deutlichen Beschränkungen unterliegen, aber schon aufzeigen, wohin die Reise geht. (

Ergänzend vielleicht noch, dass Xe-HPC alias Ponte Vecchio deutlich über alles hinaus geht, was die Industrie inkl. TSMC bisher vorlegen konnte und das Design wird schon längst gefertig.) Vermutlich wird man im 2HJ23 einen besseren Blick auf das Thema werfen können, denn dann ziehen erneut umfangreiche fertigungs- und packaging-technische Neuerungen in Intel's Produkte ein, was sowohl AMD als auch nVidia zweifellos nicht auf die leichte Schulter nehmen werden. (

Der Einzug erfolg übrigens selbst im Consumer-Segment mit Meteor Lake, der vermutlich Zen4 bereits wieder übertreffen wird, sodass AMD einen Refresh als Konter benötigen wird, da Zen5 vermitlich nicht vor Ende(?) 2024 erscheinen wird.)

Das ist falsch. Es hat wie bei CPUs sowohl einen technologischen als auch einen wirtschaftlichen Vorteil.

Was verstehst du an "

primär" nicht? Das schließt einen technologischen Aspekt keinesfalls aus, für AMD wird aber der wirtschafliche Aspekt zweifellos der Wichtigere gewesen sein, denn ohne die Chiplet-Fertigung hätten sie den Markt überhaupt nicht in der beobachteten Art und Weise bedienen können, sodass ihr Wachstum deutlich langsamer vonstatten gegangen wäre. Und der zeitliche Faktor ist wachstumstechnisch durchaus relevant für sie, denn wären nennenswerte, derzeit von AMD belegte Marktkapazitäten vakant, könnten hier ARM-Konkurrenten tendenziell stärker wachsen.

Beispielsweise AMDs Bergamo ist explizit gegen die ARM-Konkurrenz aufgestellt worden, denn hier ist man jetzt schon deutlich unter Druck und das noch mit derzeitigen 7nm-ARM-Designs, die aber bspw. schon in diesem Jahr durch nochmals leistungsfähigere 5nm-Designs ersetzt werden, d. h. AMD wird in diesem Marktsegment schon in diesem Jahr ins Hintertreffen geraten, denn diese Konkurrenzprodukte sind zusätzlich noch deutlich günstiger als Epyc und Genoa wird zweifellos auch noch mal ein klein wenig teuerer werden, wie schon Milan zuvor. Entsprechend wird AMD versuchen es Anfang 2023 mit Bergamo zu richten. Ob ihnen das gelingen wird, bleibt abzuwarten, jedoch hat AMD hier derzeit das gleiche Glück ggü. ARM wie Intel ggü. AMD, nämlich das die Marktanteile und Fertigungskapazitäten der Konkurrenz noch gering sind und für AMD vielleicht noch zusätzlich, dass man dem Verbleib auf einer x86-kompatiblen Plattform auch noch ein wenig zusätzlich abgewinnen kann.

Da würde ich erstmal abwarten. Es gab vor Monaten Stimmen die meinten, N31 und N32 bekommen jeweils individuelle Compute Chiplets. Und das AMD in diesem Fall eben nicht den Ryzen-Weg geht (Chiplets für eine hohe Wirtschaftlichkeit) sondern um technologische Limits auszureizen.

Na das gilt sowieso, denn auch ich habe keine Glaskugel, sondern kann unter technisch/wirtschaftlichen Gesichtspunkten und mit stark eingeschränktem Informationsstand nur bestmöglich antizipieren und da es viele Möglichkeiten sowie auch unterschiedliche und teilweise gänzlich unbekannte Zielsetzungen seitens der Hersteller gibt, kann es oftmals dennoch anders kommen als ich denke.

Wenn man sich dein Gebaren über die letzten Monate ansieht und dein Auftreten mir gegenüber erscheinst du mir die Zeit schlicht nicht wert zu sein. Hier nur als Randbemerkung, dass bei einem Überfliegen deines Posts gleich schon etliche Punkte als leicht konter- wenn nicht gar widerlegbar erscheinen, aber da du zumindest mir gegenüber eher als der (un)heimliche Hater auftrittst ... ich kann meine Zeit zweifellos sinnvoller verwenden und überlasse es dem mündigen Leser sich hier selbst ein Bild zu machen.

Noch mal zur Klarstellung. Ampere wird in einem Prozess der 10nm-Klasse gefertigt. RDNA2 verwendet einen deutlich moderneren Node der 7nm-Klasse. Samsung's Äquivalent hierzu ist deren 7LPP, wohingegen nVidia sich jedoch mit dem 8LPP (von nVidia selbst als 8N bezeichnet) begnügt. Dass das weitere Beschränkungen auferlegt, sollte klar sein, Wenn du jetzt erklärst, dass die "6900 XT und die 3090 so ziemlich gleich auf liegen", kannst du dir leicht selbst ausrechnen, wie das aussehen würde, wenn man das Ampere-Design unverändert auf TSMCs N7(P) transferieren würde. Entsprechend sind sie hier architektonisch mindestens gleich auf, wenn nicht gar leicht führend (beim Raytracing und der ML-Performance stellt sich die Frage nicht einmal) und es bleibt schlicht zu vermuten, dass sie Margen-technisch den für sie optimalen Weg gewählt haben. Sie umgehen die Konkurrenzsituation bei TSMC und fertigen hier den Großteil ihrer Chips mit einem günstigeren Prozess und können aufgrund der großvolumigen Fertigungsübertragung hin zu Samsung voraussichtlich zusätzlich noch mit guten Konditionen rechnen.

Noch mal zur Klarstellung. Ampere wird in einem Prozess der 10nm-Klasse gefertigt. RDNA2 verwendet einen deutlich moderneren Node der 7nm-Klasse. Samsung's Äquivalent hierzu ist deren 7LPP, wohingegen nVidia sich jedoch mit dem 8LPP (von nVidia selbst als 8N bezeichnet) begnügt. Dass das weitere Beschränkungen auferlegt, sollte klar sein, Wenn du jetzt erklärst, dass die "6900 XT und die 3090 so ziemlich gleich auf liegen", kannst du dir leicht selbst ausrechnen, wie das aussehen würde, wenn man das Ampere-Design unverändert auf TSMCs N7(P) transferieren würde. Entsprechend sind sie hier architektonisch mindestens gleich auf, wenn nicht gar leicht führend (beim Raytracing und der ML-Performance stellt sich die Frage nicht einmal) und es bleibt schlicht zu vermuten, dass sie Margen-technisch den für sie optimalen Weg gewählt haben. Sie umgehen die Konkurrenzsituation bei TSMC und fertigen hier den Großteil ihrer Chips mit einem günstigeren Prozess und können aufgrund der großvolumigen Fertigungsübertragung hin zu Samsung voraussichtlich zusätzlich noch mit guten Konditionen rechnen.