Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Geforce RTX 3090: Chips für ursprünglich kolportierte RTX 3080 Ti wurden umgelabelt

- Ersteller PCGH-Redaktion

- Erstellt am

Rorschach123

PC-Selbstbauer(in)

Ne da ist auf weiter Flur nichts geplant. Bedeutet sparen und extra Socken stricken, vielleicht gibt es demnächst mal wieder ne FE in der Nähe vom OVP. Aber auf keinen Fall die Zotac nehmen, da ist die Kühllösung so unterirdisch, dass sie sogar unter der FE performtWird es von AMD bald eine Grafikkarte mit 20gb ram und mehr geben?

Ich kann mir die 3090 leider nicht leisten, brauche jedoch eine GPU mit 20gb+ ram die Raytracing kann.

Gibt es da bald eine Alternative?

Ich dachte da an so etwas wie eine AMD 6950XT mit 20gb Ram oder so.

Sozusagen ein Nvidia 3090 Gegenstück.

Todesklinge

Software-Overclocker(in)

Die 3090 Founders Edition wäre perfekt. Leider nur einmal HDMI 2.1.Ne da ist auf weiter Flur nichts geplant. Bedeutet sparen und extra Socken stricken, vielleicht gibt es demnächst mal wieder ne FE in der Nähe vom OVP. Aber auf keinen Fall die Zotac nehmen, da ist die Kühllösung so unterirdisch, dass sie sogar unter der FE performt

Oder ist das möglich daraus 2x HDMI 2.1 zu machen, weisst du da was?

Ein Anschluss brauche ich für den Monitor, einen für den Fernseher beides in 4k@120hz.

Wird es von AMD bald eine Grafikkarte mit 20gb ram und mehr geben?

Quasi ausgeschlossen. Wenn, dann wird AMD wohl in die vollen gehen und eine Karte mit 32GB rausbringen, da das Speicherinterface dies nahelegt. Es ist jedoch äußerst unwahrscheinlich, dass AMD so eine Karte auflegt, besonders, da die Nachfolgergeneration schon Ende diesen Jahres erscheinen soll.

Gibt es da bald eine Alternative?

Ich dachte da an so etwas wie eine AMD 6950XT mit 20gb Ram oder so.

Sozusagen ein Nvidia 3090 Gegenstück.

Das Gegenstück zur RTX 3090 ist die 6900XT. Wenn es wirklich eine Ultraversion geben sollte, dann wäre die sowieso extrem teuer.

Wer auf Raytracing scharf ist, der sollte eher eine Nvidiakarte nehmen.

Birdy84

Lötkolbengott/-göttin

Die 3090 Founders Edition wäre perfekt. Leider nur einmal HDMI 2.1.

Oder ist das möglich daraus 2x HDMI 2.1 zu machen, weisst du da was?

Ein Anschluss brauche ich für den Monitor, einen für den Fernseher beides in 4k@120hz.

Club 3D DisplayPort 1.4 Stecker auf HDMI 2.1 Buchse | Preisvergleich Geizhals Deutschland

✔ Preisvergleich für Club 3D DisplayPort 1.4 Stecker auf HDMI 2.1 Buchse ✔ Produktinfo ⇒ Typ: Adapter • Stecker: DisplayPort 1.4 • Buchse: HDMI 2.1 • Kabellänge: 15cm… ✔ Adapter & Adapterkabel ✔ Testberichte ✔ Günstig kaufen

Todesklinge

Software-Overclocker(in)

Auch nicht mit einem Doppelstecker so das über 2x Displayport auf 1x HDMI 2.1 geht?Adaptive Sync funktioniert darüber aber angeblich nicht.

Club 3D DisplayPort 1.4 Stecker auf HDMI 2.1 Buchse | Preisvergleich Geizhals Deutschland

✔ Preisvergleich für Club 3D DisplayPort 1.4 Stecker auf HDMI 2.1 Buchse ✔ Produktinfo ⇒ Typ: Adapter • Stecker: DisplayPort 1.4 • Buchse: HDMI 2.1 • Kabellänge: 15cm… ✔ Adapter & Adapterkabel ✔ Testberichte ✔ Günstig kaufengeizhals.de

Der Stecker macht ja nur ein Anschluss.

DARPA

Volt-Modder(in)

Never, ich würde 2022 erwarten. Ebenso für Lovelace.Es ist jedoch äußerst unwahrscheinlich, dass AMD so eine Karte auflegt, besonders, da die Nachfolgergeneration schon Ende diesen Jahres erscheinen soll.

blautemple

Kokü-Junkie (m/w)

Schon unter normalen Bedingungen wäre eine Nachfolgegeneration nach nur einem Jahr sehr optimistisch. Von Pascal auf Turing waren es zwei Jahre, genauso wie von Turing auf Ampere.Never, ich würde 2022 erwarten. Ebenso für Lovelace.

Ich gehe davon aus das es diesmal genauso sein wird. Also sollten Mitte bis Ende 2022 die Nachfolger eintrudeln.

Never, ich würde 2022 erwarten. Ebenso für Lovelace.

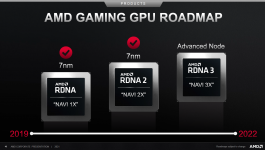

AMD hat RDNA für Ende 2021 angekündigt. Von daher wollen sie wohl wieder zurück zum jährlichen Zyklus.

DARPA

Volt-Modder(in)

Birdy84

Lötkolbengott/-göttin

Die FE hat einen HDMI 2.1 doch bereits.Auch nicht mit einem Doppelstecker so das über 2x Displayport auf 1x HDMI 2.1 geht?

Der Stecker macht ja nur ein Anschluss.

Todesklinge

Software-Overclocker(in)

Ja aber nur einen ?Die FE hat einen HDMI 2.1 doch bereits.

Birdy84

Lötkolbengott/-göttin

Plus den einen vom Adapter, den ich oben gepostet habe.Ja aber nur einen ?

Dann ist jede alte x80 TI oder gar X80 vor der ersten Titan eine "Titan Klasse" Karte...Hardware ist Titan-Klasse. Speicher kostet halt.

Die speziellen Treiber sind nur für einige Software relevant, für die meisten nicht.

Sorry, aber das ist schlicht Marketing BS.

Früher wurden die G*100 Chips in den 80er Karten verbaut - das spielt heutzutage sogar deutlich über der Titan Klasse.

Immerhin ist da nur ein 102er Chip drin.

Ergo: kompletter Marketing BS, um mehr Karten zu verkaufen.

Das EINZIGE, was eine Titan zu einer "Titan Klasse" macht, ist der Treiber.

100er und 102er Chips gab es schon früher in Grafikkarten, ohne dass die Titan hießen.

cryon1c

Lötkolbengott/-göttin

Dann ist jede alte x80 TI oder gar X80 vor der ersten Titan eine "Titan Klasse" Karte...

Sorry, aber das ist schlicht Marketing BS.

Früher wurden die G*100 Chips in den 80er Karten verbaut - das spielt heutzutage sogar deutlich über der Titan Klasse.

Immerhin ist da nur ein 102er Chip drin.

Ergo: kompletter Marketing BS, um mehr Karten zu verkaufen.

Das EINZIGE, was eine Titan zu einer "Titan Klasse" macht, ist der Treiber.

100er und 102er Chips gab es schon früher in Grafikkarten, ohne dass die Titan hießen.

Und? Früher gab es auch Triple Channel RAM. Früher gab es DualGPU Grafikkarten. SLI war n Ding.

Und vieles andere. Die Produktpaletten ändern sich, die Preisvorstellungen ändern sich. Titan wurde eingeführt damit eine wachsende Schicht an Käufern, die Content Creator die daheim und alleine arbeiten oder mit einem kleinem Team, sich passende Hardware kaufen können für GPU-Beschleunigung. Ohne auf Gaming-Funktionen und aktuelle Treiber zu verzichten. Und das ist ein Erfolgsmodell, gerade in einer Zeit wo alle daheim gammeln.

Es ist egal welcher Chip drin steckt, die Performance entscheidet.

Und nein, als Content Creator brauchste keine Quadro. Da reicht auch ne 3090 bis zum abwinken.

Genau das ist der Punkt.... Titan wurde eingeführt damit eine wachsende Schicht an Käufern, die Content Creator die daheim und alleine arbeiten oder mit einem kleinem Team, sich passende Hardware kaufen können für GPU-Beschleunigung. Ohne auf Gaming-Funktionen und aktuelle Treiber zu verzichten. Und das ist ein Erfolgsmodell, gerade in einer Zeit wo alle daheim gammeln.

GPU Beschleunigung.. mit zertifizierten Treibern zu günstigeren Preisen als Quadros.

DAS war der USP der Titan.

Und genau DAS fehlt der 3090.

Edit:

Um den Unterschied mal lesbar zu machen:

Eingebundener Inhalt

Reddit

An dieser Stelle findest du externe Inhalte von Reddit. Zum Schutz deiner persönlichen Daten werden externe Einbindungen erst angezeigt, wenn du dies durch Klick auf "Alle externen Inhalte laden" bestätigst:

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit werden personenbezogene Daten an Drittplattformen übermittelt.Für mehr Informationen besuche die Datenschutz-Seite.

Zuletzt bearbeitet:

Na ganz einfach, die RTX 3090 sollte ursprünglich RTX 3080 Ti heißen (GA102-250). Man entschied sich aber dann eine RTX 3090 daraus zu machen (GA102-300). Ganz einfach weil der Unterschied zwischen 3080 Ti und 3080 zu groß gewesen wäre und man mit 3090 und 3080 noch Spielraum für ein Zwischenmodell hat (zukünftige 3080 Ti als GA102-225).

Die Theorie erscheint mir auch schlüssiger. Wieso sollte Nvidia reihenweise Chips in 3090er-Qualität downgelabelt und eingelagert, aber nicht beschnitten haben für ein Produkt, das auf Monate hinaus nicht produziert werden sollte?

Wird es von AMD bald eine Grafikkarte mit 20gb ram und mehr geben?

Ich kann mir die 3090 leider nicht leisten, brauche jedoch eine GPU mit 20gb+ ram die Raytracing kann.

Gibt es da bald eine Alternative?

Ich dachte da an so etwas wie eine AMD 6950XT mit 20gb Ram oder so.

Sozusagen ein Nvidia 3090 Gegenstück.

Ein weiterer Chip über der 6900 ist vorerst nicht zu erwarten und die 6900 kann vom Speicherinterface her nicht sinnvoll mit 20 GiB bestückt werden. Theoretisch halte ich weiterhin die Nutzung von zwei unterschiedlichen Chips je Kanal für möglich, was dann 24 GiB ergeben würde, die nächste wahrscheinliche Stufe wären aber 32 GiB. Das wäre für sich genommen schon ein starker Kostentreiber und außerdem nur für die von Radeon Pro bedienten Märkte interessant, womit ein weiterer saftiger Aufschlag einhergehen würde. Auf eine billige 3090-Alternative innerhalb der 6000er-Generation braucht man also nicht zu hoffen. Und das gilt erst recht für Raytraycing, denn Navi20 ist eigentlich in so ziemlich jedem anderen Aspekt toll, aber genau da hat AMD Mut zur Schwäche. Sieht man mal von den Kinderkrankheiten ab (einige Spiele laufen gar nicht oder Fehlerhaft mit RT) gelingt es der 6900 in der Regel nur, ein Stückchen vor der 3070 zu bleiben. Aber bereits die 3080 liegt in weiter Ferne.

cryon1c

Lötkolbengott/-göttin

Du hast eine Sache vergessen.Genau das ist der Punkt...

GPU Beschleunigung.. mit zertifizierten Treibern zu günstigeren Preisen als Quadros.

DAS war der USP der Titan.

Und genau DAS fehlt der 3090.

GPU-Beschleunigung braucht nicht für alles einen speziellen Treiber.

Wir reden hier über NVENC und CUDA Beschleunigung.

Beides funktioniert supi ohne Titan/Quadro Treiber.

Es geht schlicht und einfach darum, die beste GPU für Videoencoding zu haben, mit ordentlich VRAM damit man auch größere Projekte da rein stopfen kann.

Braucht man Deep Learning? Nein. Braucht man spezielle Tensor-Performance dafür? Ebenfalls nein.

Genau das macht die 3090 gut. Das ist eine Karte die für Content Creator sehr gut geeignet ist, wie alle Titans davor - maximale Performance in Spielen, maximale Performance bei der GPU-Beschleunigung in Anwendungen die CUDA nutzen, ein guter Encoder für Livestreams, ein Preis den ein Solo-Selbstständiger noch bezahlen kann. Und oben drauf kein Blower-Design mehr weil das Ding nicht in nem Server-Rack sitzen muss.

Und genau dafür wird die Karte gekauft.

Das reine Gamer auf diese Karte scharf sind, verstehe ich nicht - die haben ihre 3080 und irgendwann auch 3080Ti die 95%+ Performance für wesentlich weniger Geld bieten

Birdy84

Lötkolbengott/-göttin

Niemand hat gesagt, es gäbe kein Einsatzgebiet für die Karte. Nvidia hat die Karte nicht ausversehen 3090 anstatt Titan genannt, das muss doch offensichtlich sein.Du hast eine Sache vergessen.

GPU-Beschleunigung braucht nicht für alles einen speziellen Treiber.

Wir reden hier über NVENC und CUDA Beschleunigung.

Beides funktioniert supi ohne Titan/Quadro Treiber.

Es geht schlicht und einfach darum, die beste GPU für Videoencoding zu haben, mit ordentlich VRAM damit man auch größere Projekte da rein stopfen kann.

Braucht man Deep Learning? Nein. Braucht man spezielle Tensor-Performance dafür? Ebenfalls nein.

Genau das macht die 3090 gut. Das ist eine Karte die für Content Creator sehr gut geeignet ist, wie alle Titans davor - maximale Performance in Spielen, maximale Performance bei der GPU-Beschleunigung in Anwendungen die CUDA nutzen, ein guter Encoder für Livestreams, ein Preis den ein Solo-Selbstständiger noch bezahlen kann. Und oben drauf kein Blower-Design mehr weil das Ding nicht in nem Server-Rack sitzen muss.

Und genau dafür wird die Karte gekauft.

cryon1c

Lötkolbengott/-göttin

Niemand hat gesagt, es gäbe kein Einsatzgebiet für die Karte. Nvidia hat die Karte nicht ausversehen 3090 anstatt Titan genannt, das muss doch offensichtlich sein.

Der Name Spielt schon lange keine Rolle mehr, nur die Leistung und entsprechende Funktionen.

Nvidia ist halt Lichtjahre voraus was bestimmte Funktionen angeht wie DLSS, NVENC und CUDA, deswegen sehen die keinen Druck von AMD und können ihre Produkte so gestalten wie sie lustig sind ohne nennenswerte Konkurrenz

Ähnliche Themen

- Antworten

- 49

- Aufrufe

- 3K

- Antworten

- 19

- Aufrufe

- 845

- Antworten

- 5

- Aufrufe

- 452

- Antworten

- 13

- Aufrufe

- 946

- Antworten

- 20

- Aufrufe

- 1K