Jetzt ist Ihre Meinung gefragt zu Geforce RTX 3080 Ti: GPU-Z-Validierung bestätigt technische Eckdaten

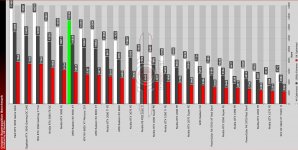

Die GPU-Z-Validierung für die Geforce RTX 3080 Ti bestätigt technische Eckdaten. Die Karte ist damit recht nah an der großen Schwester dran und könnte diese auch schlagen, je nach Anwendung und Custom-OC. Der größte Unterschied ist die Speicherausstattung.

Bitte beachten Sie: Der Kommentarbereich wird gemäß der Forenregeln moderiert. Allgemeine Fragen und Kritik zu Online-Artikeln von PC Games Hardware sind im Feedback-Unterforum zu veröffentlichen und nicht im Kommentarthread zu einer News. Dort werden sie ohne Nachfragen entfernt.

Zurück zum Artikel: Geforce RTX 3080 Ti: GPU-Z-Validierung bestätigt technische Eckdaten

Zurück zum Artikel: Geforce RTX 3080 Ti: GPU-Z-Validierung bestätigt technische Eckdaten

Die GPU-Z-Validierung für die Geforce RTX 3080 Ti bestätigt technische Eckdaten. Die Karte ist damit recht nah an der großen Schwester dran und könnte diese auch schlagen, je nach Anwendung und Custom-OC. Der größte Unterschied ist die Speicherausstattung.

Bitte beachten Sie: Der Kommentarbereich wird gemäß der Forenregeln moderiert. Allgemeine Fragen und Kritik zu Online-Artikeln von PC Games Hardware sind im Feedback-Unterforum zu veröffentlichen und nicht im Kommentarthread zu einer News. Dort werden sie ohne Nachfragen entfernt.

.gif)

Aber wurde nicht schon das eine oder andere mal erwähnt, dass

Aber wurde nicht schon das eine oder andere mal erwähnt, dass

Mein letzter Stand war, das Nvidia den Chip nur verkaufen wollte und keine eigenen Karten damit bringt. Aber der Kühler sieht wirklich mager aus, eher wie 2 Slot design. Der kann auf keine hohe TDP ausgelegt sein.

Mein letzter Stand war, das Nvidia den Chip nur verkaufen wollte und keine eigenen Karten damit bringt. Aber der Kühler sieht wirklich mager aus, eher wie 2 Slot design. Der kann auf keine hohe TDP ausgelegt sein. Kann mir nur vorstellen, das Nvidia zwar GA102 Chips zur Verfügung hat aber nicht nicht genug VRAM Chips um Sie zu bestücken.

Kann mir nur vorstellen, das Nvidia zwar GA102 Chips zur Verfügung hat aber nicht nicht genug VRAM Chips um Sie zu bestücken.