Birdy84

Lötkolbengott/-göttin

Aber doch nicht mit Vollast über 8-16 Threads.BF V nützt meines Wissens nach AVX. Insofern also nicht realitätsfern.

Aber doch nicht mit Vollast über 8-16 Threads.BF V nützt meines Wissens nach AVX. Insofern also nicht realitätsfern.

Also Ergbnis war jetzt.... nichts. Alles lief, keine Fehlermeldung

Sowohl AMD als auch Nvidia haben die Fehler im Treiber behoben, wenn AVX OS-seitig abgeschaltet wird. Ich hab's selbst überprüft. Man kann dennoch einige interessante Dinge damit untersuchen.

1. Cinebench R20 nutzt gar nicht mal sooo ausgiebig AVX Instruktionen

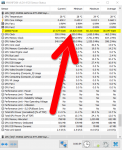

Anhang anzeigen 1089582

Der höhere Wert ist natürlich mit AVX on.

2. Battlefield V wird signifikanter schneller, wenn AVX abgeschaltet wird. Das ist allerdings überraschend, gerade auch deswegen, weil ich bei der Bildqualität keine Unterschiede feststellen konnte. Ich hab's allerdings auch in 720p gebencht. Das kann so was durchaus untergehen. Das wäre was für Raff's geschultes Auge.

Ergebnisse: AVX on vs. off

3. Der AVX Bench von CPU-Z verschwindet aus der Combobox, wenn AXV abgeschaltet wird. Daran sieht man auch, dass das Setting tatsächlich was bewirkt.

Ich probiers heute Abend nochmals

Kann man dennoch nicht alles unter einem Teppich kehren, denn mit meinem 9900K habe ich innerhalb von zwei Jahren seit ich ihn habe noch keine Anwendung gehabt was mehr als 140-160 Watt zieht und solche Anwendungen kommen bei mir in einem halben Jahr vielleicht nur 1-2 mal vor.Stimmt - aber es gibt durchaus Leute, die mit ihrem PC andere Dinge tun als Spielen. Ehrlich, das gibts!

Und jetzt stell dir vor, wenn du ein 4K-Video in HEVC wandelst verbrauchen sowohl Intel als auch AMD-CPUs genauso viel wie im LinPack Xtreme - nämlich ihr volles erlaubtes Powerbudget. Im realen Leben, mit echten Programmen.

Genau und das läuft bei AMD momentan noch beschissen.Idle hängt halt maßgeblich am Board, bzw Zusatz-Hardware.

Bzgl. des CB R20 Benchmarks sollte man auch den Takt mal fixieren, fiel mir im Nachhinein noch so ein. Bei BF V gibt's keine Unterschiede beim Takt, siehe die Diskussion bei Twitter.

Denn die Grafikkarte kommen bei ihm mit zwei Monitore auf etwa 54 Watt und mit nur einem Monitor auf 25 Watt. Auf 25 Watt komme ich mit meiner 2080 Super auch hin und er hat zwar ein anderen Hersteller verbaut, aber es handelt sich auch um eine 2080 Super.

Auf 10 Watt komme ich mit meinem 9900K und nur ein Bildschirm auch nicht hin.Sorry, wenn das etwas off-topic sein sollte, aber versteh ich das richtig, dass die Graka im Idle pro Monitor 25 Watt verbraucht bei deinem Sohn? Oder hab ich das was falsch verstanden? Weil bei mir idelt' die 2080ti mit 10 Watt, daher wundert mich das etwas.