Wo steht ihr jetzt, nachdem ihr euch die Tests zu Gemüte geführt habt?

Ich möchte zum aktuellen Zeitpunkt noch gar nicht wirklich bewerten.

Irgendwo wusste ich, dass uns eine Zwischen-Gen erwartet, die es schwer haben würde an vergleichbare Entwicklungssprünge wie seiner Zeit RDNA 2, wo die Konsolenhersteller mitgewirkt haben, anzuknüpfen.

Dazu kommt der schwierige Wechsel auf eine MCM-Bauweise, der zwar grundlegend geglückt scheint, aber momentan wohl noch den ein oder andern Kompromiss mit sich bringt, siehe Idle-Leistungsaufnahme.

Und da komm ich dann an einen Punkt wo ich etwas knöterig werde, weil das war von AMD so garantiert nicht gewollt und das hätten Sie besser hinbekommen müssen.

Könnt was dran sein, dass Sie die MCD´s bei hoher Bildwiederholrate nicht komplett schlummern lassen können und wäre extrem unglücklich, sofern sich das mit einem Update nicht noch regeln lässt.

Sowas hängt dir echt schnell nach..

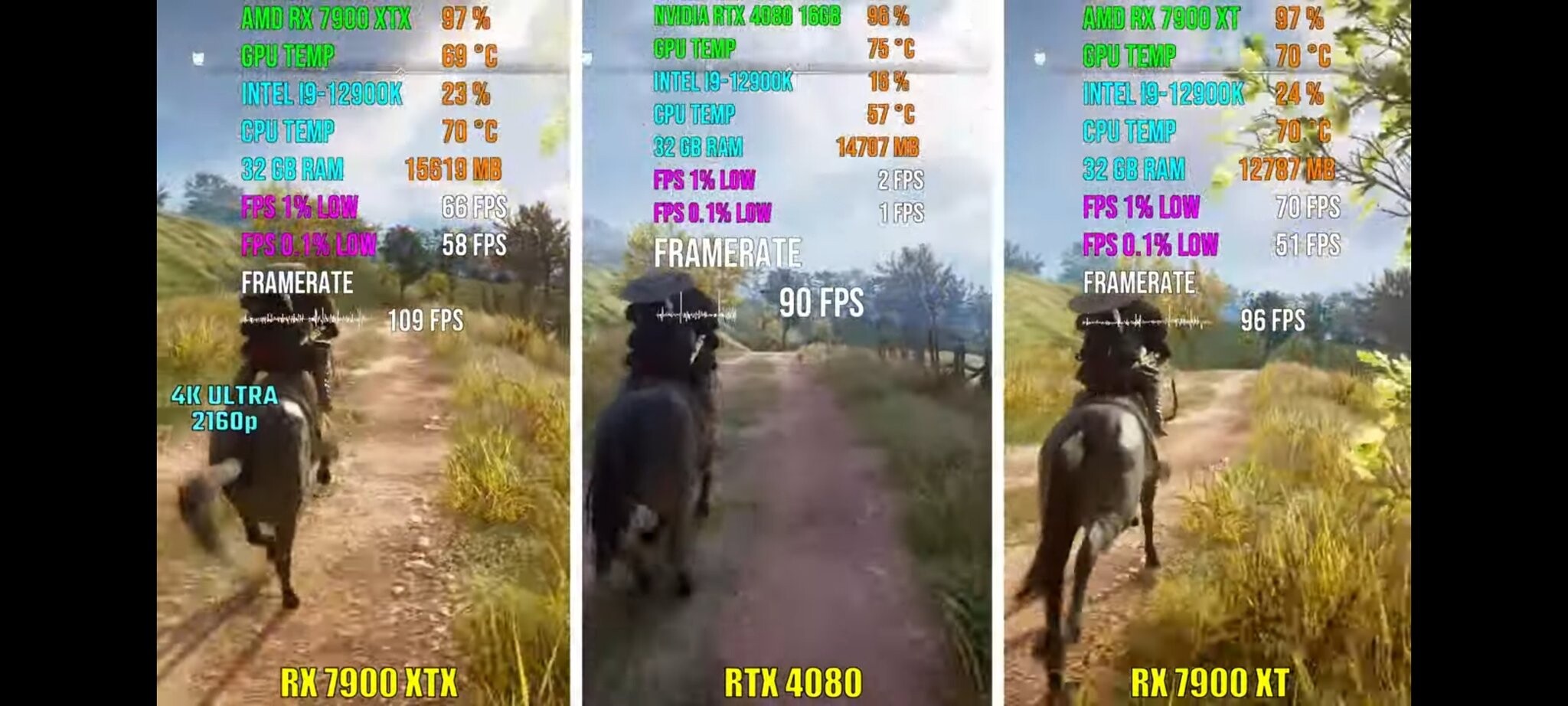

Die Performance allgemein, keine Frage, mehr als wohl jeder Normalo braucht und dann noch zu einem besseren Preispunkt als der Mitbewerb aktuell bietet.

Um mit dem Produkt am Ende jedoch aktuelle Marktanteile zu halten oder gar auszubauen, dafür muss der Preis in Q1/2023 meiner Meinung nach nochmal um gut 200-300€ runter, denn augenblicklich fehlt mir hier noch ein wenig das Salz in der Suppe.

Schwadronier aber natürlich auch mit einer 6900 neben mir und damit fehlt es halt an wenig.

Einen Preisrutsch bei den 7900érn könnte ich mir kommendes Jahr echt früh vorstellen und ich glaub AMD hat da auch ausreichend Luft für.

www.techpowerup.com