Klar, beim Stresstest und bei der Punktejagd muss man eine potente Kühlung besitzen, aber davon spricht hier ja keiner.

Und sofern @taz81 einfach nur zocken will, sehe ich da gar kein Problem.

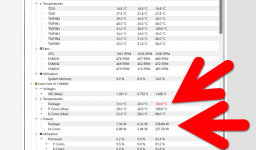

PL1 und PL2 könnte man ja noch etwas reduzieren, für das gute Gewissen und ohne dass man Leistung verliert.

Und sofern @taz81 einfach nur zocken will, sehe ich da gar kein Problem.

PL1 und PL2 könnte man ja noch etwas reduzieren, für das gute Gewissen und ohne dass man Leistung verliert.