Darauf hat die Welt gewartet...

Zumindest Apple hat das vermutlich und als Intel nicht liefern konnte, haben sie sich wohl nach etwas anderem umgesehen und es dann selbst in die Hand genommen.

Darauf hat die Welt gewartet...

Die Strategie hinter der Kombination dürfte klar sein: Atom-Kerne können leichte Workloads erledigen oder in Lastszenarien Aufgaben, die keine volle Core-Power brauchen, während die Core-Kerne die großen Brocken schlucken. Das Konzept ist auf Smartphones mit ARM-Prozessoren in Big Litte-Format seit langem erfolgreich. Auf x86/64-Mobile dürfte das Konzept vermutlich aufgehen; ob sich das auf den Desktop umlegen lässt, wird man sehen.

Warum erfindest du so etwas?Amd hat das 8+8 Design ja als Blödsinn abgetan...

Hat Alder Lake auch SMT?

Amd hat das 8+8 Design ja als Blödsinn abgetan...

Nein, das ist keine Frage (mehr)Zumindest die großen Kerne sollen SMT fähig sein. Wobei die große Frage immer noch ist, ob die CPU AVX 512 unterstützt, da die Atomkerne es nicht können und Intel AVX 512 deshalb angeblich deaktivieren möchte, um Problemen aus dem Weg zu gehen. Das wäre, gegenüber Rocketlake, ein klarer Rückschritt. [...]

Bestätigt ist es dennoch noch nicht - auch wenn quasi alles darauf hin deutet und es absurd wäre das jetzt schon zu versuchen wenn es bei ARM nach so vielen Jahren noch nicht klappt.Wie erklärt, das ist eine unified ISA, d. h. die Atom-Kerne unterstützen den gleichen Befehlssatz wie die Golden Cove-Kerne, d. h. die Last bzgl. dieser Unterscheidung wurde hier schon eliminiert. Der OS-Scheduler muss nur noch entscheiden ob schnell (und mit SMT) oder ob langsam und effizient (ohne SMT).

Da gabs schon so viele Leaks dazu - es wird ziemlich sicher Konfigurationen von 2+8+1 bis 8+0+1 geben. Und 2+8+2 wäre für Mobile-Devices verdammt interessant (man kann nur hoffen das die wirklich kommen).Zudem zeigte Igor im Juli auch mal einen Auszug, der darauf hindeutete, dass es möglicherweise CPU-Varianten ohne Atom-Kerne geben könnte.

80W im Idle sind eher Threadripperwerte. Etwa 40W sind ein solider AM4-CPU-Wert.Wenn Intel im Idle (Surfen im Netz) den ganzen Rechner mit 20W laufen lassen kann, dann haben die gewonnen...

Amd hat das 8+8 Design ja als Blödsinn abgetan... Dummerweise verbraucht aber ein 5900X+MB ganze 80W im IDLE! Intel wird mit Alder-Lake massiv an Boden gewinnen.

Was ist eigentlich aus der Idee geworden, die GPU im Desktopbetrieb abzuschalten? Den Monitor schließt man über die interne GPU an und schleift im Bedarf das PCIe-GPU Signal durch.

Wurde leider nie richtig umgesetzt, könnte im Desktopbetrieb locker -15W sparen.

Das ist HÖCHST interessant, lese ich hier zum ersten Mal (aber jetzt kenne ich dich ja schon ein bisschen, du schreibst soweit ich das sehen konnte immer faktenbezogen). Wär für mich etwa ein klarer Grund gegen Alder Lake (gut... ich war vorher auch nur auf IPC gespannt, kaufen würde ich sowieso nur "große" Kerne. Die kleinen eher nur im Notebook)Nein, das ist keine Frage (mehr)

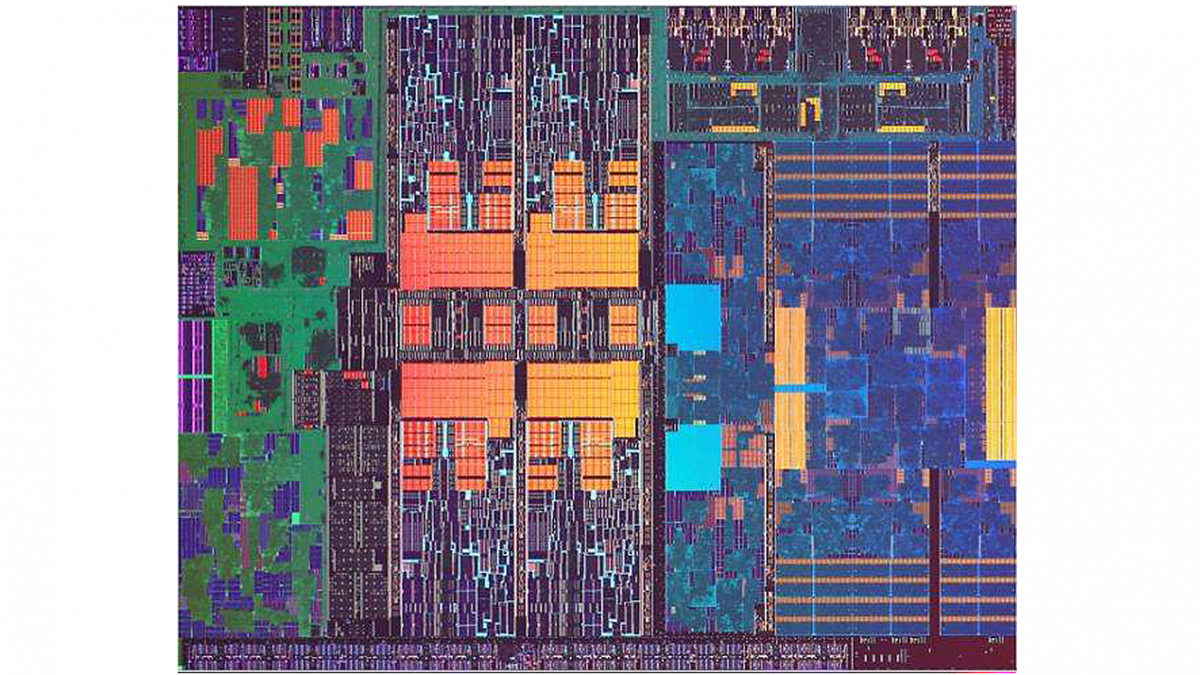

AVX-512 wird es hier nicht geben (voraussichtlich nur deaktiviert, da an den Scheduler Ports 0 + 1 bisher jeweils eine 256-Bit-Einheit hängt, die kombiniert die primäre 512-Bit-Einheit ergibt. *)

Das Maximum in Alder Lake ist AVX2-Support und man vereinheitlicht die ISA, indem auch die Gracemont-Kernen nun AVX2 beherrschen (anstatt nur SSE). Zusätzlich hinzu, weil man darauf nicht mehr verzichten möchte, kommt nun eine 256-Bit-Version von VNNI für ML-Workloads.

Golden Cove als Mikroarchitektur wird zweifelslos weiterhin über eine vollwertige AVX-512-Unterstützung verfügen und voraussichtlich auch mit bfloat16-Support (mit Cooper Lake SP eingeführt, in Ice Lake SP fehlt es jedoch), denn die uArch stellt auch die Basis von Sapphire Rapids SP dar.

*) Bei den Xeon-Dies wurde ab Syklake zusätzlich noch eine weitere 512-Bit-Einheit an den Scheduler Port 5 angehängt, die optional ist und in der jeweiligen uArch nur auf den Xeon-Dies (grundsätzlich) vorhanden ist. Bei den kleineren Xeon's deaktiviert Intel diese Einheit aus Gründen der Produktdiversifikation (und auch auf den Core X-Ablegern hatte man die bisher grundlegend aktiviert belassen). Für Sapphire Rapids SP kann man ein ähnliches Vorgehen erwarten (d. h. weitestgehend zwei aktive AVX-512-FMA-Einheiten pro CPU-Kern und damit weiterhin theoretische bis zu 32 Flops FP64-Durchsatz pro Kern und Taktschritt).

@Casurin: Wie erklärt, das ist eine unified ISA, d. h. die Atom-Kerne unterstützen den gleichen Befehlssatz wie die Golden Cove-Kerne, d. h. die Last bzgl. dieser Unterscheidung wurde hier schon eliminiert. Der OS-Scheduler muss nur noch entscheiden ob schnell (und mit SMT) oder ob langsam und effizient (ohne SMT).

Wie Torsten schon mal zuvor skizzierte, würde es sich anbieten die ganzen Hintergrundprozesse auf die Atom's zu legen und bspw. damit die großen Kerne komplett für die App im Vordergrund freizuhalten und voraussichtlich werden (bei einem 8+8 Design) auch noch ein paar Atom's freibleiben, die man optional auch noch der App zuweisen könnte, wenn man eine maximale Performance anstrebt.

Zudem zeigte Igor im Juli auch mal einen Auszug, der darauf hindeutete, dass es möglicherweise CPU-Varianten ohne Atom-Kerne geben könnte. Konkret fand sich hier ein 6+0+1 Design, also 6x Golden Cove, kein Atom und eine iGPU. Ob das aber noch aktuell ist, bleibt abzuwarten, denn in dem Auszug war auch von einem AVX-512-Support auf den Golden Cove-Kernen die Rede (der ja grundsätzlich durchaus exisitiert), was man nun aber nachträglich offensichtlich wegrationalisiert (deaktiviert) hat, um ein einfacheres Handling der gemischten Kerne zu ermöglichen. (Entsprechend neu ist auch die Einführung von 256-Bit-VNNI, dessen Einführung voraussichtlich ein Resultat dieser Streichung war.)

Faktenbezogen ... da das hier ein Technikforum ist, halte ich das i. d. R. für die sinnvollste Art zu diskutieren. Wäre ich in der Marketingabteilung einer der beiden großen Firmen, würde ich da wohl etwas umdenken müssen, denn zuweilen geht es da auch mehr um Gefühl und Wellenschlag als um harte, technische Fakten. Letzten Endes ist das aber z. G. nicht mein Metier, sodass ich mir auch ohne Gewissensbisse, die Hardware einbauen kann, die gerade am besten meinen Ansprüchen genügt, ob die nun rot, grün, blau oder lila ist, ist mir da herzlich egal.Das ist HÖCHST interessant, lese ich hier zum ersten Mal (aber jetzt kenne ich dich ja schon ein bisschen, du schreibst soweit ich das sehen konnte immer faktenbezogen). Wär für mich etwa ein klarer Grund gegen Alder Lake (gut... ich war vorher auch nur auf IPC gespannt, kaufen würde ich sowieso nur "große" Kerne. Die kleinen eher nur im Notebook)

Ich würde hier eher die Vermutung in den Raum stellen wollen, dass es Apple weit mehr darum ging die Wertschöpfungskette weitreichender zu kontrollieren und mittelfristig die Marge zu erhöhen und dazu gehört es nun einmal die Abhängigkeiten zu verringern. AMD ist ja grundlegend mit seinen APUs auch auf einem guten Weg und nutzte bereits eine modernere Fertigung in 2019 (i. V. z. Intel), jedoch war das offensichtlich Apple nicht genug, da man letzten Endes nur einen Zulieferer gegen einen andere ausgetauscht hätte und so hat man auch AMD einen Korb gegeben und der wird am Ende gar auch ein vollständiger Korb werden, denn Apple entwickelt auch an einer eigenen Grafik-IP, d. h. absehbar wird Apple für AMD auch als Kunde für GPUs wegfallen. *)Zumindest Apple hat das vermutlich [auf eine derartige CPU gewartet] und als Intel nicht liefern konnte, haben sie sich wohl nach etwas anderem umgesehen und es dann selbst in die Hand genommen.

Mein 5900X mit B550 Board und 4SSDs braucht 80W im Idle und 100W wenn ich den Random Reboots minimieren will. Habe deshalb jetzt Board und CPU getauscht.80W im Idle sind eher Threadripperwerte. Etwa 40W sind ein solider AM4-CPU-Wert.

Siehe z.B. hier: https://www.computerbase.de/2020-11/amd-ryzen-5000-test/6/

Na gut, mit dem Surfen im Netz, was du in Klammern (aber nur bei Alder Lake, nicht beim Vermeer!) nachgeschoben hast, findest du sicherlich irgendein Szenario, indem die 80W erreicht werden.

Für AlderLake wäre 20W im Idle wäre immer noch kein guter Wert. Mein persönlicher Maßstab für die nächsten Plattformen, also AM5 und LGA1700, sind <5W im Idle. Sowenig ist bei Notebooks mitsamt Display erreichbar, das muss auch im Desktop gehen. Dafür ist auch kein Hexenwerk nötig, sondern nur disziplinierende Vorgaben für die Boardhersteller sowie eine solide praxistaugliche DualGraphics-Lösung auf Basis einer sinnvoll ausgelegten iGPU in jedem Prozessor. Anders gesagt: Wo ein Wille ist, ist auch ein Weg; in diesem Fall sogar ein sehr klarer. Wird der Weg nicht gegangen, dann gibt es genügend Anlass, verstimmt zu sein!

Korrigiere mich bitte, wenn ich falschliege (am besten mit Link), aber meines Wissens hat sich AMD darüber bisher nicht geäußert.

Ich würde hier eher die Vermutung in den Raum stellen wollen, dass es Apple weit mehr darum ging die Wertschöpfungskette weitreichender zu kontrollieren und mittelfristig die Marge zu erhöhen und dazu gehört es nun einmal die Abhängigkeiten zu verringern. AMD ist ja grundlegend mit seinen APUs auch auf einem guten Weg und nutzte bereits eine modernere Fertigung in 2019 (i. V. z. Intel), jedoch war das offensichtlich Apple nicht genug, da man letzten Endes nur einen Zulieferer gegen einen andere ausgetauscht hätte und so hat man auch AMD einen Korb gegeben und der wird am Ende gar auch ein vollständiger Korb werden, denn Apple entwickelt auch an einer eigenen Grafik-IP, d. h. absehbar wird Apple für AMD auch als Kunde für GPUs wegfallen. *)

*) Möglicherweise Codename "Lifuka". Details sind noch nicht bekannt und möglicherweise handelt es sich vorerst dabei nur um eine Art iGPU, jedoch kann man sich leicht ausrechnen, dass es in dem Falle nicht allzu lange dauern wird, bis man das Design auch auf größere, dedizierte GPUs erweitern wird.

Relativ betrachtet bestimmt. Aber jetzt rechne das mal auf 10 - 20 Jahre * die Anzahl der Geräte weltweit hoch, was hier unnötig Strom verbrannt wird.Naja: im Ausgeschalteten Zustand zieht mein PC hier etwa 3W, wenn ich jetzt noch ein Handy anhänge natürlich dementsprechend mehr (weil es lädt), auch deutlich mehr, als würde ich das Handy am Stecker betreiben (weil Netzteile bei geringer Last oft ineffizient sind).

Der Mac meiner Frau zieht im Ausgeschalteten Zustand auch so ca 3.5W, im Standby wiederum braucht mein Laptop und ihr Macbook ca 0.4W.

In dem Fall ist Standby also durchaus eine Lösung.

Das ist in der Tat gigantisch. 80W idle?Mein 5900X mit B550 Board und 4SSDs braucht 80W im Idle und 100W wenn ich den Random Reboots minimieren will. Habe deshalb jetzt Board und CPU getauscht.

Hier realistische Werte:

Anhang anzeigen 1350718

Intel und AMD müssen hier echt mal was machen.

PCs sollten im IDLE nicht mehr als 20W verbrauchen...

Ja wie gesagt: die meisten PCs brauchen auch Strom, nur weil sie angesteckt (auch ausgeschaltet) sind und kaum mehr im Standby. Da wär am besten sie gleich auch auszustecken. Macht nur niemandRelativ betrachtet bestimmt. Aber jetzt rechne das mal auf 10 - 20 Jahre * die Anzahl der Geräte weltweit hoch, was hier unnötig Strom verbrannt wird.

Bin ich niemand?Ja wie gesagt: die meisten PCs brauchen auch Strom, nur weil sie angesteckt (auch ausgeschaltet) sind und kaum mehr im Standby. Da wär am besten sie gleich auch auszustecken. Macht nur niemand

Es machen nur die wenigen GutenBin ich niemand?

Naja, Mehrfachsteckdosen sind schon ziemlich populär...(...) Ja wie gesagt: die meisten PCs brauchen auch Strom, nur weil sie angesteckt (auch ausgeschaltet) sind und kaum mehr im Standby. Da wär am besten sie gleich auch auszustecken. Macht nur niemand

dann muss es wohl jeder so machen wie bei dem haushalt wo ich bei meinen eltern wohne.Einfach überall Mehrfachsteckdosen anbringen.Sobald nicht benötigt,einfach ausschalten und dann umschalten.So braucht es gar kein Strom mehr.Das ist in der Tat gigantisch. 80W idle?

Ich hab hier 60, aber das auf einem 12 Jahre alten i7, der hat noch nicht viel vom Stromsparen gehalten...

Ja wie gesagt: die meisten PCs brauchen auch Strom, nur weil sie angesteckt (auch ausgeschaltet) sind und kaum mehr im Standby. Da wär am besten sie gleich auch auszustecken. Macht nur niemand

das einzige was du interessant findest ist das du jetzt wieder einen weiteren Punkt nicht verstanden hast aber zum hetzen gegen Intel verwenden wirst - oder ist jetzt auch jede AMD-CPU unten durch weil sie kein AVX512 unterstützen?Das ist HÖCHST interessant, lese ich hier zum ersten Mal (aber jetzt kenne ich dich ja schon ein bisschen, du schreibst soweit ich das sehen konnte immer faktenbezogen). Wär für mich etwa ein klarer Grund gegen Alder Lake (gut... ich war vorher auch nur auf IPC gespannt, kaufen würde ich sowieso nur "große" Kerne. Die kleinen eher nur im Notebook)