Acgira

BIOS-Overclocker(in)

Gegen die 3090TI hilft nur dem inneren Drang zu widerstehen, unbedingt und jederzeit die schnellste Grafikkarte der Welt besitzen zu wollen.Kann man sich die Karte leisten?

Möchte man sich die Karte leisten?

Hab ich nen wirklichen Mehrwert?

Außer man schwimmt in soviel Geld, dass man sich zB ganz Schottland oder was anderes kaufen könnte, dann ist das natürlich sowas von total egal.

Ich bin mit der 3090 so zufrieden, ich würde sie niemals weggeben und stattdessen eine 3090TI haben wollen. Selbst der zu erwartende Leistungszuwachs von Lovelace überzeugt mich derzeit nicht in 6 bis 7 Monaten auf ein "neues Pferd" zu setzen. (Die 3090TI ist ein Reizthema zumindest kann ich wie bei leckeren Süßwaren nicht damit aufhören mir Was-Wäre-Wenn-Szenarien auszumalen; zum Glück kostet das ja kaum was nur die Stromkosten bei Idle-Betrieb.)

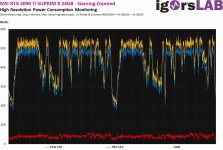

Ziemlich perverser Abstand zu den Salvage-GPUs. Allerdings zieht das Ding selbst mit dieser Spannung in den richtigen 4K-/5K-Stresstests noch über 400 Watt (u. a. Cyberpunk 2077, Mexodus EE oder Kena). Wenn das jetzt über Stunden läuft, kann ich nicht widerstehen.

Ziemlich perverser Abstand zu den Salvage-GPUs. Allerdings zieht das Ding selbst mit dieser Spannung in den richtigen 4K-/5K-Stresstests noch über 400 Watt (u. a. Cyberpunk 2077, Mexodus EE oder Kena). Wenn das jetzt über Stunden läuft, kann ich nicht widerstehen.